Target, wat?

Target, wat?

Borstkanker of mammacarcinoom is een van de meest voorkomende tumoren bij de vrouw. België staat in vergelijking met andere landen in Europa op de hoogste plaats voor de diagnose borstkanker. Borstcarcinoom werd vroeger als één diagnose gezien, in de jaren zestig is daar verandering in gekomen.

Nieuwe ontdekkingen

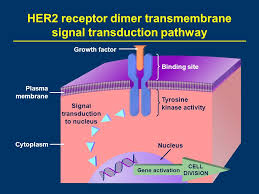

Er werd een onderscheid gemaakt tussen een hormonaal en een niet hormonaal gevoelig borstcarcinoom. In het jaar 2000 ontdekte men het bestaan van de HER één en HER twee receptoren met daarin nog verschillende subgroepen.

Dankzij deze ontdekkingen is een nieuwe soort therapie ontwikkeld, namelijk de doelgerichte of ook wel target therapie genaamd. De werking van deze middelen is gericht op de intracellulaire signaaltranductieroutes. Signaaltransductie is de wijze waarop cellen met elkaar communiceren, de cellen gaan signalen uit de omgeving herkennen en deze doorgeven in de cel. Uiteindelijk kan de signaaltransductie een verandering in de cel bekomen, dit kan een invloed hebben op het ontstaan en het voortbestaan van het borstcarcinoom.

Bijwerkingen?

In dit onderzoek werd onderzocht of verpleegkundigen voldoende kennis hebben omtrent de bijwerkingen van deze specifieke therapie. De bijwerkingen van target therapie verschillen namelijk van de klassieke chemotherapie. Als verpleegkundige op een oncologische dienst is het dan ook belangrijk om deze bijwerkingen te kunnen herkennen. De meest gekende bijwerkingen zijn nausea (misselijkheid), braken en diarree, er zijn echter nog tal van andere belangrijke kenmerken waarvan de verpleegkundigen onvoldoende kennis hebben. De bijwerkingen van target therapie kunnen een belangrijke invloed hebben op de levenskwaliteit van de patiënt. Het is dan ook van belang dat verpleegkundigen deze kenmerken tijdig observeren en dit kunnen melden aan de behandelende geneesheer.

De belangrijkste vraag die hierbij ontstaat is: “Hoe is het gesteld met de kennis omtrent target therapie en wat kan men doen om gerichte informatie (omtrent de bijwerkingen) aan te bieden aan de patiënt?”

Verpleegkundige kennis

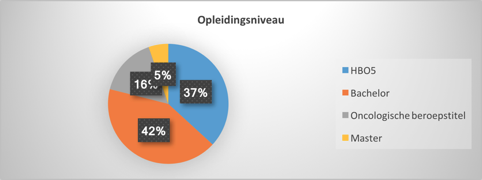

Om de kennis van de verpleegkundigen te testen werd een vragenlijst met 26 vragen opgesteld. De vragen werden verdeeld in volgende items: algemene vragen omtrent target therapie, toediening van target therapie en vragen met betreffende de bijwerkingen van target therapie. Aan deze vragenlijst werkten 19 verpleegkundigen mee. Het opleidingsniveau van de verpleegkundigen is verduidelijkt a.d.h.v. onderstaande grafiek.

Vanuit een algemene waarneming van de resultaten blijkt dat gemiddeld 69% van de verpleegkundigen op de dienst oncologie een onvoldoende aan kennis vertoont omtrent target therapie bij een HER 2 gevoelig borstcarcinoom.

In de opdeling van de vragenlijst kan bij de algemene vragen een gemiddeld kennistekort van 88% geconstateerd worden. Bij de vragen omtrent de toediening van target therapie is het gemiddelde resultaat 61% en kan er geconstateerd worden dat de verpleegkundigen moeite of geen idee hadden wat te antwoorden op de kennisvragen.

Bij de vragen omtrent de bijwerkingen die kunnen ontstaan tijdens target therapie is een kennistekort met een gemiddelde score van 59% op te merken.

Deze algemene waarneming van uit de bekomen resultaten wijst erop dat 69% van de verpleegkundigen een onvoldoende aan kennis heeft. Volgens de literatuur moeten verpleegkundigen zich bewust zijn van de behandelingsmogelijkheden en bijwerkingen binnen de HER 2 gevoelig borstcarcinoom. Deze bewustwording is noodzakelijk om gericht te kunnen handelen naar de patiënt onder target therapie. Verpleegkundigen moeten dan ook vertrouwd zijn met de indicatie, werking, gebruik, voorzorgsmaatregelen en bijwerkingen gedurende de toediening van target therapie. Hierbij is een goede uitleg van de verpleegkundige essentieel om goede instructies omtrent medicatie, behandelingsschema en de mogelijk bijwerkingen die kunnen ontstaan mee te delen.

En nu?

Uit deze score kunnen we aannemen dat deze bewustwording nog niet aanwezig is en hierbij gericht handelen naar de patiënt belemmerd wordt.

De onvoldoende kennis heeft een negatieve invloed op de levenskwaliteit van de patiënt.

Het algemeen beeld is zeer ongunstig, dit door het feit dat de verpleegkundige aandachtspunten niet gekend zijn (toedieningswijze, herkennen van bijwerkingen, etc.). Het informeren en instrueren van patiënten onder target therapie is hierdoor ook belemmerd.

Het ontbreken van kennis is een duidelijk gesteld probleem die verder moet opgevolgd worden.

Met deze resultaten in het achterhoofd is het dan ook noodzakelijk om te zorgen voor een aangepaste en doelgerichte aanpak. Dit kan bekomen worden door gerichte bijscholing te voorzien voor de verpleegkundigen werkzaam op een oncologische dienst. Dit alles om een positief effect op de levenskwaliteit van de oncologische patiënt te bekomen.

Bibliografie

Barton-Burke, M., Ciccolini, K., Mekas, M. and Burke, S. (2017). Dermatologic Reactions to Targe ted The rapy A Focus on Epidermal Growth Factor Receptor Inhibitors and Nursing Care. 1st ed. [ebook] New york: Nursing clinics, pp.83-113. Geraadpleegd op 18 november. 2017 via https://ac-els-cdn-com.kuleuven.ezproxy.kuleuven.be/S0029646516300779/1….

Becze, E. (2007). Targeted Therapies in Breast Cancer: Challenging Questions From Oncology Nurses. Oncology Nursing Society, [online] 22(8), pp.31-2. Geraadpleegd op 26 Oktober 2017 via https://search-proquest-com.kuleuven.ezproxy.kuleuven.be/docview/222745….

Bloemena, E. (2008). Kanker en oncogenese. Nederlands Tijdschrift Tandheelkude, [online] 115, pp.180 - 181. Geraadpleegd op 19 oktober 2017 via http://file:///Users/annbonheure%201/Downloads/kanker_en_oncogenese.pdf.

Bonny, M., Buyse, V. and Brochez, L. (2011). DERMATOLOGICAL SIDE EFFECTS OF CURRENT AND UPCOMING TARGETED THERAPIES IN ONCOLOGY. Medical Sciences, [online] 66(2), p.7. Geraadpleegd op 15 november 2017 via https://search-proquest-com.kuleuven.ezproxy.kuleuven.be/docview/962427….

Bourdeanu, L. and Luu, T. (2013). Nursing Perspectives on Trastuzumab Emtansine for the Treatment of Metastatic Breast Cancer. Clinical Journal of Oncology Nursing, [online] 17(5), pp.E58-E62. Geraadpleegd op 26 oktober 2017 via https://search-proquest-com.kuleuven.ezproxy.kuleuven.be/docview/146240….

Boven, E. en Ossenkoppele, G. (2011). Targeted therapieën tegen kanker. Huisarts en wetenschap, [online] 54(5), pp.266-271. Geraadpleeg op 19 oktober 2017 via https://link.springer.com/article/10.1007/s12445-011-0135-7.

Camburn, T. (2009). A practical approach to managing the side effects of lapatinib. Cancer Nursing Practice, [online] 8(10), pp.21-27. Geraadpleegd op 14 november 2017 via https://search-proquest-com.kuleuven.ezproxy.kuleuven.be/docview/217515….

Cancer.Net. (2017). Skin Reactions to Targeted Therapy and Immunotherapy. [online] geraadpleeg op 18 november 2017 via https://www.cancer.net/navigating-cancer-care/side-effects/skin-reactio….

Capriotti, T. (2012). Monoclonal antibodies: Drugs that combine pharmacology and biotechnology. Medsurg Nursing, [online] 10(2), p.89. geraadpleegd op 19 november 2017 via https://search-proquest-com.kuleuven.ezproxy.kuleuven.be/docview/230524….

Cardoso, F., Stordeur, S., Vlayen, J., Bourgain, C., Carly, B., Christiaens, M., Cocquyt, V., Lifrange, E., Neven, P., Scalliet, P., Schobbens, J., Van Goethem, M. en Villeirs, G. (2012). Wetenschappelijke ondersteuning van het College voor Oncologie: een update van de nationale richtlijn voor borstkanker. 52nd ed. [ebook] Brussel: Federaal Kenniscentrum voor de gezondheidszorg., pp.19-41. Geraadpleegd op 1 aug 2017 via http://presscenter.org/files/ipc/media/source70885/documents/KCE_143A_u….

Decoene, E., D'haese, S., Bijdekerke, P., Reymenants, S., Neefs, A. en Berghe, L. (2016). Basisboek oncologie voor verpleegkundigen. 3rd ed. Berchem: Uitgeverij De Boeck, pp.16-17.

Doccheck pictures (2010). fingertip eczema. [image] Geraadpleegd op 16 februari 2018 via https://pictures.doccheck.com/com/photo/6205-fingertip-eczema.

Eucerin (2018). Xerosis Symptoms, causes and solutions. [image] geraadpleegd op 16 februari 2018 via https://int.eucerin.com/about-skin/indications/xerosis.

Fallowfield, L., Osborne, S., Langridge, C., Monson, K., Kilkerr, J. and Jenkins, V. (2015). Implications of subcutaneous or intravenous delivery of trastuzumab; further insight from patient interviews in the PrefHer study. The Breast, [online] 24(2), pp.166-170. Geraadpleegd op 19 november 2017 via https://ac-els-cdn-com.kuleuven.ezproxy.kuleuven.be/S096097761500003X/1….

Frijters, P. (2011). Breast cancer and HER3; the possibilities of imaging with VHH probes. [ebook] Utrecht: Faculty of Medicine Theses, pp.6-14. Geraadpleegd op 1 augustus 2017 via https://dspace.library.uu.nl/handle/1874/215731.

Gao, J. and Swain, S. (2016). Pertuzumab for the treatment of breast cancer: a safety review. Expert Opinion on Drug Safety, [online] 15(6), pp.853-863. Geraadpleegd op 2 augustus 2017 via https://www.ncbi.nlm.nih.gov/pubmed/26982349.

Gary, M. and White, M. (2015). Perioral dermatitis. [image] Geraadpleegd op 11 maart 2018 via http://www.regionalderm.com/Regional_Derm/files/perioral_dermatitis.html.

George W., S. (2005). What Is Targeted Therapy?. Journal of Clinical Oncology, [online] 23(8), pp.1614 -1614. Geraadpleegd op 19 oktober 2017 via http://ascopubs.org/doi/pdf/10.1200/JCO.2005.01.016.

Gerendash, B. (2017). OncoTargets and Therapy. [image] Geraadpleegd op 6 maart 2018 via https://www.researchgate.net/figure/examples-of-palmar-plantar-erythrod….

Guide, D. (2017). Acne vulgaris – Unani Medicine. [image] Geraadpleegd op 6 maart 2018 via http://drhealthguide.com/acne-vulgaris-one-common-skin-problems/.

Hansel, T., Kropshofer, H., Singer, T., Mitchell, J. and George, A. (2010). The safety and side effects of monoclonal antibodies. Nature Reviews Drug Discovery, [online] 9(4), pp.325-338. Geraadpleegd op 1 januari 2018 via http://theory.bio.uu.nl/immbio/pdf/TherapeuticReview2010.pdf.

Harkins, B. and Geyer, C. (2017). Overcoming Treatment Challenges in Advanced Breast Cancer. [online] Science direct. Geraadpleegd op 19 oktober 2017 via http://www.sciencedirect.com/science/article/pii/S0749208107000903. &nb…;

Hayes, D. (2015). ANATOMIE EN PATHOLOGIE VAN DE MAMMA. 2nd ed. [ebook] Nijmegen: dutch reference centre for screening, pp.3-30. Geraadpleegd op 27 december 2017 via https://www.lrcb.nl/resources/uploads/2017/02/ANATOMIE-EN-PATHOLOGIE-VA….

HER2support.org (2008). Pictures of Herceptin Rash. [image] Geraadpleegd op 16 februari 2018 via http://her2support.org/vbulletin/showthread.php?t=52568.

Hueso, L., Sanmartín, O., Nagore, E., Botella-Estrada, R., Requena, C., Llombart, B., Serra-Guillén, C., Alfaro-Rubio, A. and Guillén, C. (2008). Chemotherapy-Induced Acral Erythema: A Clinical and Histopathologic Study of 44 Cases. Actas Dermo-Sifiliográficas (English Edition), [online] 99(4), pp.281-290. Geraadpleegd op 28 januari 2018 via https://ac-els-cdn-com.kuleuven.ezproxy.kuleuven.be/S157821900870252X/1….

Kanker.nl. (2017). Doelgerichte therapie bij borstkanker. [online] Geraadpleegd op 12 april 2018 https://www.kanker.nl/bibliotheek/borstkanker/behandeling-en-bijwerking….

Kobrinsky, B., Katz, S., L. Speyer, J. and Zheng, H. (2018). Cardiac Effects of Cancer Therapy. [online] Clinical Gate. Geraadpleegd op 8 mei 2018 via https://clinicalgate.com/cardiac-effects-of-cancer-therapy-2/

Kruse, D., Hiltermann, D., Berendsen, A., Van Belle, S. en Siesling, P. (2016). Oncologie. Houten: Bohm Stafleu Van Loghum, pp.57-71.

Luiten, D. (2017). Tumorkenmerken: snelle groei borstkanker • Chirurg en Operatie. [online] Chirurgenoperatie.nl. Geraadpleegd op 27 december 2017 via http://www.chirurgenoperatie.nl/wp/borst/tumorkenmerken-snelle-groei-bo….

Maring, J. en Bosman, J. (2008). Nr 18 Lapatinib belofte moet nog worden waargemaakt. [online] Pharmaselecta.nl. Geraadpleegd op 2 december 2017 via http://www.pharmaselecta.nl/site/index.php/hoofdartikelen-archief/2008/….

Martini, F., Bartholomew, E., Ober, W., Poelaert, I. and Frankemölle, E. (2017). Anatomie en fysiologie. 6th ed. [Amsterdam]: Pearson, pp.64-100.

Mitchell, E., Roman Pérez-Soler, M., Van Cutsem, E. and Lacouture, M. (2007). Clinical Presentation and Pathophysiology of EGFRI Dermatologic Toxicities. [image] Geraadpleegd op: 6 maart 2018 via http://www.cancernetwork.com/oncology-journal/clinical-presentation-and….

Moore, S. (2007). Managing Treatment Side Effects in Advanced Breast Cancer. Seminars in Oncology Nursing, [online] 23, pp.S23-S30. Geraadpleegd op 1 november 2017 via http://file:///Users/annbonheure%201/Downloads/1-s2.0-S0749208107000927….

Nortier, P. (2012). Op weg naar de volgende generatie in de oncologie. [ebook] Leiden: Universiteit Leiden, pp.7-9. Geraadpleegd op 2 oktober 2017 via https://openaccess.leidenuniv.nl/bitstream/handle/1887/19708/Afscheidsr….

Levine, M. (2005). Trastuzumab Cardiac Side Effects: Only Time Will Tell. Journal of Clinical Oncology, [online] 23(31), pp.7775-7776. Geraadpleegd op 18 november 2017 via http://ascopubs.org.kuleuven.ezproxy.kuleuven.be/doi/pdf/10.1200/JCO.20….

Liang, J., Wu, Y., Chen, B., Zhang, W., Tanaka, Y. and Sugiyama, H. (2013). The C-Kit Receptor-Mediated Signal Transduction and Tumor-Related Diseases. International Journal of Biological Sciences, [online] 9(5), pp.435-443. Geraadpleegd op 2 januari 2018 via https://www.ncbi.nlm.nih.gov/pmc/articles/PMC3654492/.

Professor Klein B. (2016). Targeted Therapy for HER2 Positive Breast Cancer. [image] geraadpleegd op 16 februari 2018 via http://slideplayer.com/slide/7095358/.

Dr. Ten Dijke, P. (2006). Met signaaltransductie terug in balans. [ebook] Leiden: Universiteit Leiden, pp.4-8. Geraadpleegd op 3 december 2017 via https://openaccess.leidenuniv.nl/bitstream/handle/1887/13023/Oratie+ten….

Saadeh, C. and Pharm, D. (2005). Chemotherapy- and Radiotherapy-Induced Oral Mucositis: Review of Preventive Strategies and Treatment. Pharmacotherapy, [online] 25(4), pp.540-554. Geraadpleegd op 2 januari 2018 via http://onlinelibrary.wiley.com.kuleuven.ezproxy.kuleuven.be/doi/10.1592….

Tjin-A-Ton, M., van Montfrans, C., Koldenhof, J., Sigurdsson, V., Voest, E. en Witteveen, P. (2007). Huidafwijkingen als bijwerking van remmers van epidermale groeifactorreceptor. [image] Geraadpleegd op 16 februari 2018 via https://www.ntvg.nl/artikelen/huidafwijkingen-als-bijwerking-van-remmer…

Tsang, R. and Finn, R. (2012). HER2-positive breast cancer: trastuzumab, lapatinib and emerging therapies. Drug Discovery Today: Therapeutic Strategies, [online] 9(2-3), pp.e55-e60. Geraadpleegd op 23 oktober 2017 via https://ac-els-cdn-com.kuleuven.ezproxy.kuleuven.be/S1740677311000131/1….

Van De Vijver, M. (2009). Richting geven aan de behandeling. [ebook] Amsterdam: Universiteit Amsterdam, pp.10-15. Geraadpleegd op 3 oktober 2017 via https://pure.uva.nl/ws/files/817792/75924_vijver.pdf.

Van ROSSUM, H. en Van PELT, J. (2012). Het monitoren van de werking van immuunsuppressieve medicatie in orgaantransplantatie patiënten. Ned Tijdschr Klin Chem Labgeneesk, [online] 37(1), pp.47 - 49. Geraadpleegd op 13 mei 2018 via http://www.citethisforme.com/cite/sources/journalmanualcite

Vasbinder, R. (2008). Monoklonale antilichamen | Geneesmiddelenbulletin. [online] Geneesmiddelenbulletin.com. Geraadpleegd op 23 oktober 2017 via http://geneesmiddelenbulletin.com/artikel/monoklonale-antilichamen/.

VELDE, C. (2011). ONCOLOGIE. 8th ed. [S.l.]: Houten: Bohn Stafleu Van Loghum, pp.431-450.

Wagener, D. (2010). De geschiedenis van de oncologie. Houten: Bohn Stafleu van Loghum, pp.195-196.

Wikipedia, f. (2017). Monoclonal antibody therapy. [online] En.wikipedia.org. Geraadpleegd op 23 oktober 2017 via https://en.wikipedia.org/wiki/Monoclonal_antibody_therapy.

Wikipedia, f. (2017). Tyrosine-kinase inhibitor. [online] En.wikipedia.org. Geraadpleegd op 23 oktober 2017 via https://en.wikipedia.org/wiki/Tyrosine-kinase_inhibitor.

Williams, T. (2011). CHEMOTHERAPY-INDUCED HAND-FOOT SYNDROME. Cancer Nursing Practice, [online] 10(3), pp.14-18. Geraadpleegd op 4 november 2017 via https://search-proquest-com.kuleuven.ezproxy.kuleuven.be/docview/864037….

Zhu, C., Ling, W., Zhang, J., Gao, H., Shen, K. and Ma, X. (2017). Safety and efficacy evaluation of pertuzumab in patients with solid tumors. Medicine, [online] 96(20), p.e6870. Geraadpleegd op 2 augustus 2017 via https://www.ncbi.nlm.nih.gov/pmc/articles/PMC5440139/.