Brein-computer interfaces: Spellen met enkel je ogen en brein.

- BenjaminWittevrongel

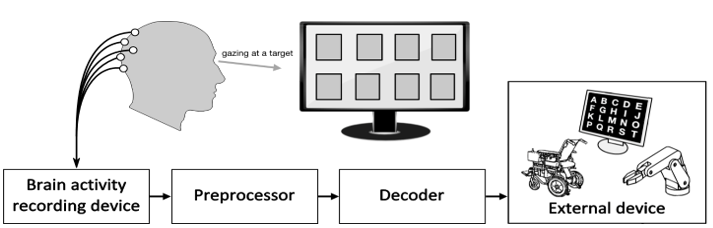

Patienten die lijden aan amyotrophic lateral sclerosis (ALS), andere neurodegeneratieve ziektes of ruggegraat letsels hebben het vaak moeilijk om hun wil en verlangens uit te drukken. Recente ontwikkelingen in het technologische, en dan vooral de technologie van artificiële intelligentie, geven de patient een nieuwe communicatiemethode in de vorm van brein-computer interfaces (BCI).

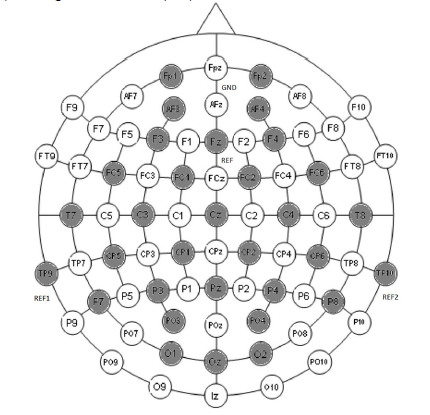

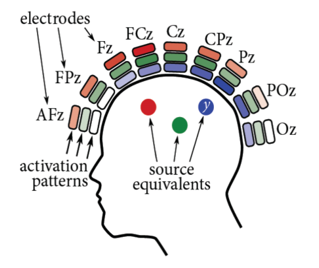

In het verleden zijn er al enkele BCIs ontwikkeld met toepassingen in beide brein-gestuurde selectieconsoles of het controleren van een computermuis door simpelweg te denken aan het uitvoeren van een actie (bijvoorbeeld het bewegen van je rechterarm). De meest succesvolle BCIs vereisen echter een medische ingreep waarin een elektrode direct in het brein wordt aangebracht. Een alternatief hiervoor is BCIs die gestuurd worden via elektroencephalografie (EEG). EEG is een niet-invasieve methode om hersenactiviteit te meten door elektrodes aan te brengen op de scalp. De layout hoe deze elektroden op de scalp geplaasts worden vindt u in Figuur 2.

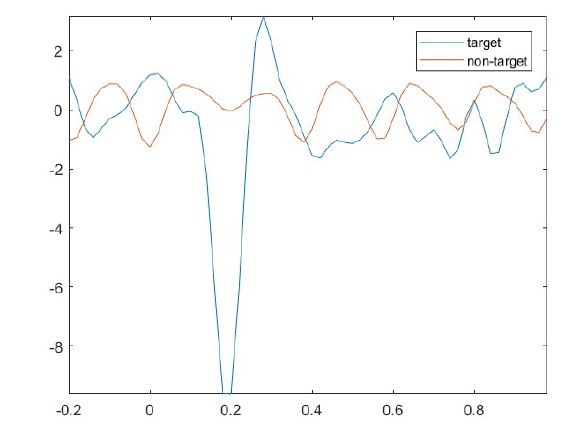

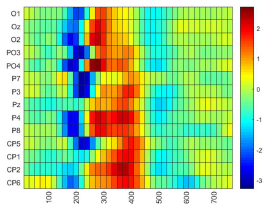

Door een visuele stimulans te presenteren aan de patient zoals bijvoorbeeld een bewegende lijn (motion Visual Evoked Potentials (mVEP)) of een plots anderskleurig beeld (P300 “oddball”) kunnen we met EEG een piek meten die een constant tijds patroon vertoond afhankelijk van het moment van stimulatie. In de scriptie werd vooral gefocust op het bestuderen van de mVEP die een negatieve piek vertoont rond 200ms na stimulus en een postieve piek 250-300ms na stimulus.

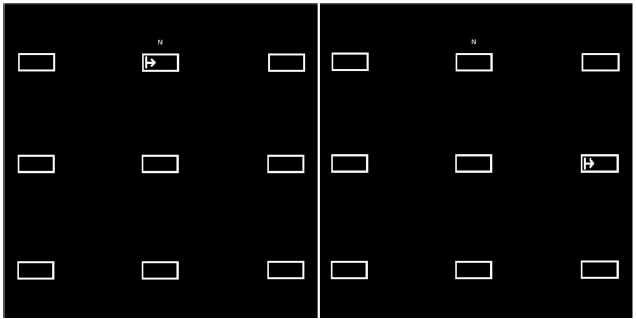

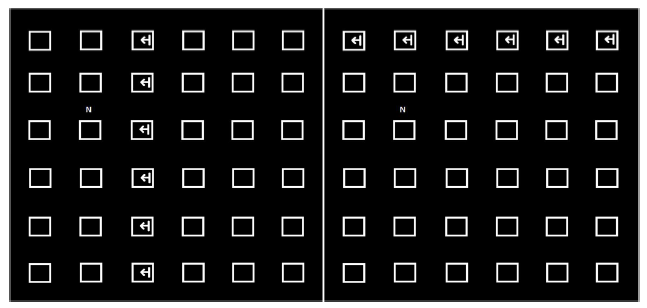

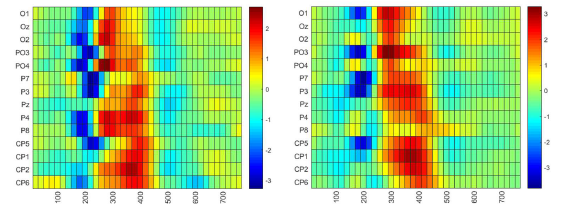

Door een computerprogramma te schrijven dat de stimulatie uitvoerd en de exacte tijd van stimulatie opslaat tesamen met de respons gemeten door de EEG, hebben we de mogelijkheid om een classificatie algoritme (Spatiotemporal Beamformer (stBF)) te trainen. Dit gebeurt door de patient te presenteren met een interface waarop 1 richting als “target” wordt aangeduid. De patient wordt verzocht om zich te focussen op het target. Vervolgens worden alle mogelijke targets gestimuleerd en dit wordt vervolgens opgeslagen door ons computerprogramma. Dit proces wordt enkele keren herhaald aangezien een EEG signaal veel ruis bevat. We nemen vervolgens het gemiddelde van de responsen om een klaar signaal te bekomen. Een visuele representatie van het interface vindt u in Figuur 3. Indien de patient de instructies correct heeft uitgevoerd zouden de gemeten reacties voor target en niet-target eruit moeten zien zoals in figuur 4.

Door de aanwezigheid van de pieken in het gemeten signaal kunnen we nu een classificatiealgoritme trainen om te voorspellen naar waar de patient kijkt door simpelweg het signaal in te laden per mogelijk target. Deze leert het patroon dat gemeten wordt door de EEG wanneer er een stimulus voorkomt in het gezichtsveld van de patient. Het patroon komt overeen met een relevantieschaal, indien het gemeten signaal van een target goed overeenkomt met het patroon, wordt dit target als de bedoelde richting geslecteerd en bijgevolg de bijhordende “knop” ingeduwd. Het patroon en hoe dit gemeten wordt door de EEG vindt u in figuur 5.

Het originele doel van het werk was nagaan indien het stBF algoritme even accuraat voorspelt als algoritmes die voordien voor deze doeleinden als state-of-the-art beschouwd werden (support vector machines (SVM) en stepwise linear discriminent analysis (SWLDA)). Het speciale aan de stBF vergeleken met tradiotionele beamformers is dat het niet enkel kijkt naar de oorsprong van het signaal op de scalp maar ook naar het veranderende signaal in de tijd om de belangrijkste eigenschappen (i.e. pieken) van het signaal te berekenen. Als bijdoelen hebben we het effect getest op de richting waarin de stimulus zich beweegd (links of rechts) en een hybride-BCI gecreërd die beide in een bewegende lijn (mVEP) en een kleurverandering (P300) respons teweegdbrengd.

Uit de resultaten bleek dat de stBF even accuraat functioneerd als de andere classificatiealgorithmes maar dat de trainingtijd van de stBF significant lager ligt (respectievelijk 10x en 43x lager voor SWLDA en SVM) dan zijn voorgangers. Dit maakt het mogelijk om de stBF te gebruiken in on-line applicaties, dit zijn applicaties die getrained kunnen worden voor gebruik in dezelfde sessie, zoals bijvoorbeeld een spellingsconsole afgebeeld hieronder in Figuur 6. Ook bleek dat een hybride-BCI met mVEP en P300 tesamen afgeraden zou moeten worden aangezien de accuraatheid van het algoritme niet verbeterde en de P300 belastend is voor de ogen van de patient. Een interessant resultaat was dat voor rechtshandigen blijkt dat indien de stimulans van rechts naar links gaat, enkel de linkerhersenhelft geactiveerd wordt, terwijl wanneer de stimulans van links naar rechts gaat, beide hersenhelfden geactiveerd worden maar met een vertraging van 50ms. Dit phenomeen wordt momenteel nader onderzocht in een postgraduaat onderzoek. Het verschil is hieronder visueel gepresenteerd in Figuur 7

Bibliografie

[1] J. R. Wolpaw, N. Birbaumer, D. J. McFarland, G. Pfurtscheller, and T. M.

Vaughan, “Brain-computer interfaces for communication and control.,” Clin.

Neurophysiol., vol. 113, no. 6, pp. 767–91, 2002.

[2] D. Marshall, S. Wilson, and D. Coyle, “Motion-Onset Visual Evoked Potentials

for Gaming: A pilot study,” 24th IET Irish Signals Syst. Conf. (ISSC 2013), pp.

56–56, 2013.

[3] I. Martišius and R. Damaševičius, “A prototype SSVEP based real time BCI

gaming system,” Comput. Intell. Neurosci., vol. 2016, 2016.

[4] J. Jin, H. Zhang, I. Daly, X. Wang, and A. Cichocki, “An improved P300 pattern

in BCI to catch user’s attention,” J. Neural Eng., vol. 14, no. 3, 2017.

[5] P. Stawicki, F. Gembler, and I. V. B, “A User-Friendly Dictionary-Supported

SSVEP-based BCI,” vol. 9961, pp. 168–180, 2017.

[6] X. Gao, D. Xu, M. Cheng, and S. Gao, “A BCI-based environmental controller for

the motion-disabled,” IEEE Trans. Neural Syst. Rehabil. Eng., vol. 11, no. 2, pp.

137–140, 2003.

[7] J. J. Wilson and R. Palaniappan, “Augmenting a SSVEP BCI through single

cycle analysis and phase weighting,” 2009 4th Int. IEEE/EMBS Conf. Neural

Eng. NER ’09, pp. 371–374, 2009.

[8] T. Ma, F. Li, P. Li, D. Yao, Y. Zhang, and P. Xu, “An Adaptive Calibration

Framework for mVEP-Based Brain-Computer Interface,” vol. 2018, 2018.

[9] F. Guo, B. Hong, X. Gao, and S. Gao, “A brain-computer interface using motiononset

visual evoked potential,” J. Neural Eng., vol. 5, no. 4, pp. 477–485, 2008.

[10] T. Liu, L. Goldberg, S. Gao, and B. Hong, “An online brain-computer interface

using non-flashing visual evoked potentials,” J. Neural Eng., vol. 7, no. 3, 2010.

[11] S. Schaeff, M. S. Treder, B. Venthur, and B. Blankertz, “Exploring motion VEPs

for gaze-independent communication,” J. Neural Eng., vol. 9, no. 4, 2012.

[12] B. Wittevrongel and M. M. Van Hulle, “Faster P300 Classifier Training Using

Spatiotemporal Beamforming,” Int. J. Neural Syst., vol. 26, no. 03, p. 1650014,

2016.

[13] B. Wittevrongel, E. Van Wolputte, and M. M. Van Hulle, “Code-modulated visual

evoked potentials using fast stimulus presentation and spatiotemporal

beamformer decoding,” Sci. Rep., vol. 7, no. 1, pp. 1–10, 2017.

[14] M. Van Vliet et al., “Single-trial ERP component analysis using a spatio-temporal

LCMV beam former.,” IEEE Trans. Biomed. Eng., vol. 63, no. 1, pp. 55–66,

2016.

[15] B. Wittevrongel and M. M. Van Hulle, “Spatiotemporal beamforming: A

transparent and unified decoding approach to synchronous visual braincomputer

interfacing,” Front. Neurosci., vol. 11, no. NOV, pp. 1–12, 2017.

[16] B. Wittevrongel and M. M. Van Hulle, “Frequency- and Phase Encoded SSVEP

Using Spatiotemporal Beamforming,” pp. 1–18, 2016.

[17] B. Hong, F. Guo, T. Liu, X. Gao, and S. Gao, “Clinical Neurophysiology N200-

speller using motion-onset visual response,” Clin. Neurophysiol., vol. 120, no. 9,

pp. 1658–1666, 2009.

[18] D. Zhang, H. Song, H. Xu, W. Wu, S. Gao, and B. Hong, “An N200 speller

integrating the spatial profile for the detection of the non-control state,” J. Neural

Eng., vol. 9, no. 2, 2012.

[19] A. Bruce, J. Alexander, L. Julian, R. Martin, R. Keith, and W. Peter, “Molecular

Biology of the Cell: The nervous system,” 2002.

[20] “https://simple.wikipedia.org/wiki/Neuron#/media/File:Neuron.svg: image of a

neuron.” [Online]. Available:

https://simple.wikipedia.org/wiki/Neuron#/media/File:Neuron.svg.

[21] “http://www.interactive-biology.com/49/proteins-in-the-membrane-of-the-n…-

their-functions/: image of cell membrane.” [Online]. Available:

http://www.interactive-biology.com/49/proteins-in-the-membrane-of-the-n…-

their-functions/.

[22] “http://physiologyplus.com/wp-content/uploads/2017/06/Propagation-of-act….

png: action potential propagation.”

[23] “https://en.wikipedia.org/wiki/Neurotransmission: detailed image of synapse.”

[24] D. Cic, “Brain Waves,” no. 66, pp. 1–4, 2013.

[25] W. J. freeman, “The Basics of Brain Waves,” 1930.

[26] D. R. S. E. D. and B. A. Hill, Coping with Concussion and Mild Traumatic Brain

Injury. 2013.

[27] J. L. Fannin, “Understanding Your Brainwaves,” Underst. your brainwaves, pp.

1–20.

[28] S. S. and V. K. Sinha, “Event-related potential: an overview,” Ind. Psychiatry J.,

2009.

[29] J. D. Kropotov, Functional Neuromarkers for Psychiatry Applications for

Diagnosis. 2016.

[30] M. G. H. Coles and M. D. Rugg, “Event-related brain potentials : an introduction.”

[31] M. Kuba, Z. Kubová, J. Kremláček, and J. Langrová, “Motion-onset VEPs:

Characteristics, methods, and diagnostic use,” Vision Res., vol. 47, no. 2, pp.

189–202, 2007.

[32] A. K. Smith et al., “Processes in Schizophrenia Conclusions :,” no. October, pp.

1264–1275, 2010.

[33] J. Y. Bennington and J. P. U, “Comparison of P300 from passive and active

tasks for auditory and visual stimuli,” pp. 171–177, 1999.

[34] S. J. Golubic, A. Susac, R. Huonker, J. Haueisen, and S. Supek, “Early

attentional modulation of the neural network evoked with the auditory pairedclick

paradigm : An MEG study,” Procedia - Soc. Behav. Sci., vol. 126, pp. 195–

196, 2014.

[35] C. W. Robinson, “Proceedings of the Annual Meeting of the Cognitive Science

Evidence for auditory dominance in a passive oddball task,” 2010.

[36] R. Hashimoto, F. Homae, and K. Nakajima, “Functional Differentiation in the

Human Auditory and Language Areas Revealed by a Dichotic Listening Task,”

vol. 158, pp. 147–158, 2000.

[37] E. Halgren, K. Marinkovic, and P. Chauvel, “Generators of the late cognitive

potentials in auditory and visual oddball tasks,” vol. 106, pp. 156–164, 1998.

[38] H. Erhan, J. C. Borod, C. E. Tenke, and G. E. Bruder, “Identification of Emotion

in a Dichotic Listening Task : Event-Related Brain Potential and Behavioral

Findings and,” vol. 307, no. 37, pp. 286–307, 1998.

[39] G. G. Briggs and R. D. Nebes, “NOTE THE EFFECTS OF HANDEDNESS ,

FAMILY HISTORY AND SEX ON THE PERFORMANCE OF A DICHOTIC

LISTENING TASK,” vol. 14, no. 2, pp. 129–133, 1976.

[40] “http://brainandlimbicsystem.weebly.com/the-brain.html: image of the right half of

the brain.”

[41] E. R. J. Samuel Sutten, Margery Braren, Joseph Zubin, “Evoked-Potential

Correlates of Stimulus Uncertainty,” Science (80-. )., vol. 150, no. 3700, pp.

1187–1188, 1965.

[42] C. Neurophysiology, “The P300 Wave of the Human Event-Related Potential,”

no. November 1992, 2017.

[43] L. Storeoencophalographte, U. De Recherches, U. Eptlepste, C. P. Broca, and

P. France, “The intracranial topography of the P3 event-related potential elicited

during auditory oddball 1 Recordings,” 1990.

[44] D. E. J. LINDEN, “The P300 : Where in the Brain Is It Produced and What Does

It Tell Us ?,” vol. 11, no. 6, pp. 563–576, 2005.

[45] J. Y. Bennington and J. Polich, “Comparison of P300 from passive and active

tasks for auditory and visual stimuli,” vol. 34, pp. 171–177, 1999.

[46] I. J. H. Studies, Y. Sivarajah, E. Holden, R. Togneri, G. Price, and T. Tan,

“Quantifying target spotting performances with complex geoscienti fi c imagery

using ERP P300 responses $,” J. Hum. Comput. Stud., vol. 72, no. 3, pp. 275–

283, 2014.

[47] G. Juckel et al., “NeuroImage Age effects on the P300 potential and the

corresponding fMRI BOLD-signal,” Neuroimage, vol. 60, no. 4, pp. 2027–2034,

2012.

[48] G. Sara, E. Gordon, C. Kraiuhin, S. Coyle, A. Howson, and R. Meares, “jourual

of The P300 ERP component : an index of cognitive dysfunction in

depression ?,” 1994.

[49] B. N. Gangadhar, J. Ancy, and N. Janakiramaiah, “P300 amplitude in nonbipolar

, melancholic depression,” vol. 28, pp. 57–60, 1993.

[50] J. M. Ford, D. H. Mathalon, S. Kalba, and L. Marsh, “N1 and P300 Abnormalities

in Patients with Schizophrenia , Epilepsy , and Epilepsy with Schizophrenialike

Features,” no. Lm, 2001.

[51] S. S. Kristina Tokic, Marina Titlic, Amira Beganovic-Petrovic, Enra Suljic,

Rinaldo Romac, “P300 Wave changes in patients with Parkinson’s Disease,”

2016.

[52] M. Wade, Y.-C. Li, and G. M. Wahl, “Toward Enhanced P300 Speller

Performance,” Nat. Rev. Cancer, vol. 13, no. 2, pp. 83–96, 2013.

[53] V. Guy, C. Desnuelle, and M. Clerc, “ScienceDirect Brain computer interface

with the P300 speller : Usability for disabled people with amyotrophic lateral

sclerosis,” vol. 61, pp. 5–11, 2018.

[54] C. Guan, M. Thulasidas, and J. Wu, “Performance p300 speller for braincomputer

interface,” pp. 13–16, 2004.

[55] D. J. Krusienski et al., “A Comparison of Classification Techniques for the P300

Speller,” 2010.

[56] N. V Manyakov, N. Chumerin, A. Combaz, and M. M. Van Hulle, “Comparison of

Classification Methods for P300 Brain-Computer Interface on Disabled

Subjects,” vol. 2011, 2011.

[57] P. Lee, “Brain computer interface using flash onset and offset visual evoked

potentials,” vol. 119, pp. 605–616, 2008.

[58] Y.-T. W. Po-Lei Lee, Jen-Chuen Hsieh, Chi-Hsun Wu, Kuo-Kai Shyu, Shyan-

Shiou Chen, Tzu-Chen Yeh, “The Brain Computer Interface Using Flash Visual

Evoked Potential and Independent Component Analysis,” vol. 34, no. 10, pp.

1641–1654, 2006.

[59] B. Z. Allison, D. J. Mcfarland, G. Schalk, S. Dong, M. Moore, and J. R. Wolpaw,

“Towards an independent brain – computer interface using steady state visual

evoked potentials,” vol. 119, pp. 399–408, 2008.

[60] J. Xie, G. Xu, J. Wang, F. Zhang, and Y. Zhang, “Steady-State Motion Visual

Evoked Potentials Produced by Oscillating Newton ’ s Rings : Implications for

Brain- Computer Interfaces,” vol. 7, no. 6, 2012.

[61] N. V Manyakov, N. Chumerin, A. Robben, A. Combaz, M. Van Vliet, and M. M.

Van Hulle, “Sampled Sinusoidal Stimulation Profile and Multichannel Fuzzy

Logic Classification for Monitor-based Phase-coded SSVEP Brain-Computer

Interfacing.”

[62] M. Cheng, X. Gao, S. Gao, S. Member, and D. Xu, “Design and Implementation

of a Brain-Computer Interface With High Transfer Rates,” vol. 49, no. 10, pp.

1181–1186, 2002.

[63] G. Bin, X. Gao, and Y. Wang, “VEP-Based Brain-Computer Interfaces: Time,

Frequency, and Code Modulations 1.,” no. November, pp. 22–26, 2009.

[64] K. Momose, “Evaluation of an eye gaze point detection method using VEP

elicited by multi-pseudorandom stimulation for brain computer interface,” Annu.

Int. Conf. IEEE Eng. Med. Biol. - Proc., vol. 2, pp. 5063–5066, 2007.

[65] S. I. Dimitriadis and A. D. MARIMPIS, “Enhancing Performance and Bit Rates in

a Brain–Computer Interface System with Phase-to-Amplitude Cross-Frequency

Coupling: Evidence from Traditional c-VEP, fast c-VEP and SSVEP Designs,”

Front. Neuroinform., vol. 12, no. April, p. 19, 2018.

[66] M. Kuba and Z. Kubova, “Visual evoked potentials specific for motion onset,” pp.

83–89, 1992.

[67] Fei Guo, Bo Hong, Xiaorong Gao, and Shangkai Gao, “A brain computer

interface based on motion-onset VEPs,” 2008 30th Annu. Int. Conf. IEEE Eng.

Med. Biol. Soc., pp. 4478–4481, 2008.

[68] M. Kuba, Motion-onset Visual Evoked Potentials and their Diagnostic

Applications. .

[69] T. Martin, K. Huxlin, and V. Kavcic, “Motion-onset visual evoked potentials

predict performance during a global direction discrimination task,”

Neuropsychologia, vol. 48, no. 12, pp. 3563–3572, 2010.

[70] T. Ma et al., “The extraction of motion-onset VEP BCI features based on deep

learning and compressed sensing,” J. Neurosci. Methods, vol. 275, pp. 80–92,

2017.

[71] C. Raitta, U. Karhunen, A. Maria, and M. Naukkarinen, “Graefes Archiv

Ophthalmologie Potentials During General Anaesthesia,” vol. 144, pp. 139–144,

1979.

[72] A. S. Richard R. Uhl, Kenneth C. squires, David L. Bruce, “Effect of halothan

Anesthesia on the Human Cortical Visual Evoked Response,” J. Anesthesiol.,

vol. 53, no. 3, 1980.

[73] D. H. York, M. W. Pulliam, J. G. Rosenfeld, and C. Watts, “Relationship between

visual evoked potentials and intracranial pressure,” J. Neurosurg., vol. 55, no. 6,

pp. 909–916, 1981.

[74] W. Tsang and R. F. Hampson, “Acute visual evoked potential changes in

hydrocephalus,” Natl. Inst. Stand. Technol., no. m, pp. 331–333, 1986.

[75] E. L. Reilly, C. Kondo, J. A. Brunberg, and D. B. Doty, “Visual evoked potentials

during hypothermia and prolonged circulatory arrest,” Electroencephalogr. Clin.

Neurophysiol., vol. 45, no. 1, pp. 100–106, 1978.

[76] T. W. and J. E.O., “Evoked cortical potentials in patients with ‘isoelectric’ EEGs,”

Electroencephalogr. Clin. Neurophysiol., vol. 35, pp. 301–309, 1973.

[77] P. L. Lee et al., “An SSVEP-actuated brain computer interface using phasetagged

flickering sequences: A cursor system,” Ann. Biomed. Eng., vol. 38, no.

7, pp. 2383–2397, 2010.

[78] C. Jia, X. Gao, B. Hong, and S. Gao, “Frequency and phase mixed coding in

SSVEP-based brain - Computer interface,” IEEE Trans. Biomed. Eng., vol. 58,

no. 1, pp. 200–206, 2011.

[79] N. V. MANYAKOV, N. CHUMERIN, and M. M. VAN HULLE, “Multichannel

Decoding for Phase-Coded Ssvep Brain–Computer Interface,” Int. J. Neural

Syst., vol. 22, no. 05, p. 1250022, 2012.

[80] P. G. H. Cla, “Comparison of Visual Evoked Potentials l o Stationary and to

Moving Patterns,” vol. 164, pp. 156–164, 1973.

[81] W. Yan et al., “Steady-State Motion Visual Evoked Potential (SSMVEP) based

on equal luminance colored enhancement,” PLoS One, vol. 12, no. 1, pp. 1–18,

2017.

[82] X. Chen, Y. Wang, M. Nakanishi, X. Gao, T.-P. Jung, and S. Gao, “High-speed

spelling with a noninvasive brain–computer interface,” Proc. Natl. Acad. Sci., vol.

112, no. 44, pp. E6058–E6067, 2015.

[83] D. Marshall, R. Beveridge, S. Wilson, and D. Coyle, “Interacting with multiple

game genres using Motion Onset Visual Evoked Potentials,” Proc. CGAMES

2015 USA - 20th Int. Conf. Comput. Games AI, Animat. Mobile, Interact.

Multimedia, Educ. Serious Games, pp. 18–27, 2015.

[84] S. S. Keerthi and D. DeCoste, “A modified finite newton method for fast solution

of large scale linear SVMs,” J. Mach. Learn. Res., vol. 6, pp. 341–361, 2005.

[85] N. R. Draper and H. Smith, “Applied Regression Analysis.” pp. 335–339, 1998.

[86] O. L. Mangasarian, “A finite Newton method for classification,” Optim. Methods

Softw., vol. 17, no. 5, pp. 913–929, 2002.

[87] A. J. Izenman, “Linear Discriminant Analysis,” in Modern Multivariate Statistical

Techniques, 2008, pp. 237–263.

[88] N. Draper and H. Smith, “Applied Regression Analysis: stepwise regression

procedure,” in Applied regression analysis, 1968, pp. 171–173.

[89] B. D. Van Veen and K. M. Buckley, “Beamforming: a versatile approach to

spatial filtering,” IEEE ASSP Mag., vol. 5, no. 2, pp. 4–24, 1988.

[90] B. D. Van Veen, W. Van Drongelen, M. Yuchtman, and A. Suzuki, “Localization

of brain electrical activity via linearly constrained minimum variance spatial

filtering,” IEEE Trans. Biomed. Eng., vol. 44, no. 9, pp. 867–880, 1997.

[91] G. Van Dijck, A. Jezzini, S. Herwik, and S. Kisban, “Neural Information

Processing. Models and Applications,” vol. 6444, no. November, 2010.

[92] “http://www.fieldtriptoolbox.org/template/layout: scalp recording layout.”

[93] M. M. Van Hulle, “neural recording: invasive vs non-invasive.”

[94] D. B. and D. Pelli, “Psychtoolbox.” .

[95] “Curry 7 compumedics neuroscan.” [Online]. Available:

https://compumedicsneuroscan.com/curry-7-signal-processing-basic-advanc…-

analysis/.

[96] N. B. Andrea Kübler, Nicola Neumann, Barbara Wilhelm, Thilo Hinterberger,

“Predictability of Brain-Computer Communication,” J. Psychophysiol., vol. 18,

pp. 121–129, 2004.