Passen je hersenen in een computer?

Waarom ben je wie je bent, waarom leer je uit je fouten en waarom onthoud je (hopelijk) iets van dit artikel? Over de exacte mechanismen van ons bewustzijn, leervermogen en geheugen is de wetenschap het nog steeds niet eens, maar door onze hersenen te simuleren in een computer kunnen we een nieuw licht werpen op deze mysteries.

Je hersenen zijn een gigantisch mierennest

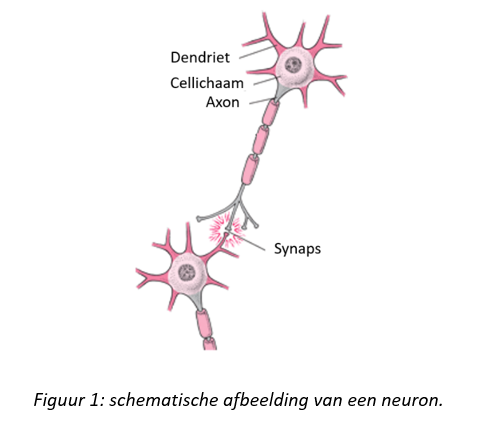

Het doen en laten van een mier wordt bepaald door een handvol simpele regels. Een hele mierenkolonie kan echter een veel complexer gedrag vertonen, dat de simpele vuistregels van de individuele mier overstijgt. Dit fenomeen, waarbij het geheel de individuele stukjes overstijgt, wordt emergentie genoemd. Zo bestaan ook je hersenen uit ongeveer 90 miljard individuele neuronen. Deze neuronen staan in verbinding door via hun axonen signalen te sturen naar de dendrieten van andere neuronen (figuur 1). Al deze signalen worden beïnvloed door synapsen. Synapsen zijn de connecties tussen de axonen en dendrieten. De neuronen kunnen namelijk de connectiesterkte van die synapsen aanpassen. Hierdoor verandert de sterkte van de signalen die doorgestuurd worden in onze hersenen. Dit aanpassingsvermogen van de synapsen wordt synaptische plasticiteit genoemd en veroorzaakt de emergentie van ons leervermogen en geheugen. Hoe de neuronen hun synaptische plasticiteit regelen is nog niet exact geweten. Het ontdekken van deze regels is de sleutel tot het ontrafelen van ons leervermogen en geheugen.

Slimme computers

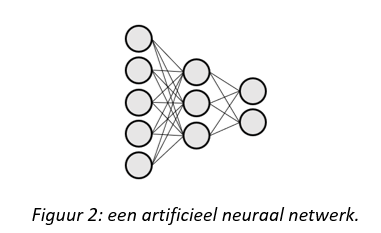

In de neurowetenschappen wordt al enkele decennia lang onderzoek gedaan naar de werking van de synaptische plasticiteit. De regels die ze ontdekten, hebben echter tot nu toe nooit geleid tot een emergent leervermogen dat even krachtig is als bij de mens. In het domein van artificiële intelligentie zijn er recent slimme algoritmes uitgevonden, die het leervermogen van de mens op sommige vlakken benaderen of zelfs overstijgen. Vele van deze doorbraken zijn gebaseerd op artificiële neurale netwerken die geprogrammeerd worden in een computer. Deze netwerken bestaan uit eenvoudige abstracte neuronen die met elkaar verbonden zijn en de sterkte van hun synapsen aanpassen volgens een wiskundig algoritme (figuur 2). Zou het kunnen dat onze hersenen hun synapsen op een gelijkaardige manier aanpassen? Na onderzoek blijkt helaas dat dit wiskundig model biologisch niet mogelijk is. Toch kunnen deze simpele wiskundige neuronen ons nog steeds helpen om de hersenen te ontrafelen indien we nieuwe, biologisch mogelijke hypothesen voor de synaptische plasticiteit kunnen bedenken.

Leren met ideaalbeelden

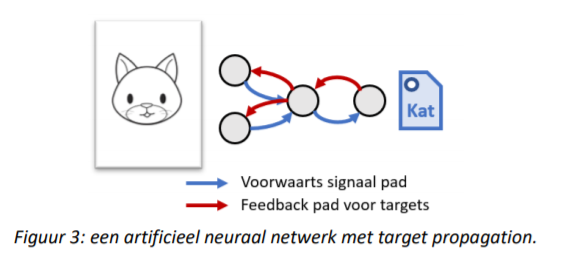

Om ervoor te zorgen dat de hypothese voor synaptische plasticiteit van een model wel mogelijk is in onze hersenen, kan je best beginnen met een model dat de synaptische sterktes aanpast op een biologisch onderbouwde manier. Daarna kan je dan onderzoeken welk emergent leervermogen het hele netwerk vertoont. Target propagation, een nieuwe hypothese voor de synaptische plasticiteit in artificiële neurale netwerken, maakt gebruik van deze strategie. Deze hypothese stelt dat er een evenwicht moet zijn tussen het signaal dat een neuron uitstuurt via voorwaartse connecties en het target signaal dat hij binnenkrijgt via feedback connecties (figuur 3). Als zijn voorwaarts signaal verschillend is van zijn target signaal, moet hij de sterktes van zijn synapsen aanpassen om dat verschil kleiner te maken. Deze target signalen stellen een ideaalbeeld voor. Neem als voorbeeld een artificieel neuraal netwerk dat foto’s van honden en katten moet onderscheiden. De input neuronen van het netwerk krijgen een foto van een hond of kat te zien en het output neuron moet zeggen of het een hond of kat is. Hierna wordt de juiste oplossing (het label van hond of kat) als een target via feedback verbindingen naar al de neuronen van het netwerk gestuurd. Als het netwerk correct was, zijn de signalen die de neuronen uitsturen dezelfde als de targets die ze binnenkrijgen, dus moeten ze hun synapsen niet aanpassen. Als het netwerk fout was, verschillen de signalen van hun target signalen en moeten de neuronen hun synapsen wel aanpassen.

Van mier tot mierenkolonie

Het grote probleem is dat target propagation enkel een wiskundige vergelijking heeft over hoe de synapsen aangepast moeten worden, maar geen model heeft voor het emergente leervermogen dat hierdoor ontstaat in het netwerk. We kennen dus de simpele regeltjes voor het gedrag van elke mier, maar we hebben geen model voor het gedrag van de mierenkolonie. In mijn thesis heb ik een model voor dit emergente leervermogen opgesteld. Via dit model ben ik erachter gekomen dat target propagation heel gelijkaardig is aan een bekend wiskundig algoritme, genaamd Gauss-Newton optimalisatie. Gauss-Newton optimalisatie is in theorie een veel krachtiger algoritme dan het error back-propagation algoritme dat meestal gebruikt wordt in artificiële neurale netwerken. Met mijn wiskundig model kunnen we nu verder onderzoeken hoe we target propagation kunnen verbeteren zodat het de Gauss-Newton optimalisatie beter benadert. Dit zou tot grote doorbraken kunnen leiden in artificiële intelligentie.

Van wiskundige neuronen naar biologische neuronen

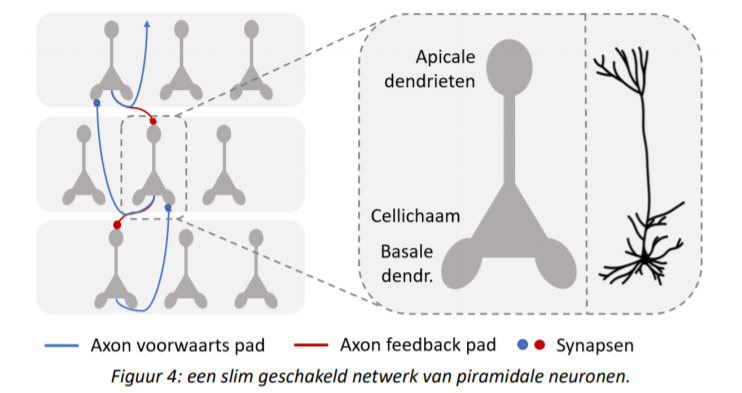

De target propagation methode was weliswaar bedacht vanuit een biologisch standpunt, maar hoe komen de feedback paden en de target signalen in een biologisch neuraal netwerk werkelijk voor? In mijn thesis heb ik ontdekt dat deze feedback paden en target signalen in theorie mogelijk zijn in netwerken van piramidale neuronen. Piramidale neuronen zijn de meest voorkomende neuronen in onze hersenschors en kunnen opgedeeld worden in drie verschillende delen (figuur 4): het piramidevormig cellichaam, de basale dendrieten en de apicale dendrieten. Door deze drie compartimenten van verschillende neuronen op een slimme manier met elkaar te verbinden, verschijnen er feedback paden waarvan neuronen gebruik kunnen maken om de target signalen door te sturen. Target propagation kan dus niet alleen leiden tot wiskundige doorbraken in artificiële intelligentie, maar het is ook mogelijk dat onze hersenen een soortgelijke methode gebruiken om ons nieuwe dingen te laten leren.

Kunnen we nu onze hersenen simuleren? Passen je hersenen in een computer? Voorlopig (nog) niet, maar door stelselmatig wiskundige modellen te combineren met de biologische eigenschappen van onze hersenen, komen we stapje voor stapje dichterbij.

Bibliografie

[1] Y. LeCun, Y. Bengio, and G. Hinton, “Deep learning,” nature, vol. 521, no. 7553, p. 436, 2015.

[2] D. H. Hubel and T. N. Wiesel, “Receptive fields, binocular interaction and functional architecture in the cat’s visual cortex,” The Journal of physiology, vol. 160, no. 1, pp. 106–154, 1962.

[3] D. E. Rumelhart, G. E. Hinton, and R. J. Williams, “Learning representations by back-propagating errors,” nature, vol. 323, no. 6088, p. 533, 1986.

[4] Y. Bengio, D.-H. Lee, J. Bornschein, T. Mesnard, and Z. Lin, “Towards biologically plausible deep learning,” arXiv preprint arXiv:1502.04156, 2015.

[5] D.-H. Lee, S. Zhang, A. Fischer, and Y. Bengio, “Difference target propagation,” in Joint european conference on machine learning and knowledge discovery in databases. Springer, 2015, pp. 498–515.

[6] T. P. Lillicrap, D. Cownden, D. B. Tweed, and C. J. Akerman, “Random synaptic feedback weights support error backpropagation for deep learning,” Nature communications, vol. 7, p. 13276, 2016.

[7] J. Sacramento, R. P. Costa, Y. Bengio, and W. Senn, “Dendritic error backpropagation in deep cortical microcircuits,” arXiv preprint arXiv:1801.00062, 2017.

[8] J. Guerguiev, T. P. Lillicrap, and B. A. Richards, “Towards deep learning with segregated dendrites,” ELife, vol. 6, p. e22901, 2017.

[9] Y. Bengio, “How auto-encoders could provide credit assignment in deep networks via target propagation,” arXiv preprint arXiv:1407.7906, 2014.

[10] Y. LeCun, “The mnist database of handwritten digits,” http://yann. lecun. com/exdb/mnist/, 1998.

[11] S. Bartunov, A. Santoro, B. A. Richards, G. E. Hinton, and T. Lillicrap, “Assessing the scalability of biologically-motivated deep learning algorithms and architectures,” arXiv preprint arXiv:1807.04587, 2018.

[12] M. F. Bear, B. W. Connors, and M. A. Paradiso, Neuroscience. Lippincott Williams & Wilkins, 2007, vol. 2.

[13] P. Dayan, L. F. Abbott, and L. Abbott, “Theoretical neuroscience: computational and mathematical modeling of neural systems,” 2001.

[14] S. T. Brady and L. Tai, “Cell biology of the nervous system,” in Basic Neurochemistry (Eighth Edition). Elsevier, 2012, pp. 3–25.

[15] S. Herculano-Houzel, “The human brain in numbers: a linearly scaled-up primate brain,” Frontiers in human neuroscience, vol. 3, p. 31, 2009.

[16] A. M. Zador, “A critique of pure learning: What artificial neural networks can learn from animal brains,” BioRxiv, p. 582643, 2019.

[17] J. DeFelipe and I. Fariñas, “The pyramidal neuron of the cerebral cortex: morphological and chemical characteristics of the synaptic inputs,” Progress in neurobiology, vol. 39, no. 6, pp. 563–607, 1992.

[18] S. Manita, T. Suzuki, C. Homma, T. Matsumoto, M. Odagawa, K. Yamada, K. Ota, C. Matsubara, A. Inutsuka, M. Sato et al., “A top-down cortical circuit for accurate sensory perception,” Neuron, vol. 86, no. 5, pp. 1304–1316, 2015. 95

[19] J. M. Budd, “Extrastriate feedback to primary visual cortex in primates: a quantitative analysis of connectivity,” Proceedings of the Royal Society of London B: Biological Sciences, vol. 265, no. 1400, pp. 1037–1044, 1998.

[20] M. Spratling, “Cortical region interactions and the functional role of apical dendrites,” Behavioral and cognitive neuroscience reviews, vol. 1, no. 3, pp. 219–228, 2002.

[21] M. E. Larkum, J. J. Zhu, and B. Sakmann, “A new cellular mechanism for coupling inputs arriving at different cortical layers,” Nature, vol. 398, no. 6725, p. 338, 1999.

[22] M. E. Larkum, J. Waters, B. Sakmann, and F. Helmchen, “Dendritic spikes in apical dendrites of neocortical layer 2/3 pyramidal neurons,” Journal of Neuroscience, vol. 27, no. 34, pp. 8999–9008, 2007.

[23] M. E. Larkum, T. Nevian, M. Sandler, A. Polsky, and J. Schiller, “Synaptic integration in tuft dendrites of layer 5 pyramidal neurons: a new unifying principle,” Science, vol. 325, no. 5941, pp. 756– 760, 2009.

[24] R. S. Kasevich and D. LaBerge, “Theory of electric resonance in the neocortical apical dendrite,” PLoS One, vol. 6, no. 8, p. e23412, 2011.

[25] W. Nernst, “Die elektromotorische wirksamkeit der jonen,” Zeitschrift für physikalische Chemie, vol. 4, no. 1, pp. 129–181, 1889.

[26] A. L. Hodgkin, A. F. Huxley, and B. Katz, “Measurement of current-voltage relations in the membrane of the giant axon of loligo,” The Journal of physiology, vol. 116, no. 4, pp. 424–448, 1952.

[27] Wikipedia. (2018) Action potential. [Online]. Available: https://en.wikipedia.org/wiki/Action_ potential

[28] M. Steriade, D. A. McCormick, and T. J. Sejnowski, “Thalamocortical oscillations in the sleeping and aroused brain,” Science, vol. 262, no. 5134, pp. 679–685, 1993.

[29] R. Naud and H. Sprekeler, “Burst ensemble multiplexing: A neural code connecting dendritic spikes with microcircuits,” bioRxiv, p. 143636, 2017.

[30] P. Gao, K. T. Sultan, X.-J. Zhang, and S.-H. Shi, “Lineage-dependent circuit assembly in the neocortex,” Development, vol. 140, no. 13, pp. 2645–2655, 2013.

[31] B. W. Connors and M. A. Long, “Electrical synapses in the mammalian brain,” Annu. Rev. Neurosci., vol. 27, pp. 393–418, 2004.

[32] T. C. Sudhof, “The synaptic vesicle cycle,” Annual review of neuroscience, vol. 27, p. 509, 2004.

[33] D. M. Rosenbaum, S. G. Rasmussen, and B. K. Kobilka, “The structure and function of g-proteincoupled receptors,” Nature, vol. 459, no. 7245, p. 356, 2009.

[34] A. Citri and R. C. Malenka, “Synaptic plasticity: multiple forms, functions, and mechanisms,” Neuropsychopharmacology, vol. 33, no. 1, p. 18, 2008.

[35] R. S. Zucker and W. G. Regehr, “Short-term synaptic plasticity,” Annual review of physiology, vol. 64, no. 1, pp. 355–405, 2002.

[36] D. O. Hebb et al., “The organization of behavior,” 1949.

[37] T. V. Bliss, A. Gardner-Medwin, and T. Lømo, “Synaptic plasticity in the hippocampal formation,” Macromolecules and behaviour, vol. 193, p. 203, 1973.

[38] T. V. Bliss and T. Lømo, “Long-lasting potentiation of synaptic transmission in the dentate area of the anaesthetized rabbit following stimulation of the perforant path,” The Journal of physiology, vol. 232, no. 2, pp. 331–356, 1973.

[39] G. G. Turrigiano and S. B. Nelson, “Homeostatic plasticity in the developing nervous system,” Nature Reviews Neuroscience, vol. 5, no. 2, p. 97, 2004. 96

[40] W. C. Abraham and M. F. Bear, “Metaplasticity: the plasticity of synaptic plasticity,” Trends in neurosciences, vol. 19, no. 4, pp. 126–130, 1996.

[41] J. Z. Tsien, P. T. Huerta, and S. Tonegawa, “The essential role of hippocampal ca1 nmda receptor– dependent synaptic plasticity in spatial memory,” Cell, vol. 87, no. 7, pp. 1327–1338, 1996.

[42] R. C. Malenka and M. F. Bear, “Ltp and ltd: an embarrassment of riches,” Neuron, vol. 44, no. 1, pp. 5–21, 2004.

[43] V. Chevaleyre, K. A. Takahashi, and P. E. Castillo, “Endocannabinoid-mediated synaptic plasticity in the cns,” Annu. Rev. Neurosci., vol. 29, pp. 37–76, 2006.

[44] J. A. Cummings, R. M. Mulkey, R. A. Nicoll, and R. C. Malenka, “Ca2+ signaling requirements for long-term depression in the hippocampus,” Neuron, vol. 16, no. 4, pp. 825–833, 1996.

[45] W. Gerstner, M. Lehmann, V. Liakoni, D. Corneil, and J. Brea, “Eligibility traces and plasticity on behavioral time scales: Experimental support of neohebbian three-factor learning rules,” Frontiers in Neural Circuits, 2018.

[46] W. Gerstner, R. Kempter, J. L. van Hemmen, and H. Wagner, “A neuronal learning rule for submillisecond temporal coding,” Nature, vol. 383, no. 6595, p. 76, 1996.

[47] Y. Dan and M.-m. Poo, “Spike timing-dependent plasticity of neural circuits,” Neuron, vol. 44, no. 1, pp. 23–30, 2004.

[48] Y. Dan and M.-M. Poo, “Spike timing-dependent plasticity: from synapse to perception,” Physiological reviews, vol. 86, no. 3, pp. 1033–1048, 2006.

[49] G. G. Turrigiano, K. R. Leslie, N. S. Desai, L. C. Rutherford, and S. B. Nelson, “Activity-dependent scaling of quantal amplitude in neocortical neurons,” Nature, vol. 391, no. 6670, p. 892, 1998.

[50] B. D. Philpot, K. K. Cho, and M. F. Bear, “Obligatory role of nr2a for metaplasticity in visual cortex,” Neuron, vol. 53, no. 4, pp. 495–502, 2007.

[51] F. Rosenblatt, “The perceptron–a perciving and recognizing automation,” Report 85-460-1 Cornell Aeronautical Laboratory, Ithaca, Tech. Rep., 1957.

[52] ——, “The perceptron: a probabilistic model for information storage and organization in the brain.” Psychological review, vol. 65, no. 6, p. 386, 1958.

[53] C. Börgers, An introduction to modeling neuronal dynamics. Springer, 2017, vol. 66.

[54] I. Goodfellow, Y. Bengio, A. Courville, and Y. Bengio, Deep learning. MIT press Cambridge, 2016, vol. 1.

[55] I. Goodfellow, J. Pouget-Abadie, M. Mirza, B. Xu, D. Warde-Farley, S. Ozair, A. Courville, and Y. Bengio, “Generative adversarial nets,” in Advances in neural information processing systems, 2014, pp. 2672–2680.

[56] M. Arjovsky, S. Chintala, and L. Bottou, “Wasserstein gan,” arXiv preprint arXiv:1701.07875, 2017.

[57] Y. LeCun, “Une procédure d’apprentissage pour réseau à seuil asymétrique,” proceedings of Cognitiva 85, pp. 599–604, 1985.

[58] L. Bottou and O. Bousquet, “The tradeoffs of large scale learning,” in Advances in neural information processing systems, 2008, pp. 161–168.

[59] D. Huber, D. Gutnisky, S. Peron, D. O’connor, J. Wiegert, L. Tian, T. Oertner, L. Looger, and K. Svoboda, “Multiple dynamic representations in the motor cortex during sensorimotor learning,” Nature, vol. 484, no. 7395, p. 473, 2012.

[60] A. Blumer, A. Ehrenfeucht, D. Haussler, and M. K. Warmuth, “Occam’s razor,” Information processing letters, vol. 24, no. 6, pp. 377–380, 1987.

[61] G. E. Hinton and R. R. Salakhutdinov, “Reducing the dimensionality of data with neural networks,” science, vol. 313, no. 5786, pp. 504–507, 2006. 97

[62] P. Vincent, H. Larochelle, Y. Bengio, and P.-A. Manzagol, “Extracting and composing robust features with denoising autoencoders,” in Proceedings of the 25th international conference on Machine learning. ACM, 2008, pp. 1096–1103.

[63] R. Brette, M. Rudolph, T. Carnevale, M. Hines, D. Beeman, J. M. Bower, M. Diesmann, A. Morrison, P. H. Goodman, F. C. Harris et al., “Simulation of networks of spiking neurons: a review of tools and strategies,” Journal of computational neuroscience, vol. 23, no. 3, pp. 349–398, 2007.

[64] S. Ghosh-Dastidar and H. Adeli, “Spiking neural networks,” International journal of neural systems, vol. 19, no. 04, pp. 295–308, 2009.

[65] A. N. Burkitt, “A review of the integrate-and-fire neuron model: I. homogeneous synaptic input,” Biological cybernetics, vol. 95, no. 1, pp. 1–19, 2006.

[66] M. B. Goodman, D. H. Hall, L. Avery, and S. R. Lockery, “Active currents regulate sensitivity and dynamic range in c. elegans neurons,” Neuron, vol. 20, no. 4, pp. 763–772, 1998.

[67] P. A. Merolla, J. V. Arthur, R. Alvarez-Icaza, A. S. Cassidy, J. Sawada, F. Akopyan, B. L. Jackson, N. Imam, C. Guo, Y. Nakamura et al., “A million spiking-neuron integrated circuit with a scalable communication network and interface,” Science, vol. 345, no. 6197, pp. 668–673, 2014.

[68] T. P. Lillicrap, D. Cownden, D. B. Tweed, and C. J. Akerman, “Random feedback weights support learning in deep neural networks,” arXiv preprint arXiv:1411.0247, 2014.

[69] A. Krizhevsky, V. Nair, and G. Hinton, “The cifar-10 dataset,” online: http://www. cs. toronto. edu/kriz/cifar. html, 2014.

[70] W. Xiao, H. Chen, Q. Liao, and T. Poggio, “Biologically-plausible learning algorithms can scale to large datasets,” Center for Brains, Minds and Machines (CBMM), Tech. Rep., 2018.

[71] A. Nøkland, “Direct feedback alignment provides learning in deep neural networks,” in Advances in neural information processing systems, 2016, pp. 1037–1045.

[72] A. Samadi, T. P. Lillicrap, and D. B. Tweed, “Deep learning with dynamic spiking neurons and fixed feedback weights,” Neural computation, vol. 29, no. 3, pp. 578–602, 2017.

[73] H. Luo, J. Fu, and J. Glass, “Bidirectional backpropagation: Towards biologically plausible error signal transmission in neural networks,” arXiv preprint arXiv:1702.07097, 2017.

[74] K. C. Bittner, C. Grienberger, S. P. Vaidya, A. D. Milstein, J. J. Macklin, J. Suh, S. Tonegawa, and J. C. Magee, “Conjunctive input processing drives feature selectivity in hippocampal ca1 neurons,” Nature neuroscience, vol. 18, no. 8, p. 1133, 2015.

[75] K. C. Bittner, A. D. Milstein, C. Grienberger, S. Romani, and J. C. Magee, “Behavioral time scale synaptic plasticity underlies ca1 place fields,” Science, vol. 357, no. 6355, pp. 1033–1036, 2017.

[76] J. Sherman, “Adjustment of an inverse matrix corresponding to changes in the elements of a given column or a given row of the original matrix,” Annals of mathematical statistics, vol. 20, no. 4, p. 621, 1949.

[77] C. D. Meyer, Jr, “Generalized inversion of modified matrices,” SIAM Journal on Applied Mathematics, vol. 24, no. 3, pp. 315–323, 1973.

[78] C. F. Gauss, Theoria motus corporum coelestium in sectionibus conicis solem ambientium. Perthes et Besser, 1809, vol. 7.

[79] R. W. Wedderburn, “Quasi-likelihood functions, generalized linear models, and the gauss—newton method,” Biometrika, vol. 61, no. 3, pp. 439–447, 1974.

[80] W. contributors, “Gauss-Newton algorithm,” 2019, online; accessed 5-June-2019. [Online]. Available: https://en.wikipedia.org/w/index.php?title=Gauss%E2%80%93Newton_algorit…; oldid=893757020

[81] J. J. Moré, “The Levenberg-Marquardt algorithm: implementation and theory,” in Numerical analysis. Springer, 1978, pp. 105–116. 98

[82] E. H. Moore, “On the reciprocal of the general algebraic matrix,” Bull. Am. Math. Soc., vol. 26, pp. 394–395, 1920.

[83] R. Penrose, “A generalized inverse for matrices,” in Mathematical proceedings of the Cambridge philosophical society, vol. 51, no. 3. Cambridge University Press, 1955, pp. 406–413.

[84] J. Martens and R. Grosse, “Optimizing neural networks with kronecker-factored approximate curvature,” in International conference on machine learning, 2015, pp. 2408–2417.

[85] A. Botev, H. Ritter, and D. Barber, “Practical Gauss-Newton optimisation for deep learning,” in Proceedings of the 34th International Conference on Machine Learning-Volume 70. JMLR. org, 2017, pp. 557–565.

[86] S. Chen, C. Cowan, S. Billings, and P. Grant, “Parallel recursive prediction error algorithm for training layered neural networks,” International Journal of control, vol. 51, no. 6, pp. 1215–1228, 1990.

[87] N. N. Schraudolph, “Fast curvature matrix-vector products for second-order gradient descent,” Neural computation, vol. 14, no. 7, pp. 1723–1738, 2002.

[88] B. T. Polyak, “Some methods of speeding up the convergence of iteration methods,” USSR Computational Mathematics and Mathematical Physics, vol. 4, no. 5, pp. 1–17, 1964.

[89] Y. Nesterov, “A method of solving a convex programming problem with convergence rate o (1/k2),” in Sov. Math. Dokl, vol. 27, no. 2.

[90] I. Sutskever, J. Martens, G. Dahl, and G. Hinton, “On the importance of initialization and momentum in deep learning,” in International conference on machine learning, 2013, pp. 1139–1147.

[91] J. Duchi, E. Hazan, and Y. Singer, “Adaptive subgradient methods for online learning and stochastic optimization,” Journal of Machine Learning Research, vol. 12, no. Jul, pp. 2121–2159, 2011.

[92] D. P. Kingma and J. Ba, “Adam: A method for stochastic optimization,” arXiv preprint arXiv:1412.6980, 2014.

[93] K. Levenberg, “A method for the solution of certain non-linear problems in least squares,” Quarterly of applied mathematics, vol. 2, no. 2, pp. 164–168, 1944.

[94] D. W. Marquardt, “An algorithm for least-squares estimation of nonlinear parameters,” Journal of the society for Industrial and Applied Mathematics, vol. 11, no. 2, pp. 431–441, 1963.

[95] H. O. Hartley, “The modified gauss-newton method for the fitting of non-linear regression functions by least squares,” Technometrics, vol. 3, no. 2, pp. 269–280, 1961.

[96] M. Rudelson and R. Vershynin, “The littlewood–offord problem and invertibility of random matrices,” Advances in Mathematics, vol. 218, no. 2, pp. 600–633, 2008.

[97] A. Pinkus, “Approximation theory of the mlp model in neural networks,” Acta numerica, vol. 8, pp. 143–195, 1999.

[98] M. Akrout, C. Wilson, P. C. Humphreys, T. Lillicrap, and D. Tweed, “Using weight mirrors to improve feedback alignment,” arXiv preprint arXiv:1904.05391, 2019.

[99] A. Ben-Israel and D. Cohen, “On iterative computation of generalized inverses and associated projections,” SIAM Journal on Numerical Analysis, vol. 3, no. 3, pp. 410–419, 1966.

[100] A. Y. Ng, “Feature selection, l 1 vs. l 2 regularization, and rotational invariance,” in Proceedings of the twenty-first international conference on Machine learning. ACM, 2004, p. 78.

[101] S. Ioffe and C. Szegedy, “Batch normalization: Accelerating deep network training by reducing internal covariate shift,” arXiv preprint arXiv:1502.03167, 2015.

[102] A. D. Wyner, “Random packings and coverings of the unit n-sphere,” The Bell System Technical Journal, vol. 46, no. 9, pp. 2111–2118, 1967.

[103] A. Paszke, S. Gross, S. Chintala, G. Chanan, E. Yang, Z. DeVito, Z. Lin, A. Desmaison, L. Antiga, and A. Lerer, “Automatic differentiation in pytorch,” 2017. 99

[104] N. L. Golding and N. Spruston, “Dendritic sodium spikes are variable triggers of axonal action potentials in hippocampal ca1 pyramidal neurons,” Neuron, vol. 21, no. 5, pp. 1189–1200, 1998.

[105] N. L. Golding, N. P. Staff, and N. Spruston, “Dendritic spikes as a mechanism for cooperative longterm potentiation,” Nature, vol. 418, no. 6895, p. 326, 2002.

[106] R. Urbanczik and W. Senn, “Learning by the dendritic prediction of somatic spiking,” Neuron, vol. 81, no. 3, pp. 521–528, 2014.

[107] J. A. Suykens, B. L. De Moor, and J. Vandewalle, “NLq theory: a neural control framework with global asymptotic stability criteria,” Neural Networks, vol. 10, no. 4, pp. 615–637, 1997.

[108] J. A. Suykens, J. Vandewalle, and B. L. De Moor, “NLq theory: checking and imposing stability of recurrent neural networks for nonlinear modeling,” IEEE Transactions on Signal Processing, vol. 45, no. 11, pp. 2682–2691, 1997.

[109] H.-J. Pi, B. Hangya, D. Kvitsiani, J. I. Sanders, Z. J. Huang, and A. Kepecs, “Cortical interneurons that specialize in disinhibitory control,” Nature, vol. 503, no. 7477, p. 521, 2013.

[110] J. Veit, R. Hakim, M. P. Jadi, T. J. Sejnowski, and H. Adesnik, “Cortical gamma band synchronization through somatostatin interneurons,” Nature neuroscience, vol. 20, no. 7, p. 951, 2017.

[111] A. M. Saxe, J. L. McClelland, and S. Ganguli, “Exact solutions to the nonlinear dynamics of learning in deep linear neural networks,” arXiv preprint arXiv:1312.6120, 2013.

[112] “Wikipedia: Moore-penrose inverse,” https://en.wikipedia.org/wiki/Moore\T1\textendashPenrose_ inverse, 2019, accessed: 2019-03-02.