Zijn jouw muziekgedachten te kraken? Reconstructie van beluisterde en ingebeelde muziek uit hersenactiviteit

‘Is dit realiteit, of slechts fantasie?’ Freddie Mercury zong er al over in 1975. Misschien spoken de volgende lijnen van dit legendarische lied nu door je hoofd. Een privéconcert in jouw brein dat alleen jij kan horen... Maar wat zou je doen als ik je vertel dat ik jouw ‘muziekgedachten’ kan raden?

Het muzikale brein

Heb je ooit al eens nagedacht wat voor een prachtig en complex proces muziek in onze hersenen opwekt? We kunnen een lied meezingen of meespelen op een instrument, of zin krijgen om te dansen. Onze stemming kan erdoor veranderen of het kan ons doen herinneren aan dat éne moment in ons leven. Zelfs zonder externe geluidsbron kunnen we ons perfect inbeelden hoe ons lievelingslied klinkt op de radio! Misschien blijft het nummer wel in je gedachten spelen, als een echte oorwurm, vaak tot vervelens toe...

Muziek wekt veel verschillende reacties op in ons brein, daardoor weten we dat een groot aantal gebieden in de hersenen actief zijn tijdens het beluisteren en inbeelden van muziek. Hoe al deze hersengebieden precies samenwerken tijdens het beluisteren of bedenken van een specifiek lied, is echter nog niet geweten. Die kennis zou tot allerlei toepassingen leiden waarbij we ons helemaal in sciencefiction films wanen. Wanneer je de volgende keer muziek beluistert of je een lied inbeeldt, stel jezelf dan de volgende vraag: zou het mogelijk zijn om vanuit jouw hersenactiviteit een lied te reconstrueren? Meer nog, zouden we jouw ‘muziekgedachten’ kunnen lezen en zeggen welk lied je aan het beluisteren/bedenken bent?

Er was eens een gekke muts...

Om dit te onderzoeken, is er allereerst een manier nodig om de muziekactiviteit te meten. Die activiteit bestaat uit de werking van onze neuronen, die via elektrische signalen - of ionenstromen - met elkaar communiceren. Deze ionenstromen zijn meetbaar, bijvoorbeeld via een elektro-encefalogram (EEG). Dit toestel bestaat uit talrijke elektroden die door middel van een soort muts op het hoofd geplaatst worden, om hersensignalen synchroon doorheen de tijd kunnen meten op verschillende locaties.

Op die manier luisteren proefpersonen in dit onderzoek naar afgespeelde liedjes of beelden ze zich liedjes in. De muziekkeuze is daarbij zeer gevarieerd: van kinderliedjes tot orkestwerken, met songteksten of puur instrumentaal... Bij elk van deze liedjes wordt de hersenactiviteit van de personen op alle elektrodelocaties geregistreerd.

Van hersenactiviteit naar liedje

Hoe reconstrueren we hier nu het beluisterde/ingebeelde lied uit?

Allereerst wordt bepaald welke kenmerken van een lied er precies gereconstrueerd dienen te worden. Daarbij wordt elk lied vanuit een complex audiosignaal omgezet naar een vereenvoudigde vorm met lage frequenties. Ook bij de EEG metingen worden verder alleen dezelfde lage frequenties gebruikt.

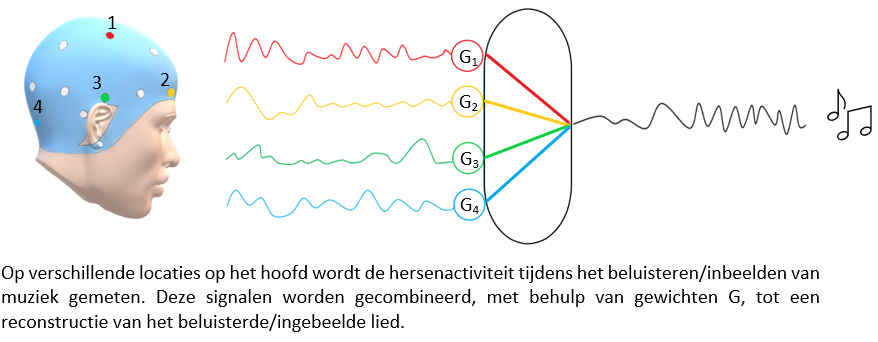

Daarna wordt er voor ieder liedje en proefpersoon een model opgesteld. Dit betekent dat de metingen op alle locaties met elkaar gecombineerd worden, waarbij elke meting een ander gewicht – of belang – krijgt. Deze gewichten zijn op voorhand bepaald, door middel van machine learning. Machine learning laat een computer leren zoals een mens dat doet: door te trainen op voorbeelden, in dit geval andere beluisterde liedjes. Uiteindelijk leidt dit model tot één enkel signaal doorheen de tijd: de reconstructie van het overeenkomstige liedje, dat ideaal gezien zo goed mogelijk lijkt op het originele lied.

Wanneer we deze gereconstrueerde liedjes vergelijken met de originele voor het beluisteren van muziek, merken we voor deze techniek een algemeen goed resultaat op. Voor zo’n complex orgaan als de hersenen is het bijzonder dat goede resultaten gevonden worden met een simpele combinatie van signalen. Deze reconstructies leiden verder ook tot een verrassende resultaat qua muziektype: zo wordt volledig instrumentale muziek algemeen beter gereconstrueerd dan liedjes met een songtekst.

Voor ingebeelde muziek is het eerste resultaat echter niet goed, om twee redenen. Ten eerste zijn er veel mogelijkheden om ‘fouten’ – bijvoorbeeld qua tempo – te maken tijdens het inbeelden van muziek. Dit is echter een zeer complex probleem waarvan de oplossing niet voor de hand ligt. Daarnaast is het mogelijk dat proefpersonen pas op een later tijdstip van de metingen zich een lied beginnen in te beelden, waardoor een deel van de metingen onbruikbaar wordt. Door het startpunt van de metingen in het model te verleggen, worden ingebeelde liedjes gereconstrueerd die een significante gelijkenis vertonen met de originele muziek, wat een volledig nieuw resultaat in het onderzoek naar muziek en het brein oplevert.

Zijn jouw muziekgedachten te kraken?

Op basis van deze muziekreconstructies kunnen we raden welk liedje deze proefpersonen in gedachten hebben.

De methode die daarvoor gebruikt wordt kan gezien worden als een ‘stille’ versie van populaire apps zoals ‘Shazam’ op kleine schaal, maar dan voor het brein. De gereconstrueerde liedjes worden vergeleken met de gehele databank van alle originele liedjes die beluisterd/ingebeeld zijn, waarbij we een ‘match’ aanduiden met het meest vergelijkbare liedje. Zo kan een liedje geraden worden, puur gebaseerd op muzikale hersenactiviteit, zowel voor beluisterde als ingebeelde muziek. Daarnaast kunnen deze liedjes ook geklasseerd worden volgens muziektype (songteksten,instrumentaal...).

Uit dit onderzoek is aangetoond dat beluisterde/ingebeelde liedjes kunnen gereconstrueerd worden vanuit de hersenactiviteit van proefpersonen. Meer nog, met deze reconstructies kunnen we naast beluisterde, ook ingebeelde liedjes raden! Deze nieuwe resultaten van dit onderzoek werden in samenwerking met de mentor en promotor van deze thesis ingediend voor publicatie.

‘Is dit realiteit, of slechts fantasie?’ Misschien zijn futuristische toepassingen dan toch niet zo veraf meer...

Bibliografie

[1] Anderson, D. J., Rose, J. E., Hind, J. E., and Brugge, J. F. Temporal position of discharges in single auditory nerve fibers within the cycle of a sinewave

stimulus: frequency and intensity effects. The Journal of the Acoustical Society of America 49, 4B (1971), Suppl 2:1131+.

[2] Bear, M. F., Connors, B. W., and Paradiso, M. A. Neuroscience:

exploring the brain, 4th ed. ed. Philadelphia : Wolters Kluwer, 2016.

[3] Biesmans, W., Das, N., Francart, T., and Bertrand, A. Auditoryinspired

speech envelope extraction methods for improved EEG-based auditory attention detection in a cocktail party scenario. IEEE Transactions on Neural Systems and Rehabilitation Engineering 25, 5 (2017), 402–412.

[4] Biosemi. Faq. https://www.biosemi.com/faq/cms&drl.htm.

[5] Blockeel, H. Machine learning and inductive inference, 5de, herz. uitg. ed. Acco, Leuven, 2019.

[6] Brusheezy. Moderne muziek notities kwast.

[7] Cantisani, G., Essid, S., and Richard, G. EEG-based decoding of auditory attention to a target instrument in polyphonic music. In 2019 IEEE Workshop on Applications of Signal Processing to Audio and Acoustics (WASPAA) (2019),

vol. 2019-, IEEE, pp. 80–84.

[8] Chittka, L., and Brockmann, A. Perception space-the final frontier (primer). PLoS Biology 3, 4 (2005), e137.

[9] Ciccarelli, G., Nolan, M., Perricone, J., Calamia, P. T., Haro,

S., O’Sullivan, J., Mesgarani, N., Quatieri, T. F., and Smalt, C. J.

Comparison of two-talker attention decoding from EEG with nonlinear neural

networks and linear methods. Scientific Reports 9, 1 (2019).

[10] de Cheveigné, A., Wong, D. D. E., Di Liberto, G. M., Hjortkjaer,

J., Slaney, M., and Lalor, E. Decoding the auditory brain with canonical

component analysis. Neuroimage 172 (2018), 206–216.

85

[11] Di Liberto, G., Pelofi, C., Shamma, S., and de Cheveigné, A. Musical

expertise enhances the cortical tracking of the acoustic envelope during

naturalistic music listening. Acoustical Science and Technology 41, 1 (2020),

361–364.

[12] Di Liberto, G. M., Pelofi, C., Bianco, R., Patel, P., Mehta, A. D.,

Herrero, J. L., de Cheveigné, A., Shamma, S., and Mesgarani, N.

Cortical encoding of melodic expectations in human temporal cortex. eLife 9

(2020).

[13] Etard, O., Kegler, M., Braiman, C., Forte, A. E., and Reichenbach,

T. Decoding of selective attention to continuous speech from the human auditory

brainstem response. NeuroImage 200 (2019), 1–11.

[14] Fuglsang, S. A., Dau, T., and Hjortkjaer, J. Noise-robust cortical

tracking of attended speech in real-world acoustic scenes. NeuroImage 156

(2017), 435–444.

[15] Gallun, F., Lewis, M., Folmer, R., Diedesch, A., Kubli, L., Mcdermott,

D., Walden, T., Fausti, S., Lew, H., and Leek, M. Implications of

blast exposure for central auditory function: A review. Journal of Rehabilitation

Research and Development 49, 7 (2012), 1059–74.

[16] Gang, N., Kaneshiro, B., Berger, J., and Dmochowski, J. P. Decoding

neurally relevant musical features using canonical correlation analysis. In

Proceedings of the 18th International Society for Music Information Retrieval

Conference, ISMIR 2017, pp. 131–138.

[17] Grossman, D. J. Dave’s j. s. bach page. http://www.jsbach.net/.

[18] Kucikienè, D., and Praninskienè, R. u. The impact of music on the

bioelectrical oscillations of the brain. Acta medica Lituanica 25, 2 (2018),

101–106.

[19] Landegger, L. D., Vasilijic, S., Fujita, T., Soares, V. Y., Seist, R.,

Xu, L., and Stankovic, K. M. Cytokine levels in inner ear fluid of young

and aged mice as molecular biomarkers of noise-induced hearing loss. Frontiers

in Neurology 10 (2019).

[20] Leuchs, L. Choosing your reference - and why it matters. Brain Products

(03-05-2019).

[21] Lu, J., Wu, D., Yang, H., Luo, C., Li, C., and Yao, D. Scale-free

brain-wave music from simultaneously EEG and fMRI recordings (scale-free

brain-wave music). e49773.

[22] The Mathworks, Inc. MATLAB version R2019b. Natick, Massachusetts,

2019.

86

[23] Matlab. Linear mixed-effects models. https://www.mathworks.com/help/stats/

linear-mixed-effects-models.html.

[24] Matlab. Wilcoxon signed rank test (signrank).

https://www.mathworks.com/help/stats/signrank.html.

[25] Meister, I., Krings, T., Foltys, H., Boroojerdi, B., Müller, M.,

Töpper, R., and Thron, A. Effects of long-term practice and task complexity

in musicians and nonmusicians performing simple and complex motor tasks:

Implications for cortical motor organization. Human Brain Mapping 25, 3 (2005),

345–352.

[26] Microsoft Corporation. Paint3D, 3D Library.

[27] Mueller, K., Mildner, T., Fritz, T., Lepsien, J., Schwarzbauer, C.,

Schroeter, M. L., and Möller, H. E. Investigating brain response to

music: A comparison of different fMRI acquisition schemes. NeuroImage 54, 1

(2011), 337–343.

[28] Neuroscientifically Challenged. 2-minute neuroscience: Electroencephalography

(EEG). https://www.youtube.com/watch?v=tZcKT4lJZk.

[29] New York Times. Dr. Georg von Bekesy, 73, dies; ‘61 Nobel Laureate in

Medicine.

[30] Oldendorf, W., and Oldendorf, W. Advantages and Disadvantages of

MRI. In: Basics of Magnetic Resonance Imaging.Topics in Neurology (Oldendorf,

Basics of Magnetic Resonance Imaging), vol 1. Springer, Boston, MA.

[31] O’Sullivan, J. A., Power, A. J., Mesgarani, N., Rajaram, S., Foxe,

J. J., Shinn-Cunningham, B. G., Slaney, M., Shamma, S. A., and Lalor,

E. C. Attentional selection in a cocktail party environment can be decoded

from single-trial EEG. Cerebral Cortex 25, 7 (2015), 1697–1706.

[32] Rangayyan, R. M. Biomedical signal analysis, 2nd ed. ed. IEEE Press series

in biomedical engineering. Wiley, Hoboken, New Jersey, 2015.

[33] Schaefer, R. S., Farquhar, J., Blokland, Y., Sadakata, M., and Desain,

P. Name that tune: Decoding music from the listening brain. Neuroimage

56, 2 (2011), 843–849.

[34] Sebastian, S. Toward studying music cognition with information retrieval techniques:

Lessons learned from the OpenMIIR initiative. Frontiers in Psychology

8 (2017).

[35] Somers, B., Francart, T., and Bertrand, A. A generic EEG artifact

removal algorithm based on the multi-channel wiener filter. Journal of Neural

Engineering 15, 3 (2018).

87

[36] Stober, S., Sternin, A., Owen, A. M., and Grahn, J. A. Towards

music imagery information retrieval: Introducing the OpenMIIR dataset of EEG

recordings from music perception and imagination. In Proceedings of the 16th

International Society for Music Information Retrieval Conference, ISMIR 2015,

pp. 763–769.

[37] Sturm, I., Dahne, S., Blankertz, B., and Curio, G. Multi-variate EEG

analysis as a novel tool to examine brain responses to naturalistic music stimuli.

Plos One 10, 10 (2015).

[38] Suetens, P. Fundamentals of medical imaging, 3rd ed. ed. Cambridge University

Press, Cambridge, 2017.

[39] Tal, I., Large, E. W., Rabinovitch, E., Wei, Y., Schroeder, C. E.,

Poeppel, D., and Zion Golumbic, E. Neural entrainment to the beat: The

"missing-pulse" phenomenon. The Journal of neuroscience : the official journal

of the Society for Neuroscience 37, 26 (2017), 6331–6341.

[40] Tempel, B. L. Nub502: The auditory system.

[41] Treder, M. S., Purwins, H., Miklody, D., Sturm, I., and Blankertz,

B. Decoding auditory attention to instruments in polyphonic music using

single-trial EEG classification. Journal of Neural Engineering 11, 2 (2014), 10.

[42] van der Mee, T., Reijntjens, M., Schaefer, R., and

Scherder, E. Algemeen Dagblad. Dit is wat muziek met ons brein

doet. https://www.ad.nl/wetenschap/dit-is-wat-muziek-met-ons-breindoet

a80871d6/?referrer=https://www.google.com/, 20-01-2019.

[43] Verschueren, E., Somers, B., and Francart, T. Neural envelope tracking

as a measure of speech understanding in cochlear implant users. Hearing Research

373 (2019), 23–31.

[44] Wong, D. D. E., Fuglsang, S. A., Hjortkjaer, J., Ceolini, E., Slaney,

M., and de Cheveigné, A. A comparison of regularization methods in forward

and backward models for auditory attention decoding. Frontiers in Neuroscience

12 (2018).

[45] Yurgil, K. A., Velasquez, M. A., Winston, J. L., Reichman, N. B.,

and Colombo, P. J. Music training, working memory, and neural oscillations:

A review. Frontiers in psychology 11 (2020), 266–266.

88