Koop een hangmat en laat AI je werk doen.

Stel dat je een machine zou kunnen maken die je baan overneemt, dan zou nooit nog hoeven te werken. Alleen maandelijks een factuurtje sturen voor de geleverde prestaties. Verder is het elke dag vakantie. Heerlijk toch? Miguel de Cervantès wist het al : 'L'homme qui travaille perd un temps précieux.'

Het klinkt een beetje als een scenario uit een strip en dat is niet zo vreemd want ik ben ruim twintig jaar fulltime stripauteur. Maar met de komst van AI wordt dit soort fictie werkelijkheid en daarom vroeg ik mij af of AI ook strips zou kunnen maken. Grappige, mooi getekende strips waarvan je onmogelijk kan merken dat ze door een machine werden vervaardigd. Ik zou die dan naar mijn uitgever sturen zonder het creatieproces te onthullen en zelf de auteursrechten innen. Ik was benieuwd hoe lang het zou duren voor iemand mijn werkwijze doorkreeg. Vanuit deze vraag ben ik een paar jaar geleden master of AI gaan studeren aan de KU Leuven. In het kader van mijn masterproef heb ik mijn eigen strips aan algoritmes gegeven en onderzocht hoe goed ze het ervan af brachten om mijn tekenstijl onder de knie te krijgen.

Onderzoek

Hoe moeilijk is het om een tekenstijl aan te leren met een beperkt aantal bestaande stripalbums? Die vraag is niet nieuw. Alleen wordt ze zelden gesteld door auteurs die dromen van een leven in een hangmat. In de stripindustrie stelt ze zich steeds als een succesvol auteur overlijdt of met pensioen gaat. Er worden dan jonge getalenteerde tekenaars aangezocht om de populaire serie verder te zetten. Zo besliste de uitgeverij Dupuis kortgeleden nog om Guust Flater van Franquin te laten tekenen door de Canadees Delaf. In een interview met ActuaBD verklapte hij zijn werkwijze: 'Ik heb gedurende drie jaar ruim 10.000 voorbeelden opgezocht van elk object of personage tot ik volledig doorhad hoe Franquin de werkelijkheid interpreteert in zijn zwierige stijl.'

Dat is hoe mensen te werk gaan. Als we een strip lezen, begrijpen we de tekeningen ook al zijn het vereenvoudigde, karikaturale weergaven van de werkelijkheid. Machines zijn hierin voorlopig beperkter. Ze begrijpen de werkelijkheid namelijk niet. In het beste geval kunnen ze met een verzameling beelden leren om nieuwe beelden te creëren die er exact hetzelfde uitzien zonder dat het kopieën zijn. Voor dit soort toepassingen bestaan sinds 2014 de zogenaamde GAN's (General Adversarial Networks). Die maken gebruik van een simpel maar geniaal trucje. Een GAN bestaat uit twee algoritmes die tegen elkaar strijden. De eerste, de generator, probeert zo goed mogelijk om een beeld te maken in de stijl van de voorbeeldset. Zo'n gegeneerd beeld noemen we een vals beeld. De tweede, de discriminator, probeert om een vals beeld van een echt te onderscheiden. Wanneer dat niet meer lukt, is de generator een geslaagde imitator.

Dit soort netwerken hebben op korte tijd furore gemaakt op datasets waarvan er veel beelden voorradig zijn, bijvoorbeeld, zoals menselijke gezichten. Het internet puilt namelijk uit van de foto's. Door GAN's te trainen op miljarden gezichten, kunnen we tegenwoordig perfecte portretfoto's genereren van mensen die nooit bestaan hebben. In video leiden die netwerken tot de befaamde deep fake video's. Van strips bestaan er slechts een beperkt aantal boeken. Guust Flater duikt op in negentien albums. Omgerekend is dat een dataset van 10.000 tekeningen. Bovendien zijn de tekeningen veel diverser dan een verzameling portretfoto's. Als een gezicht netjes bijgesneden is, dan bevinden de ogen, neus en mond zich ongeveer op dezelfde positie. De variatie is dan relatief beperkt. Bij strips toont elk vakje een andere scene. De personages kunnen zich overal bevinden en de decors veranderen voortdurend.

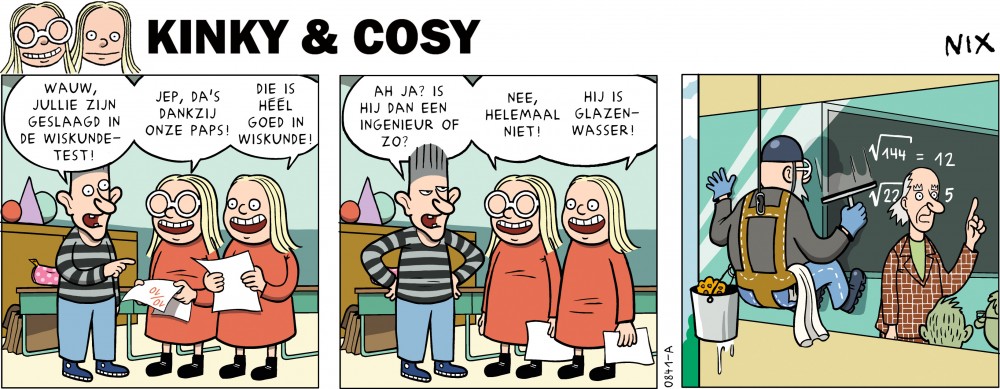

Kinky & Cosy

Als dataset gebruikte ik beelden van mijn reeks Kinky & Cosy. Dat is een krantenstrip die ontstond in De Morgen en daarna internationale publicaties kende tot in Le Monde. Heel even was de reeks als tekenfilm te zien in het programma Volt op Eén. De hoofdpersonages zijn een blonde tweeling in rode jurkjes en ze worden vergezeld van honderd nevenpersonages. Dat geeft meteen een idee van de grote variatie in de tekeningen. Bovendien zijn er geen miljoenen beelden van. Uit de tekenfilmpjes werden twee datasets geselecteerd. Een eerste bestaat uit 56.000 beelden die voldoende verschillend zijn en vierkant bijgesneden. Een tweede concentreert zich enkel op de hoofdpersonages en telt slechts 8.500 tekeningen.

De netwerken die ik trainde zijn de zogenaamde DCGAN, WGAN en Stylegan2-ADA. Dat zijn opvolgers van de allereerste GAN waarbij er gesleuteld werd aan de architectuur met het oog op betere resultaten. Ondanks de beperkte omvang en de grote diversiteit van de datasets, kreeg ik toch verbazingwekkend goede imitaties. Vooral de tweede dataset leverde na training met Stylegan2-ADA valse beelden op die haast vlekkeloos leken op de originele. Dat is goed nieuws en tegelijk slecht nieuws. Een GAN heeft dus duidelijk baat bij minder diversiteit. Deze belangrijke beperking wordt veroorzaakt door het gebrek aan kennis van de echte wereld. Het levert een afweging op tussen diversiteit en nauwkeurigheid van de tekeningen.

De latente ruimte

Maar wat ben je nu met een netwerk dat willekeurige beelden kan maken, ook al zijn ze stilistisch perfect? De eerstvolgende stap is natuurlijk de generator te sturen tot ik de beelden krijg die ik wil. En daarvoor lijkt een toevallige ontdekking tijdens mijn experimenten beloftevol. Toen ik bij een getraind netwerk de latente ruimte verkende, ontdekte ik semantisch betekenisvolle richtingen. De latente ruimte zou je de verbeelding van het netwerk kunnen noemen. Een richting is semantisch betekenisvol als je vertrekkend vanuit een beeld nieuwe beelden genereert waarbij slecht één gegeven wijzigt . Zo ontdekte ik richtingen waarbij een personage alleen het hoofd draaide. Dat zou in een latere fase kunnen toestaan om een hoofd in een gewenste positie te plaatsen .

Gesteld dat ik dan stripplaatjes kan maken die er uitzien alsof ik ze zelf getekend heb, dan moet er natuurlijk nog een scenario bedacht worden. Daarvoor bestaan er goed presterende algoritmes met even cryptische namen als GPT-2 en GPT-3. Het zal dus nog wel even duren voor ik in mijn hangmat lig.

Bibliografie

[Abdal et al., 2019a] Abdal, R., Qin, Y., and Wonka, P. (2019a). Image2stylegan++: How to edit the embedded images? CoRR, abs/1911.11544.

[Abdal et al., 2019b] Abdal, R., Qin, Y., and Wonka, P. (2019b). Image2stylegan: How to embed images into the stylegan latent space? CoRR, abs/1904.03189.

[Arjovsky et al., 2017] Arjovsky, M., Chintala, S., and Bottou, L. (2017). Wasserstein gan.

[Augereau et al., 2018] Augereau, O., Iwata, M., and Kise, K. (2018). A survey of comics research in computer science. Journal of Imaging, 87(4).

[Brock et al., 2018] Brock, A., Donahue, J., and Simonyan, K. (2018). Large scale GAN training for high fidelity natural image synthesis. CoRR, abs/1809.11096.

[Cao et al., 2014] Cao, Y., Lau, R. W. H., and Chan, A. B. (2014). Look over here: Attention-directing composition of manga elements. ACM Trans. Graph., 33(4).

[Chen et al., 2020] Chen, J., Liu, G., and Chen, X. (2020). Animegan: A novel lightweight gan for photo animation. In Li, K., Li, W., Wang, H., and Liu, Y., editors, Artificial Intelligence Algorithms and Applications, pages 242–256, Singapore. Springer Singapore.

[Creswell et al., 2018] Creswell, A., White, T., Dumoulin, V., Arulkumaran, K., Sengupta, B., and Bharath, A. A. (2018). Generative adversarial networks: An overview. IEEE Signal Processing Magazine, 35(1):53–65.

[Detournay, 2022] Detournay, C.-L. (2022). La reprise de gaston lagaffe : imitation, hommage ou plagiat? ActuaBD.

[Domingos, 2012] Domingos, P. (2012). A few useful things to know about machine learning. Communications of the ACM, 55(10):78–87.

[Goodfellow et al., 2014] Goodfellow, I. J., Pouget-Abadie, J., Mirza, M., Xu, B., Warde-Farley, D., Ozair, S., Courville, A., and Bengio, Y. (2014). Generative adversarial networks.

[Heusel et al., 2017] Heusel, M., Ramsauer, H., Unterthiner, T., Nessler, B., and Hochreiter, S. (2017). Gans trained by a two time-scale update rule converge to a local nash equilibrium.

[Inkawhich, 2022] Inkawhich, N. (2022). DCGAN tutorial. https://pytorch.org/ tutorials/beginner/dcgan_faces_tutorial.html.

[Jin et al., 2017] Jin, Y., Zhang, J., Li, M., Tian, Y., Zhu, H., and Fang, Z. (2017). Towards the automatic anime characters creation with generative adversarial networks.

[Karras et al., 2017] Karras, T., Aila, T., Laine, S., and Lehtinen, J. (2017). Pro- gressive growing of gans for improved quality, stability, and variation.

[Karras et al., 2020] Karras, T., Aittala, M., Hellsten, J., Laine, S., Lehtinen, J., and Aila, T. (2020). Training generative adversarial networks with limited data.

[Karras and Hellsten, 2021] Karras, T. and Hellsten, J. (2021). Stylegan2- ada — official pytorch implementation. https://github.com/NVlabs/ stylegan2-ada-pytorch.

[Karras et al., 2018] Karras, T., Laine, S., and Aila, T. (2018). A style-based generator architecture for generative adversarial networks.

[Karras et al., 2019] Karras, T., Laine, S., Aittala, M., Hellsten, J., Lehtinen, J., and Aila, T. (2019). Analyzing and improving the image quality of stylegan.

[Kodali et al., 2017] Kodali, N., Abernethy, J., Hays, J., and Kira, Z. (2017). On convergence and stability of gans.

[Liu et al., 2020] Liu, M.-Y., Huang, X., Yu, J., Wang, T.-C., and Mallya, A. (2020). Generative adversarial networks for image and video synthesis: Algorithms and applications.

[Long, 2020] Long, L. T. (2020). Photo animation for everyone. https://animegan. js.org/. Accessed: 2022-07-26.

[Lucic et al., 2017] Lucic, M., Kurach, K., Michalski, M., Gelly, S., and Bousquet, O. (2017). Are gans created equal? a large-scale study.

[Marchesi, 2017] Marchesi, M. (2017). Megapixel size image creation using generative adversarial networks.

[Mescheder et al., 2018] Mescheder, L., Geiger, A., and Nowozin, S. (2018). Which training methods for gans do actually converge?

[Morris, 2021] Morris, D. (2021). Synthesizing comics via conditional generative adversarial networks. http://resolver.tudelft.nl/uuid: 2a21a50a-81c4-4d0d-9dbc-5dbce67f2936.

[Pan et al., 2019] Pan, Z., Yu, W., Yi, X., Khan, A., Yuan, F., and Zheng, Y. (2019). Recent progress on generative adversarial networks (gans): A survey. IEEE Access, 7:36322–36333.

[Proven-Bessel et al., 2021] Proven-Bessel, B., Zhao, Z., and Chen, L. Y. (2021). Comicgan: Text-to-comic generative adversarial network. CoRR, abs/2109.09120.

[Radford et al., 2015] Radford, A., Metz, L., and Chintala, S. (2015). Unsupervised representation learning with deep convolutional generative adversarial networks.

[Salimans et al., 2016] Salimans, T., Goodfellow, I. J., Zaremba, W., Cheung, V., Radford, A., and Chen, X. (2016). Improved techniques for training gans. CoRR, abs/1606.03498.

[Saswat, 2020] Saswat, D. (2020). Wgan-pytorch. https://github.com/saswatpp/ WGAN-pytorch.

[Sauer et al., 2022] Sauer, A., Schwarz, K., and Geiger, A. (2022). Stylegan-xl: Scaling stylegan to large diverse datasets.

[Shen and Zhou, 2020] Shen, Y. and Zhou, B. (2020). Closed-form factorization of latent semantics in gans. CoRR, abs/2007.06600.

[Vasily, 2019] Vasily, K. (2019). Awesome pretrained stylegan2. https://github. com/justinpinkney/awesome-pretrained-stylegan2.

[Veale, 2022] Veale, T. (2022). Two-fisted comics generation: Comics as a medium and as a representation for creative meaning. https: //computationalcreativity.net/iccc22/wp-content/uploads/2022/06/ ICCC-2022_19L_Veale.pdf.

[White, 2016] White, T. (2016). Sampling generative networks.

[Wiatrak et al., 2019] Wiatrak, M., Albrecht, S. V., and Nystrom, A. (2019). Stabi- lizing generative adversarial networks: A survey.

[Xu et al., 2017] Xu, T., Zhang, P., Huang, Q., Zhang, H., Gan, Z., Huang, X., and He, X. (2017). Attngan: Fine-grained text to image generation with attentional generative adversarial networks.