ARTIFICIËLE INTELLIGENTIE (AI) EN BETEKENISVOLLE TRANSPARANTIE; Een onvermijdelijke contradictio in terminis?

Artificiële Intelligentie (AI) is vandaag de dag niet meer weg te denken uit onze huidige samenleving. Het is een onvermijdelijk gegeven dat AI een steeds prominentere rol in onze maatschappij inneemt en structureel verankerd zit in de werking ervan. Hoewel AI-systemen het potentieel bezitten om een brede waaier van maatschappelijke voordelen en economische groei te genereren, kan het gebruik van AI met haar specifieke kenmerken een aantal fundamentele in het EU-Handvest verankerde grondrechten negatief beïnvloeden, zoals het recht op bescherming van persoonsgegevens.

In het Unierecht wordt gegevensbescherming gereguleerd door de Algemene Verordening Gegevensbescherming (AVG), het huidig wetgevend kader dat de verwerking van persoonsgegevens regelt. En dit ongeacht de middelen die voor de verwerking worden gebruikt (een eenvoudig computerprogramma, een complex AI-systeem of gewoon een mens).

Transparantie versus black box

AI is een fenomeen dat de bestaande kaders in vraag doet stellen. In het bijzonder creëren het gebruik en de aard van AI, met name de ondoorzichtigheid, de complexiteit en het autonoom gedrag, juridische uitdagingen voor de toepassing van het transparantiebeginsel, een van de essentiële beginselen van de AVG. Dit beginsel stelt voorop dat persoonsgegevens ten aanzien van betrokkenen (i.e. de personen wiens persoonsgegevens worden verwerkt) op een transparante manier worden verwerkt en houdt onder meer de verplichting in voor verwerkingsverantwoordelijken om betrokkenen op gemakkelijk toegankelijke manier te informeren over hoe en welke persoonsgegevens worden verwerkt.

Hoewel de AVG reeds toepasselijk is op de verwerking van persoonsgegevens door AI-systemen, kunnen bepaalde reeds eerder vernoemde unieke eigenschappen van deze systemen voor problemen zorgen bij de toepassing van deze regelgeving. Door hun complexe en ondoorzichtige besluitvorming en zelflerend karakter, wordt het inzicht in de gegevensverwerking door deze AI-systemen beperkt. Zo bezitten deze AI-systemen het vermogen om enorme hoeveelheden data te verwerken op steeds complexere en (soms) minder transparante manieren, waardoor het transparantiebeginsel, zoals omschreven in de AVG, niet vanzelfsprekend toepasbaar is in de context van AI. Deze AI-systemen laten niet toe te achterhalen waarom het algoritme een welbepaalde beslissing heeft genomen. In dit geval is er sprake van een zwarte doos, ook wel een black box genaamd waarbij de interne operaties van het systeem niet transparant zijn waardoor het inzicht in de werking ervan wordt beperkt.

Om te vermijden dat het black box-karakter van AI-systemen een gebrek aan transparantie veroorzaakt, achtte de Raad van de Europese Unie het noodzakelijk de unieke eigenschappen van AI-systemen aan te pakken opdat deze geautomatiseerde systemen verenigbaar zouden zijn met het gegevensbeschermingsrecht. Om hieraan tegemoet te komen publiceerde de Europese Commissie op 21 april 2021 de AI-act.

Betekenisvolle transparantie

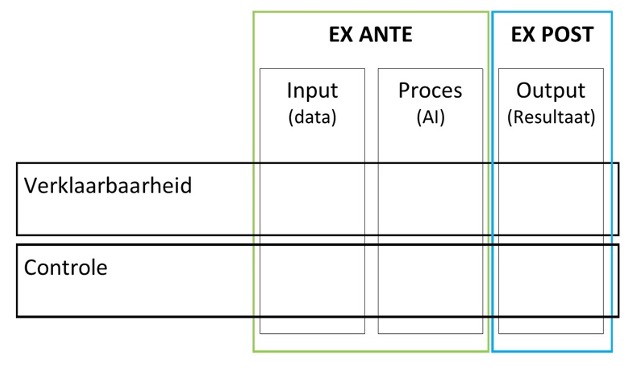

De AVG en de AI-act bevatten beiden transparantieverplichtingen. Zodoende te kunnen oordelen of de AI-act in staat is om samen met de AVG betekenisvolle transparantie te verzekeren ten aanzien van personen wiens (persoons)gegevens door AI-systemen worden verwerkt, werd een eigen ontwikkelde theoretische conceptualisering van betekenisvolle transparantie naar voor geschoven. Deze conceptualisering wordt vertaald in onderstaand transparantiekader waarin de verschillende transparantievereisten van beide rechtsinstrumenten kunnen worden ingepast.

Het concept betekenisvolle transparantie omvat op horizontaal niveau twee dimensies, met name een verklaarbaarheidsdimensie en een controledimensie. In eerste instantie dient transparantie vanuit een informerende dimensie (i.e. de dimensie verklaarbaarheid) te worden beoordeeld waarbij transparantie een belangrijk instrument is om eventuele informatieasymmetrie tussen de persoon die wordt onderworpen aan het AI-systeem en de verwerkingsverantwoordelijke te corrigeren. In deze dimensie worden bijgevolg transparantieverplichtingen (onder de vorm van informatieverplichtingen) ingepast die volgens de wetgever “inzicht” bieden in de verschillende fasen van de gegevensverwerking (input, proces en output) door het AI-systeem zodat de ontvanger van de informatie autonoom de verwerking van (persoons)gegevens door het AI-systeem kan doorzien en begrijpen. Deze dimensie omvat eveneens een belangrijk relationeel aspect dat de nadruk legt op het gegeven dat informatieverstrekking maar transparantie zal bewerkstelligen als de verstrekte informatie tegemoetkomt aan de informatiebehoeften van de ontvanger.

Betekenisvolle transparantie vereist niet alleen een verklaarbaarheidsdimensie, maar vereist eveneens een controledimensie. Controle wordt als inherent onderdeel van betekenisvolle transparantie beschouwd, aangezien transparantie maar zinvol kan zijn wanneer het onder meer doeltreffende controle over (persoons)gegevens mogelijk maakt. Gaat het over de controle-dimensie, dan gaat het over controlemechanismen die controle toelaten over de (persoons)gegevens in de inputfase, in de procesfase en in de outputfase.

Er worden twee vormen van controle geïdentificeerd, in functie van de doelstelling ervan. De eerste doelstelling is veiligheid en precisie. Deze vorm van controle benadrukt het belang van de menselijke autonomie. Controlemechanismen nemen in dit opzicht de vorm aan van menselijke tussenkomst/menselijk toezicht of een verbod op het gebruik op het gebruik van AI-systemen voor de verwerking van (persoons)gegevens. Deze vorm van controle is gelinkt aan transparantie, vermits menselijke tussenkomst/toezicht maar nuttig en doeltreffend kan zijn als de persoon door wie dit wordt uitgeoefend over voldoende informatie beschikt over de werking van het AI-systeem. Deze transparantie kan dus ook betekenisvol zijn omdat ze bijdragen aan de controle die de aan het AI-systeem onderworpen personen kunnen uitoefenen over hun (persoons)gegevens.

De tweede doelstelling van controle heeft te maken met de procedurele rechtvaardigheid en eerlijkheid. In dit opzicht is controle gelieerd aan informatie die de ontvanger van deze informatie moet toelaten de werking en de prestaties van de verwerkingsverantwoordelijke te begrijpen, en zo nodig te ageren door zijn subjectieve rechten tegenover de verwerkingsverantwoordelijke uit te oefenen.

Kortom, betekenisvolle transparantie impliceert dus enerzijds maximale reductie van de informatieasymmetrie in de verschillende fasen van de gegevensverwerking (verklaarbaarheidsdimensie) en anderzijds doeltreffende controle over (persoons)gegevens (controledimensie).

Relevantie

Dit kader vormt een analysekader aan de hand waarvan beleidsmakers visueel kunnen waarnemen in welke mate de transparantieverplichtingen in wetgevende instrumenten daadwerkelijk betekenisvolle transparantie verzekeren, alsook welke de grenzen zijn met betrekking tot de wijze waarop de transparantievereisten daarin omschreven worden. Op deze manier biedt het kader eveneens een belangrijke basis voor het in kaart brengen en remediëren van de juridische uitdagingen en pijnpunten in verband met AI en transparantie gedurende de volledige gegevensverwerkingscyclus.

Bibliografie

Wetgeving

Richtl. EP. Raad nr. 95/46/EG, 24 oktober 1995 betreffende de bescherming van natuurlijke personen in verband met de verwerking van persoonsgegevens en betreffende het vrij verkeer van die gegevens, Pb.L. 23 november 1995, afl. 281, 31.

Verord.Raad nr. (EU) 2016/679, 27 april 2016 betreffende de bescherming van natuurlijke personen in verband met de verwerking van persoonsgegevens en betreffende het vrij verkeer van die gegevens en tot intrekking van Richtlijn 95/46/EG (algemene verordening gegevensbescherming), Pb.L. 4 mei 2016, afl. 119, 7.

Voorstel (Comm.) voor een verordening van het Europees Parlement en de Raad tot vaststelling van geharmoniseerde regels betreffende artificiële intelligentie (wet op de artificiële intelligentie) en tot wijziging van bepaalde wetgevingshandelingen van de Unie, 21 april 2021, COM’2021) def – 2021/0106 (COD).

Preambule Verord.Raad nr. (EU) 2016/679, 27 april 2016 betreffende de bescherming van natuurlijke personen in verband met de verwerking van persoonsgegevens en betreffende het vrij verkeer van die gegevens en tot intrekking van Richtlijn 95/46/EG (algemene verordening gegevensbescherming), Pb.L. 4 mei 2016, afl. 119, 7.

Res. (EP) inzake artificiële intelligentie: kwesties betreffende de interpretatie en toepassing van het internationaal recht, voor zover dit van toepassing is op de EU, op het gebied van civiel en militair gebruik en staatsgezag buiten de werkingssfeer van het strafrecht, 20 januari 2021, 2020/2013(INI).

Concl.Raad nr. 11481/20, 21 oktober 2020 over het Handvest van de Grondrechten in de context van artificiële intelligentie en digitale verandering, https://data.consilium.europa.eu/doc/document/ST-11481-2020-INIT/nl/pdf.

Rechtsleer

AHMAD, N., HAMID, M., ZAINAL, A., RAUF, M. en ADNAN, Z., “Review of Chatbots Design Techniques”, International Journal of Computer Applications 2018, 7-10.

ALMADA, M., “Human Intervention in Automated Decision-Making: Toward the Construction of Contestable Systems”, Forthcoming, 17th International Conference on Artificial Intelligence and Law 2018, 1-10.

BALASUBRAMANIAM, N., KAUPPINEN, M., HIEKKANEN, K. en KUJALA, S., “Transparency and Explainability of AI Systems: Ethical Guidelines in Practice” in GERVASI, V. en VOGELSANG, A. (eds.), Requirements Engineering Foundation for Software Quality, Cham, Springer, 2022, 3-18.

BAROCAS, S. en NISSENBAUM, H., “Big Data’s End Run around Anonymity and Consent” in LANE, J., STODDEN, V., BENDER, S. en NISSENBAUM, H. (eds.), Privacy, Big Data, and the Public Good. Frameworks for Engagement, Cambridge, Cambridge University Press, 2014, 44-75.

BARROS VALE, S. en ZANFIR-FORTUNA, G., “Automated Decision-Making Under the GDPR: Practical Cases form Courts and Data Protection Authorities”, Future of Privacy Forum 2022, 1-60.

BAYAMLIOGLU, E., “The right to contest automated decisions under the General Data Protection Regulation: Beyond the so-called “right to explanation””, Regulation & Governance 2021, 1-21.

BENICHOU, B., KINDT, J. en BEUDELS, M., “Informatieverplichtingen in het gegevensbeschermingsrecht: much ado about nothing?” in S. VAN AGGELEN (ed.), Informatie en recht, Mortsel, Intersentia, 2021, 197-234.

BERTINO, E., “The Quest for Data Transparency”, IEEE Computer Society 2020, 67-68.

BIBAL, A., LOGNOUL, M., DE STREEL, A. en FRENAY, B., “Legal requirements on explainability in machine learning”, Artificial Intelligence & Law 2021, 149-169.

BRENNAN-MARQUEZ, K., LEVY, K. en SUSSER, D., “Strange Loops: apparent versus actual human involvement in automated decision making”, Berkely Technology Law Journal 2019, 745-771.

BURRELL, J., “How the machine ‘thinks’: Understanding opacity in machine learning algorithms”, Big Data & Society 2016, 1-12.

BUSUIOC, M., CURTIN, D. en ALMADA, M., “Reclaiming transparency: contesting the logics of secrecy within the AI Act”, European Law Open 2022, 1-27.

CASEY, B., FARHANGI, A. en VOGL, R., “Rethinking Explainable Machines: The GDPR’s Right to Explanation” Debate and the Rise of Algorithmic Audits in Enterprise”, Berkely Technology Law Journal 2019, 145-188.

CUSTERS, B. en HEIJNE, A., The right of access in automated decision-making: The scope of article 15(1)(h) GDPR in theory and practice”, Computer Law & Security Review 2022, 1-17.

DAVIDOVIC, J., “On the purpose of meaningful human control of AI”, SSRN 2022, 1-6.

DE BOT, D., (ed.), De toepassing van de Algemene Verordening Gegevensbescherming in de Belgische context. Commentaar op de AVG, de Gegevensbeschermingswet en de Wet Gegevensbeschermingsautoriteit, Mechelen, Wolters Kluwer, 2020, 1314.

DE BRUYNE, J., “Artificiële Intelligentie in 2021: veel wetgevende en beleidsinitiatieven, maar meer focus nodig op digitale geletterdheid, De Juristenkrant 2021, 8-9.

DE BRUYNE, J. en GILS, T., “Wat brengt de toekomst: de regulering van artificiële intelligentie” in VAN EECKE, P. (ed.), Recht & Elektronische handel, Mortsel, Intersentia, 2021, 581-606.

DE RAEDT, S., MARTENS, D. en BRUGHMANS, D., “Waarom krijg ik fiscale controle? Naar meer transparantie bij de geautomatiseerde besluitvorming door de fiscale overheid”, TFR 2021, nr. 604, 607-612.

DEVILLE, R., SERGEYSSELS, N. en MIDDAG, C., “Basic Concepts of AI for Legal Scholars” in DE BRUYNE, J. en VANLEENHOVE, C. (eds.), Artificial Intelligence and the Law, Mortsel, Intersentia, 2021, 1-22.

DOSHI-VELEZ, F., KORTZ, M., BUDISH, R., BAVITZ, C., GERSHMAN, S., O’BRIEN, D., SCOTT, K., SHIEBER, S., WALDO, J., WEINBERGER, D., WELLER, A. en WOOD, A., “Accountability of AI Under the Law: The Role of Explanation”, Berkman Center Research Publication 2017, 1-15.

DUROVIC, M. en WATSON, J., “Nothing to Be Happy about: Consumer Emotions and AI”, Multidisciplinary Scientific Journal 2021, 784-793.

EBERS, M., HOCH, V., ROSENKRANZ, F., RUSCHEMEIER, H. en STEINRÖTTER, B., “The European Commission’s Proposal for an Artificial Intelligence Act – A Critical Assessment by Members of the Robotics and AI Law Society (RAILS)”, Multidisciplinary Scientific Journal 2021, 589-603.

FELZMANN, H., VILLARONGA, E., LUTZ, C. en TAMO-LARRIEUX, A., “Transparency you can trust: transparency requirements for artificial intelligence between legal norms and contextual concerns”, Big Data & Society 2019, 1-14.

FELZMANN, H., VILLARONGA, E., LUTZ, C. en TAMO-LARRIEUX, A., “Towards Transparency by Design for Artificial Intelligence”, Science and Engineering Ethics 2020, 3333-3361.

FIERENS, M., VAN GOOL, E. en DE BRUYNE, J., “De regulering van artificiële intelligentie (deel 1) - Een algemene stand van zaken en een analyse van enkele vraagstukken inzake consumentenbescherming”, RW 2021, 962-980.

FINK, M., “The EU Artificial Intelligence Act and Access to Justice”, EU Law Live 2021, 1-4.

FLORIDI, L., “The European Legislation on AI: A Brief Analysis of Its Philosophical Approach” in MÖKANDER, J. en ZIOSI, M. (eds.), The 2021 Yearbook of the Digital Ethics Lab, Cham, Springer, 2022, 1-8.

GABRIELS, K., Regels voor robots. Ethiek in tijden van AI, Brussel, VUBPRESS, 2019, 172.

GIAKOUMOPOULOS, C., BUTTARELLI, G. en O’FLAHERTY, M., Handboek Europese gegevensbeschermingswetgeving, Luxemburg, Bureau voor publicaties van de Europese Unie, 2021, 466.

GREEN, B. en KAK, A.,“The False Comfort of Human Oversight as an Antidote to A.I. Harm”, Slate 2021, 1-6.

HACKER, P., “A legal framework for AI training data – from first principles to the Artificial Intelligence Act”, Law, Innovation and Technology 2021, 257-301.

HACKER, P. en PASSOTH, J., “Varieties of AI Explanations Under the Law. From the GDPR to the AIA, and Beyond” in HOLZINGER, A., GOEBEL, R., FONG, R., MOON, T., MÜLLER, K. en SAMEK, W. (eds.), xxAI – Beyond Explainable AI, Lecture Notes in Computer Science, 2022, 343-373.

JAK, N. en BASTIAANS, S., “De betekenis van de AVG voor geautomatiseerde besluitvorming door de overheid. Een black box voor een black box”, Nederlands Juristenblad 2018, 3018-3025.

KAMINSKI, E. en MALGIERI, G., “Multi-layered Explanations from Algorithmic Impact Assessments in the GDPR”, International Data Privacy Law 2020, 68-79.

KAMINSKI, E. en URBAN, J., “The right to contest AI”, Columbia Law Review 2021, 1957-2047.

KESA, A. en KERIKMÄE, T., “Artificial Intelligence and the GDPR: inevitable Nemeses?”, TalTech Journal of European Studies2020, 67-90.

KEMPER, J. en KOLKMAN, K., “Transparent to whom? No algorithmic accountability without a critical audience”, Information, communication & society 2019, 2081-2096.

KISELEVA, A., “Comments on the EU Proposal for the Artificial Intelligence Act”, VUB 2021, 1-8.

KISELEVA, A., KOTZINOS, D. en DE HERT, P., “Transparency of AI in Healthcare as a Multilayered System of Accountabilities: Between Legal Requirements and Technical Limitations”, Frontiers in Artificial Intelligence 2022, 1-21.

KOSTA, E. en CUIJPERS, C., “The Draft Data Protection Regulation and the Development of Data Processing Applications”, IFIP Advances in Information and Communication Technology 2014, 12-32.

KOIVISTO, I., Thinking Inside the Box: The Promise and Boundaries of Transparency in Automated Decision-Making, San Domenico di Fiesole, European University Institute, 2020, 1-22.

KOULU, R., “Proceduralizing control and discretion: Human oversight in artificial intelligence policy”, Maastricht Journal of European and Comparative Law 2020, 720-735.

LARSSON, S. en HEINTZ, F., “Transparency in artificial intelligence”, Internet Policy Review 2020, 1-16.

LAUX, J., “Institutionalised Distrust and Human Oversight of Artificial Intelligence: Toward a Democratic Design of AI Governance under the European Union AI Act”, Oxford Internet Institute 2023, 1-30.

LAWSON-HETCHELY, C., The Potential Impact of the Future AI Act on the GDPR, onuitg. masterproef rechten University of Oslo, 2022, 31.

LAZCOZ, G. en DE HERT, P., “Humans in the GDPR and AIA governance of automated and algorithmic systems. Essential pre-requisites against abdicating responsibilities”, Brussels Privacy Hub 2022, 1-31.

MALGIERI, G., “Automated decision-making in the EU Member States: The right to an explanation and other “suitable safeguards” in the national legislations”, Computer Law & Security Review 2019, 1-26.

MALGIERI, G. en COMANDÉ, G., “Why a Right to Legibility of Automated Decision-Making Exists in the General Data Protection Regulation”, International Data Privacy Law 2017, 1-36.

MENDOZA, I. en BYGRAVE, L., “The Right Not te be Subject to Automated Decisions Based on Profiling” in SYNODINOU, T., JOUGLEUX, P., MARKOU, C. en PRASTITOU, T. (eds.), EU Internet Law. Regulation and Enforcement, Cham, Springer, 2017, 77-98.

MENGES, F., LATZO, T., VIELBERTH, M., SOBOLA, S., PÖHLS, H., TAUBMANN, B., KÖSTLER, J., PUCHTA, A., FREILING, F., REISER, H. en PERNUL, G., “Towards GDPR-compliant data processing in modern SIEM systems”, Computers & Security 2021, 1-19.

MESARÍC, M., SOLÁROVÁ, S., PODROUZEK, J. en BIELIKOVA, M., “Stance on The Proposal for a Regulation Laying Down Harmonised Rules on Artificial Intelligence – Artificial Intelligence act”, Kempele Institute of Intelligent Technologies 2021, 1-16.

MITROU, L., Data Protection, Artificial Intelligence and Cognitive Services: Is the General Data Protection (GDPR) ‘Artificial Intelligence-Proof’?, Athene, University of Economics and Business, 2018, 90.

MLADENOV, M., “Human vs. Artificial Intelligence – EU’s legal response”, LAW – theory and practice 2023, 32-43.

NEUWIRTH, R., “Prohibited artificial intelligence practices in the proposed EU artificial intelligence act (AIA)”, Computer Law & Security Review 2023, 1-14.

PALMIOTTO, F., “The Black Box on Trial: The Impact of Algorithmic Opacity on Fair Trial Rights in Criminal Proceedings” in M. EBERS en M. CANTERO GAMITO (eds.), Algorithmic Governance and Governance of Algorithms, Zwitserland, Springer, 2021, 49-70.

RAMOSAJ, B. en BERISHA, G., “Systems Theory and Systems Approach to Leadership”, ILIRIA International Review 2014, 59-76.

RAPOSO, V., “Ex machina: preliminary critical assessment of the European Draft Act on artificial intelligence”, International Journal of Law and Information Technology 2022, 88-109.

ROIG, A., “Safeguards for the right not to be subject to a decision based solely on automated processing (Article 22 GDPR)”, European Journal of Law and Technology 2017, 1-17.

RUBIN, V., BURKELL, J., CORNWELL, S., ASUBIARO, T., CHEN, Y., POTTS, D. en BROGLY, C., “AI Opaqueness: What Makes AI Systems More Transparent?”, Proceedings of the Annual Conference of CAIS 2020, 1-6.

SCHERMER, B., CUSTERS, B. en VAN DER HOF, S., “The crisis of consent: how stronger legal protection may lead to weaker consent in data protection”, Ethics Inf Technol 2014, 171-182.

SCHLEHAHN, E. en WENNING, R., “GDPR Transparency Requirements and Data Privacy Vocabularies” in KOSTA, E., PIERSON, J., SLAMANIG, D., HÜBNER, S. en KRENN, S. (eds.), Privacy and Identity Management. Fairness, Accountability and Transparency in the Age of Big Data, Cham, Springer, 2018, 95-113.

SELBST, A. en POWLES, J., “Meaningful information and the right to explanation”, International data Privacy Law 2017, 233-242.

SMELTING, G., Geautomatiseerde besluitvorming: van human in-the-loop naar human out-the-loop, onuitg. masterproef Rechten UvA, 2020, https://scripties.uba.uva.nl/download?fid=c2025980, 41.

SMITS, J., “What is Legal Doctrine? On The Aims and Methods of Legal-Dogmatic Research” in VAN GESTEL, R., MICKLITZ, H. en RUBIN, E. (eds.), Rethinking Legal Scholarship: A Transatlantic Dialogue, New York, Cambridge University Press, 2017, 207-228.

SMUHA, N., “Beyond a Human rights-based approach to AI Governance: Promise, Pitfalls, Plea”, Philosophy & Technology 2020, 1-14.

SMUHA, N., “From a ‘Race to AI’ to a ‘Race to AI regulation’: Regulatory Competition for Artificial Intelligence”, Law, Innovation & Technology 2021, 1-26.

SMUHA, N., AHMED-RENGERS, E., HARKENS, A., LI, W., MACLAREN, J., PISELLI, R. en YEUNG, K., “How the EU Can Achieve Legally Trustworthy AI: A Response to the European Commission’s Proposal for an Artificial Intelligence Act”, LEADS Lab 2021, 1-59

SOVRANO, F., SAPIENZA, S., PALMIRANI, M. en VITALI, F., “Metrics, Explainability and the European AI Act Proposal”, Multidisciplinary Scientific Journal 2022, 126-138.

THIRUMURUGANATHAN, S., MAYURESH, K., OUZZANI, M. en CHAWLA, S., “Automated Annotations for AI Data and Model Transparency”, Qatar Computing Research Institute 2021, 1-9.

TIMAN, T. en GROMME, F., “Wat is rechtvaardige AI? Een kader voor het ontwikkelen en toepassen van algoritmes voor automatische besluitvorming”, Beleid en Maatschappij 2020, 425-438.

URBAN, T., TATANG, D., DEGELING, M., HOLZ, T. en POHLMANN, N., The Unwanted Sharing Economy: An Analysis of Cookie Syncing and User Transparency under the GDPR”, Cornell University 2018, 1-26.

VAN DE WAERDT, P., “Information asymmetries: recognizing the limits of the GDPR on the data-driven market”, Computer Law & Security Review 2020, 1-18.

VAN HOBOKEN, J., “The Privacy Disconnect” in R. JØRGENSEN (ed.), Human Rights in the Age of Platforms, Cambridge, The MIT Press, 2019, 255-284.

VAROSANEC, I., “On the path to the future: mapping the notion of transparency in the EU regulatory framework for AI”, International Review of Law, Computers & Technology 2022, 95- 117.

VEALE, M. en EDWARDS, L., “Clarity, surprises, and further questions in the Article 29 Working Party draft guidance on automated decision-making and profiling”, Computer Law & Security Review 2018, 398-404.

VEALE, M. en ZUIDERVEEN BORGESIUS, F., “Demystifying the Draft EU Artificial Intelligence Act – Analysing the good, the bad, and the unclear elements of the proposed approach”, Computer Law Review International 2021, 97-112.

WACHTER, S., MITTELSTADT, B. en FLORIDI, L., “Why a right to explanation of automated decision-making does not exist in the General Data Protection Regulation”, International Data Privacy Law 2017, 76-99.

WACHTER, S., MITTELSTADT, B. en RUSSEL, C., “Counterfactual explanations without opening the black box: automated decisions and the GDPR”, Harvard Journal of Law & Technology 2018, 842-887.

WALLACE, N. en CASTRO, D., “The Impact of the EU’s New Data Protection Regulation on AI”, Center for Data Innovation2018, 1-37.

WALMSLEY, J., “Artificial Intelligence and the value of transparency”, AI & society 2021, 585-595.

WOLTERS, P., “De rechten van de betrokkene onder de AVG”, Tijdschrift voor Consumentenrecht en handelspraktijken 2018, 130-140.

ZARSKY, T., “Transparent Predictions”, University of Illinois Law Review 2013, 1503-1569.

Onlinebronnen

A Civil Society Statement, An EU Artificial Intelligence Act for Fundamental Rights, 30 november 2021, https://www.accessnow.org/cms/assets/uploads/2021/11/joint-statement-EU-AIA.pdf.

AUTORITEIT PERSOONSGEGEVENS (AP), Toezicht op AI & Algortimes, https://autoriteitpersoonsgegevens.nl/sites/default/files/atoms/files/toezicht_op_ai_en_algoritmes.pdf.

AWS. What is data labeling for machine learning? AWS. Geraadpleegd op 3 oktober 2022, van https://aws.amazon.com/sagemaker/data-labeling/what-is-data-labeling/#:~:text=In%20machine%20learning%2C%20data%20labeling,model%20can%20learn%20from%20it

BARROS VALE, S., “GDPR and the AI Act interplay: lessons from FPF’s ADM case-law report”, Future of Privacy Forum 2022 (blog), https://fpf.org/blog/gdpr-and-the-ai-act-interplay-lessons-from-fpfs-adm-case-law-report/.

Europese Commissie, Regulatory framework proposal on artificial intelligence, https://digital-strategy.ec.europa.eu/en/policies/regulatory-framework-ai (consultatie 6 maart 2023).

GILS, T., WAUTERS, E., BENICHOU, B., DE BRUYNE J. en VALCKE, P., “Artificiële Intelligentie en gegevensbescherming: een verkennende gids”, Kenniscentrum Data en Maatschappij, 2020, https://data-en-maatschappij.ai/publicaties/ai-en-gegevensbescherming-een-verkennende-gids.

Kenniscentrum Data & Maatschappij. (z.d.). Artificial Intelligence. Geraadpleegd op 23 augustus 2022, van https://data-en-maatschappij.ai/woordenlijst#artificial-intelligence.

KISELEVA, A., “Making AI’s Transparency Transparent: notes on the EU Proposal”, European Law Blog 2021 (blog), https://europeanlawblog.eu/2021/07/29/making-ais-transparency-transparent-notes-on-the-eu-proposal-for-the-ai-act/.

Scholarpedia. (z.d.). Chinese room argument. Geraadpleegd op 28 september 2022, van http://www.scholarpedia.org/article/Chinese_room_argument.

Van Zwol, T. (2017, 22 oktober). Kunstmatige intelligentie: omarmen of wantrouwen? Scientias. Geraadpleegd op 29 september 2022, van https://scientias.nl/kunstmatige-intelligentie-omarmen-wantrouwen/.

Overige bronnen

BAQAIS, A., BAIG, Z. en GROBLER, M., “Transparency and Opacity in AI Systems: An Overview”, Interaction Design for explainable AI”, 12-15.

BODEN, M., Its Nature and Future, Oxford, Oxford University Press, 2016, 197.

BUYSE, T., “Frankenstein de baas blijven. Artificiële intelligentie in Vlaanderen”, Gids op Maatschappelijk Gebied, 2021, 46-54.

COECKELBERGH, M., AI Ethics, Cambridge, The MIT Press, 2020, 229.

COPELAND, B.J., The Essential Turing. Seminal Writings in Computing, Logic, Philosophy, Artificial Intelligence, and Artificial Life plus The Secrets of Enigma, New York, Oxford University Press, 2004, 613.

DE KETELAERE, G.M., Mens versus machine, Kalmthout, Pelckmans, 2020, 204.

DE PRETER, W., SERRURE, B. en LEGRAND, R., “De techtrends van 2023:iPhone-moment breekt aan voor AI”, De Tijd 27 december 2022, https://www.tijd.be/dossiers/de-vooruitblik/de-techtrends-van-2023-iphone-moment-breekt-aan-voor-ai/10437322.html.

DE SMEDT, S., “‘Vragen hoe slim ChatGPT is, is als vragen hoe sportief mijn stofzuiger is’”, De Tijd, 10 maart 2023, https://www.tijd.be/content/tijd/nl/mme-articles/10/45/32/33/10453233.

EUROPEAN DATA PROTECTION BOARD (EDPB), Richtsnoeren 05/2020 inzake toestemming overeenkomstig Verordening 2016/679, 4 mei 2020, versie 1.1, https://edpb.europa.eu/sites/default/files/files/file1/edpb_guidelines_202005_consent_nl.pdf.

EUROPEAN DATA PROTECTION BOARD – EUROPEAN DATA PROTECTION SUPERVISOR (EDPB-EDPS), Gezamenlijk advies over het voorstel voor een verordening van het Europees Parlement en de Raad tot vaststelling van geharmoniseerde regels betreffende artificiële intelligentie (wet inzake artificiële intelligentie), 18 juni 2021, nr. 5/2021, https://edpb.europa.eu/system/files/2021-10/edpb-edps_joint_opinion_ai_regulation_nl.pdf.

EUROPEAN UNION AGENCY FOR FUNDAMENTAL RIGHTS (FRA), Data quality and artificial intelligence – mitigating bias and error to protect fundamental rights, https://fra.europa.eu/sites/default/files/fra_uploads/fra-2019-data-quality-and-ai_en.pdf.

GEGEVENSBESCHERMINGSAUTORITEIT (GBA), Aanbeveling betreffende de verwerking van persoonsgegevens voor direct marketingdoeleinden, 17 januari 2020, nr. 01/2020, https://www.gegevensbeschermingsautoriteit.be/publications/aanbeveling-nr.-01-2020.pdf.

GROEP GEGEVENSBESCHERMING ARTIKEL 29, Richtsnoeren voor gegevensbeschermingseffectbeoordelingen en bepaling of een verwerking “waarschijnlijk een hoog risico inhoudt in de zin van Verordening 2016/679, 4 april 2017, WP248rev.01, https://ec.europa.eu/newsroom/article29/items/611236.

GROEP GEGEVENSBESCHERMING ARTIKEL 29, Richtsnoeren inzake geautomatiseerde individuele besluitvorming en profilering voor de toepassing van Verordening (EU) 2016/679, 3 oktober 2017, WP251rev.01, https://autoriteitpersoonsgegevens.nl/sites/default/files/atoms/files/wp251rev01_nl.pdf.

GROEP GEGEVENSBESCHERMING ARTIKEL 29, Richtsnoeren inzake transparantie overeenkomstig Verordening (EU) 2016/679, 11 april 2018, WP260rev.01, https://autoriteitpersoonsgegevens.nl/sites/default/files/atoms/files/wp260rev01_nl.pdf.

HAZENBERG, J., Technologie de baas, Amsterdam, Spectrum, 2019, 253.

ILKOU, E. en KOUTRAKI, M., “Symbolic Vs Sub-symbolic AI Methods: Friends or Enemies?”, CEUR WS 2020, 1-7.

JANSEN, P., BROADHEAD, S., RODRIGUES, R., WRIGHT, D. BREY, P., FOX A. en WANG, N., “State of the art review”, 2018. Draft of the D4.1 deliverable submitted to the European Commission on April 13, 2018. A report for The SIENNA Project, an EU H2020 research and innovation program under grant agreement no. 741716.

KIM, P., MATLAB Deep Learning, Seoul, Apress, 2017, xvii + 162.

LAUWAERT, L., Wij, Robots, Tielt, Lannoo Campus, 2021, 305.

LEGRAND, R., “Overheden moeten zich sneller voorbereiden op de bedreigingen van AI”, De Tijd, 7 maart 2023, https://www.tijd.be/ondernemen/technologie/cisco-topman-overheden-moeten-zich-sneller-voorbereiden-op-bedreigingen-van-ai/10451824.html.

MARNAU, N., “Stakeholders’ Consultation. Comments on the “Draft Ethics Guidelines for Trustworthy AI” by the High-Level Expert Group on Artificial Intelligence”, Helmholtz Center For Information Security 2019, 1-3.

Mededeling (Comm.) van de Commissie aan het Europees Parlement, de Europese Raad, de Raad, het Europees Economisch en Sociaal Comité en het Comité van de regio’s betreffende Kunstmatige Intelligentie voor Europa, 25 april 2018, COM(2018)237.

MUELLER, J. P. en MASSARON, L., Kunstmatige intelligentie voor dummies, Amersfoort, BBNC uitgevers, 2018, 347.

PANEL FOR THE FUTURE OF SCIENCE AND TECHNOLOGY (STOA), Tackling deepfakes in European policy, juli 2021, https://www.europarl.europa.eu/RegData/etudes/STUD/2021/690039/EPRS_STU(2021)690039_EN.pdf.

PANEL FOR THE FUTURE OF SCIENCE AND TECHNOLOGY (STOA), Regulatory divergences in the draft AI act – Differences in public and private sector obligations, mei 2022, https://www.europarl.europa.eu/RegData/etudes/STUD/2022/729507/EPRS_STU(2022)729507_EN.pdf.

SCIENTIFIC FORESIGHT UNIT (STOA), Artificial intelligence: How does it work, why does it matter, and what can we do about it?, juni 2020, https://www.europarl.europa.eu/RegData/etudes/STUD/2020/641547/EPRS_STU(2020)641547_EN.pdf.

SCIENTIFIC FORESIGHT UNIT (STOA), The impact of the General Protection Regulation (GDPR) on artificial intelligence, juni 2020, https://www.europarl.europa.eu/RegData/etudes/STUD/2020/641530/EPRS_STU(2020)641530_EN.pdf.

SEARLE, J., “Minds, Brains and Programs”, The Behavioral and Brain Sciences 1980, 417-424.

SERRURE, B., “Microsoft profiteert mee van AI-hype”, De Tijd, 26 april 2023, https://www.tijd.be/ondernemen/technologie/microsoft-profiteert-mee-van-ai-hype/10463654.html.

SNAPHAAN, T. en HARDYNS, W., “Artificiële Intelligentie en big data in het veiligheidsdomein”, Veiligheidsnieuws 2021, 1- 9.

STEELS, L. (ed.), Artificiële intelligentie. Naar een vierde industriële revolutie?, Brussel, KVAB Press, 2017, 43.

THE EUROPEAN COMMISSION’S HIGH-LEVEL EXPERT GROUP ON ARTIFICIAL INTELLIGENCE, A Definition of AI: Main capabilities and scientific disciplines, 18 december 2018, https://ec.europa.eu/futurium/en/system/files/ged/ai_hleg_definition_of_ai_18_december_1.pdf.

THE EUROPEAN COMMISSION’S HIGH-LEVEL EXPERT GROUP ON ARTIFICIAL INTELLIGENCE (HLEG AI), Ethische Richtsnoeren voor Betrouwbare KI, 8 april 2019, https://op.europa.eu/nl/publication-detail/-/publication/d3988569-0434-11ea-8c1f-01aa75ed71a1#.

The European Consumer Organisation (BEUC), Regulating AI to protect the consumer, Bureau Européen des Unions de Consommateurs AISBL, 2021, https://www.beuc.eu/sites/default/files/publications/beuc-x-2021-088_regulating_ai_to_protect_the_consumer.pdf.

TIELENBURG, D., The ‘Dark Sides’ of Transparency: Rethinking Information Disclosure as a Social Praxis, onuitg. masterproef Filosofie Universiteit Utrecht, 2018, 57.

URSIN, F., TIMMERMANN, C., ORZECHOWSKI, M. en STEGER, F., “Diagnostic Diabetic Retinopathy With Artificial Intelligence: What Information Should Be Included to Ensure Ethical Informed Consent?”, Frontiers in Medicine 2021, 1-6.

VALCKE, P. en ROSSELLO, S., “The artificial lawyer. Reflecties over de impact van AI op het recht en de rechtspraktijk” in DE BRUYNE, J. en BOUTECA, N. (eds.), Artificiële intelligentie en maatschappij, Oud-Turnhout, Gompel&Svacina, 2021, 175-206.

VAN BIESEN, W., VEYS, N., DECRUYENAERE, J., PELEMAN, R. en STERCKX, S., “Hoe artificiële intelligentie, digitalisering en big data ons kunnen helpen bij verantwoordbare zorg”, tvgg 2021, 1-16.

WANG , W. en SIAU, K., “Artificial Intelligence, Machine Learning, Automation, Robotics, Future of of Work and Future of Humanity: A Review and Research Agenda”, Journal of Database Management 2019, 61- 79.