Gedaan met zuigen aan het wiel van je voorganger!

De laatste jaren hebben verschillende sporten voordeel gehaald uit de introductie van slimme technologie, zoals de videoscheidsrechter of de Video Assisted Referee (VAR) bij het voetbal. In de triatlon is er tot op vandaag geen uitgewerkt systeem op de markt dat drafting detecteert bij de fietsdiscipline. Als een wielrenner draft, dan fietst hij dicht achter iemand aan en heeft op die manier oneerlijk voordeel, want hij geniet van verminderde luchtweerstand. Hoe kunnen we dat voordeel vastleggen? De scriptie beschrijft een concept om drafting te detecteren aan de hand van een slimme camera.

Wat is draften?

Wielrenners, duatleten of triatleten proberen tijdens wedstrijden zo snel mogelijk de finish te bereiken. Ze trainen zo veel mogelijk, rusten voldoende en eten zo gezond mogelijk, maar er is meer. Deze renners kunnen beter en sneller fietsen als hun houding gestroomlijnd is. Daarnaast zullen ze ook minder energie verbruiken als ze tijdens een wedstrijd kort achter de voorligger fietsen. Op die manier vormt de fietser voor hen een soort windscherm. Deze techniek wordt drafting, slipstreaming of stayeren genoemd. Figuur 1 toont enkele atleten in een lange-afstandstriatlon die, zoals het hoort, niet aan het draften zijn.

Figuur 1: Niet-draftende atleten in een lange-afstandstriatlon (© Getty Images)

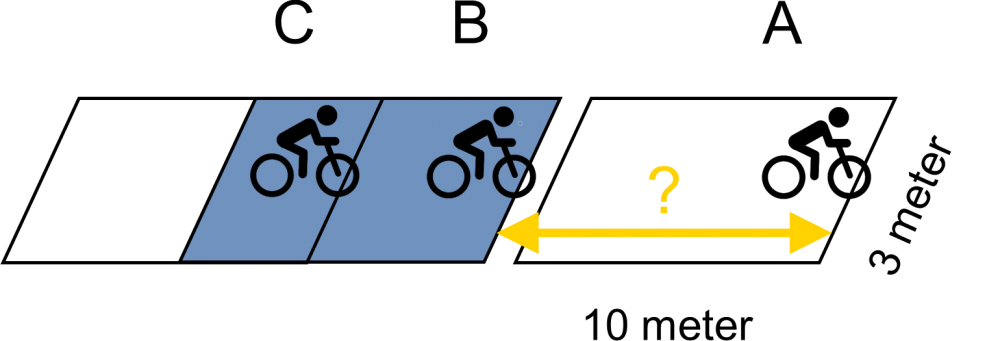

Triatleten en duatleten mogen dus, in tegenstelling tot wielrenners, niet in peloton rijden, omdat triatlon en duatlon individuele sporten zijn. Volgens de officiële triatlonregels mogen atleten, in het geval van non-draftingwedstrijden, niet langer dan 20 seconden in de draftingzone van 10 meter op 3 meter blijven (zie Figuur 2).

Figuur 2: Officiële draftingzone waarbij renner C aan het draften is bij renner B

Deze afstand wordt gemeten van voorwiel tot voorwiel, aangeduid in het geel in Figuur 2. In deze figuur is renner B niet aan het draften, omdat deze zich niet in de draftingzone van renner A bevindt. Renner C is echter wel aan het draften bij renner B. Renner C mag zich dus maximaal 20 seconden in de draftingzone van B bevinden, gekleurd in het blauw in Figuur 2, om renner B eventueel in te halen. Als renner C renner B heeft voorbijgestoken, dan moet renner B zich binnen de 5 seconden laten uitzakken tot buiten de draftingzone van C. Op die manier voorkomt renner B een straftijd.

Waarom automatische draftingdetectie?

Heden wordt de toegelaten afstand op triatlonwedstrijden gecontroleerd door scheidsrechters op motors. Toch wordt vaak in de praktijk tegen deze regels gezondigd, omdat deze moeilijk te bewaken zijn.

89,40 % van de triatleten vindt dat drafting strenger gecontroleerd moet worden

Vooreerst zijn er te weinig scheidsrechters beschikbaar om alle atleten altijd en overal te controleren. Bovendien zijn hun beslissingen subjectief, aangezien ze de afstanden tussen de atleten alleen ruwweg kunnen schatten. Een eigen gevoerde enquête leert ons trouwens dat 89,40 % van de triatleten vindt dat drafting strenger gecontroleerd moet worden. Naast subjectiviteit en mogelijks gevaarlijke situaties op het parcours zijn de motors waarop de scheidsrechters rijden ook hoorbaar waardoor ze zichzelf verraden. Op die manier kan men minder renners op heterdaad betrappen op drafting om hen zo een gepaste straftijd toe te kennen. Ten slotte is het voor de atleten zelf niet altijd gemakkelijk om de afstand tussen de voorganger goed in te schatten. In diezelfde enquête geeft 45,10 % van de sporters aan dat hij of zij vermoedt wel eens onbewust gedraft te hebben.

Hoewel het dus in praktijk vaak moeilijk is voor de scheidsrechters om de draftingregels te controleren, is het van groot belang dat zij dit op een eerlijke en transparante manier doen. Hoe kan dat? Wij vonden een oplossing.

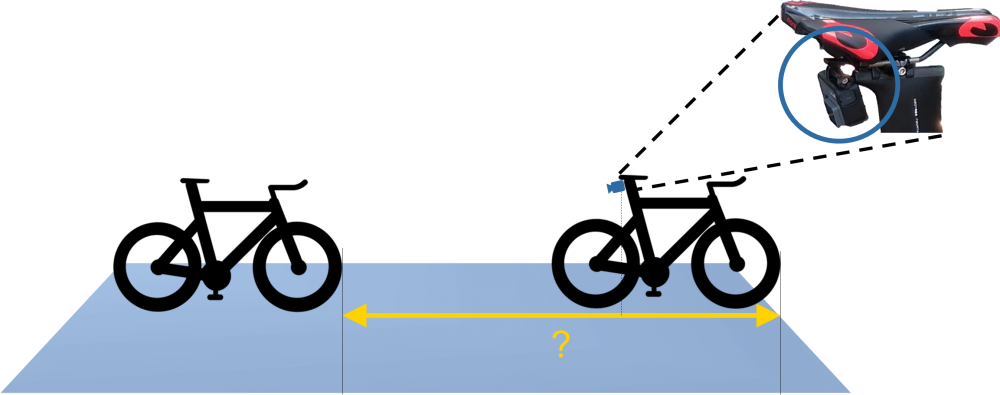

Automatische draftingdetectie geeft een melding op het moment dat een wielrenner aan het draften is. In een vroeger onderzoek werd een draftingdetectiesysteem voorgesteld op basis van gps. Gps is echter maar tot 5 meter nauwkeurig, wat niet voldoende is voor een professionele wedstrijd. Om drafting gemakkelijker en nauwkeuriger op te sporen hebben we daarom de "draftcam" ontwikkeld. De draftcam werkt niet met gps maar analyseert camerabeelden: een camera gemonteerd onder het zadel van een atleet neemt videobeelden op, zoals weergegeven in Figuur 3.

Figuur 3: Principe van draftingdetectie op basis van een camera aan het zadel gemonteerd die een afstand meet

Werking van de draftcam

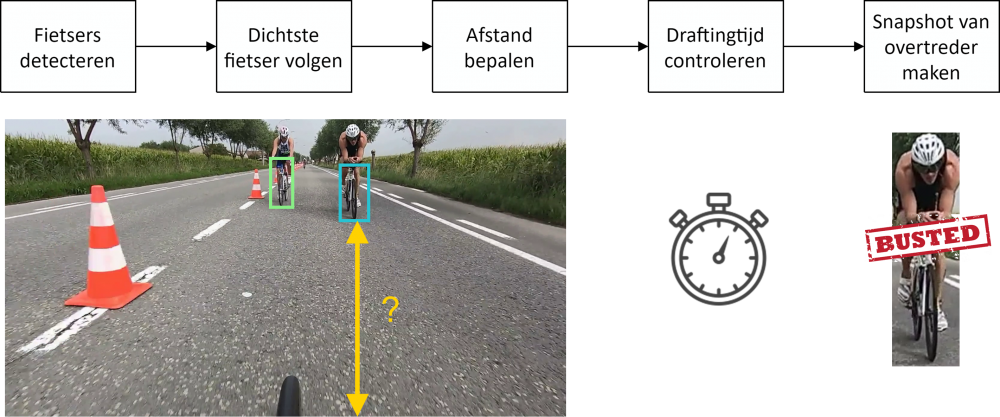

Een slimme camera detecteert drafting in verschillende stappen. Figuur 4 toont hoe de draftcam werkt:

Figuur 4: Schema van de werking van de draftcam

De draftcam detecteert eerst elke fietser in het beeld, zoals aangegeven met de twee gekleurde vensters in Figuur 4. Daarna wordt de fietser die zich het dichtst bevindt bij de camera minutieus gevolgd. Dit is echter niet zo evident, omdat er tijdens een wedstrijd onverwachte moeilijkheden optreden. Fietsers of medefietsers zijn namelijk vaak niet eenvoudig te onderscheiden van de achtergrond of van toeschouwers. Soms beweegt de fiets veel of is het wegdek niet vlak genoeg, zodat er trillingen of schommelingen in het beeld optreden.

Daarna bepalen we uit de grootte en positie van het venster de afstand tussen de camera en de dichtste renner. Uitgebreide en herhaaldelijke testen tonen aan dat de draftcam tot op 0,47 meter nauwkeurig detecteert in een gesimuleerde wedstrijd. De resultaten met de slimme camera zijn bijgevolg veel accurater dan bij een gps-gebaseerd systeem, waar een foutmarge van 5 meter vaak de norm is.

Na de afstand tot de achterliggende renner wordt nu ook de tijd tussen beide renners intelligent gecontroleerd conform de wedstrijdregels. In de ene situatie is 20 seconden toegestaan, in de andere 5 seconden. Als de sporter de aanvaardbare tijdsspanne overschrijdt, wordt een signaal zichtbaar. Er zal bijvoorbeeld een ledlamp knipperen of er wordt een foto van de overtreder genomen.

Vanaf nu hebben de wieltjeszuigers geen kans meer. De nieuwe slimme camera in de vorm van de draftcam legt op een accurate en onbetwistbare manier vast wanneer renners te dicht bij hun voorganger rijden om zo te profiteren van een mindere luchtweerstand. Alle triatlon- en duatlonwedstrijden kunnen nu op een eerlijke manier verlopen. Na de VAR bij de voetbal, nu ook de draftcam bij triatlon en duatlon!

Bibliografie

A van de Sande, K. E., R Uijlings, J. R., Gevers, T., & M Smeulders, A. W. (n.d.). Segmentation as Selective Search for Object Recognition. Tech. rep. Retrieved from https://www.koen.me/research/pub/vandesande-iccv2011.pdf

Babenko, B., Belongie, S., & Yang, M. H. (2009, 6). Visual tracking with online multiple instance learning. 2009 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops, CVPR Workshops 2009. 2009 IEEE , pp. 983-990. IEEE. doi:10.1109/CVPRW.2009.5206737

Bae, S.-H., & Yoon, K.-J. (2014, 7). Robust Online Multiobject Tracking With Data Association and Track Management. IEEE Transactions on Image Processing, 23, 2820-2833. doi:10.1109/tip.2014.2320821

Becycled, R. (2018). Team Wanty – Groupe Gobert naar de Tour met nieuwe Cube Aerium TT C:68 | Becycled Magazine. Retrieved from https://www.becycled.be/magazine/team-wanty-groupe-gobert-naar-de-tour-…

Blocken, B., Defraeye, T., Koninckx, E., Carmeliet, J., & Hespel, P. (2013). CFD simulations of the aerodynamic drag of two drafting cyclists. Computers and Fluids, 71, 435-445. doi:10.1016/j.compfluid.2012.11.012

Blocken, B., Druenen, T. V., Toparlar, Y., Malizia, F., Mannion, P., Andrianne, T., . . . Diepens, J. (2018). Journal of Wind Engineering & Industrial Aerodynamics Aerodynamic drag in cycling pelotons : New insights by CFD simulation and wind tunnel testing. Journal of Wind Engineering & Industrial Aerodynamics, 179, 319-337. doi:10.1016/j.jweia.2018.06.011

Briot, A., Viswanath, P., & Yogamani, S. (2018). Analysis of efficient CNN design techniques for semantic segmentation. IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops, 2018-June, pp. 776-785. doi:10.1109/CVPRW.2018.00109

Burić, M., Pobar, M., & Ivašić-Kos, M. (n.d.). Object Detection in Sports Videos. Tech. rep. Retrieved from https://bib.irb.hr/datoteka/941522.5075-Object-Detection-in-Sports-Vide…

Cai, C., Wang, B., & Liang, X. (2018). A new family monitoring alarm system based on improved YOLO network. 2018 Chinese Control And Decision Conference (CCDC), 4269-4274. doi:10.1109/CCDC.2018.8407866

CamDo, R. (n.d.). GoPro Battery Consumption Comparison. Retrieved from https://cam-do.com/pages/power-consumption-by-gopro-camera-model

Canny, J. (1986). A Computational Approach to Edge Detection. IEEE Transactions on Pattern Analysis and Machine Intelligence, PAMI-8, 679-698.

Caprile, B., & Torre, V. (1990, 3). Using vanishing points for camera calibration. International Journal of Computer Vision, 4, 127-139. doi:10.1007/BF00127813

Cycles, R. (n.d.). 2018 Argon 18 E-117 Tri Ultegra Bike. Retrieved from https://www.racycles.com/product/detail/14750

Daixian, Z. (2010). SIFT algorithm analysis and optimization. IASP 10 - 2010 International Conference on Image Analysis and Signal Processing, 415-419. doi:10.1109/IASP.2010.5476084

Dalal, N., & Triggs, B. (2005). Histograms of oriented gradients for human detection. Proceedings - 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, CVPR 2005, I, pp. 886-893. doi:10.1109/CVPR.2005.177

Danelljan, M., Hager, G., Khan, F. S., & Felsberg, M. (2017). Discriminative Scale Space Tracking. IEEE Transactions on Pattern Analysis and Machine Intelligence, 39, 1561-1575. doi:10.1109/TPAMI.2016.2609928

Ding, D., Jiang, Z., & Liu, C. (2016). Object tracking algorithm based on particle filter with color and texture feature. Chinese Control Conference, CCC. 2016-Augus, pp. 4031-4036. TCCT. doi:10.1109/ChiCC.2016.7553983

Dollár, P., Wojek, C., Schiele, B., & Perona, P. (2012). Pedestrian Detection: The State of the Art. Ieee Transactions on Pattern Analysis and Machine Intelligence, 34, 743-761. doi:10.1080/01062301.1991.10592255

Donahue, J., Jia, Y., Vinyals, O., Hoffman, J., Zhang, N., Tzeng, E., & Darrell, T. (2013). DeCAF: A Deep Convolutional Activation Feature for Generic Visual Recognition. doi:10.1007/978-3-319-51844-2_3

Eklundh, J.-O., & Richard, I. (1994). Computer Vision - ECCV '94. Proceedings of the third European conference on Computer vision (vol. 1). 800, pp. 471-478. Springer-Verlag. doi:10.1007/3-540-57956-7

Eprs. (2018). STUDY Panel for the Future of Science and Technology Galileo Satellite Navigation System Space applications on earth. Tech. rep. Retrieved from http://www.europarl.europa.eu/RegData/etudes/STUD/2018/614560/EPRSSTU(2…

Esmaeili, H., & Thwaites, H. (2016, 10). Virtual photogrammetry. Proceedings of the 2016 International Conference on Virtual Systems and Multimedia, VSMM 2016 (pp. 1-6). IEEE. doi:10.1109/VSMM.2016.7863153

Eurosport. (2019). Gent-Wevelgem 2019 Highlights | Cycling | Eurosport. Retrieved from https://www.youtube.com/watch?v=chLNhU2-XrY&t=131s

Everingham, M. (2008). The PASCAL Visual Object Classes Challenge 2008 ( VOC2008 ) Development Kit. 2008, 1-24. Retrieved from http://host.robots.ox.ac.uk/pascal/VOC/voc2012/devkitdoc.pdf

Fawcett, T. (2006). An introduction to ROC analysis. Pattern Recognition Letters, 27, 861-874. doi:10.1016/j.patrec.2005.10.010

Federatie, B. T. (2018). BTDF Sportreglementen 2018.

Fister, I., & Fister, I. J. (2011). Concept of drafting detection system in Ironmans. Electrotechnical Review, 78, 217-222.

Fister, I., Fister, D., Fong, S., & Fister, I. (2013). Widespread mobile devices in applications for real-time drafting detection in triathlons. Journal of Emerging Technologies in Web Intelligence, 5, 310-321. doi:10.4304/jetwi.5.3.310-321

For, G. E. (n.d.). HERO5 Black Field of View ( FOV ) Information. Retrieved from https://gopro.com/help/articles/questionanswer/hero6-black-field-of-vie…

Garmin, R. (n.d.). Varia™ Achteruitkijk Fietsradar. Retrieved from https://buy.garmin.com/nl-BE/BE/p/518151/pn/010-01509-10#

Geiger, A., Lenz, P., Stiller, C., & Urtasun, R. (2013). The KITTI Vision Benchmark Suite. Retrieved from http://www.cvlibs.net/datasets/kitti/ http://www.cvlibs.net/datasets/kitti/evalobject.php%0Ahttp://www.cvlibs…

Girshick, R. (2015). Fast r-cnn. CVPR, (pp. 1440-1448). doi:10.1109/iccv.2015.169

Girshick, R., Donahue, J., Darrell, T., Malik, J., & Berkeley, U. C. (2012). Rich feature hierarchies for accurate object detection and semantic segmentation.

Gonzalez, R. C., & Woods, R. (2017). Digital Image Processing. Prentice Hall. doi:10.1111/j.1365-2842.2011.02229.x

Gouk, H. G., & Blake, A. M. (2014). Fast Sliding Window Classification with Convolutional Neural Networks. Proceedings of the 29th International Conference on Image and Vision Computing New Zealand - IVCNZ '14, (pp. 114-118). doi:10.1145/2683405.2683429

Grabner, H., Grabner, M., & Bischof, H. (n.d.). Real-Time Tracking via On-line Boosting. Tech. rep. Retrieved from https://pdfs.semanticscholar.org/3a68/0eb285f31d6a72848530dec640d83c02a…

Grigsby, S. S. (2018). Augmented Cognition: Intelligent Technologies. 10915. doi:10.1007/978-3-319-91470-1

Hamme, D. V., Goeman, W., Veelaert, P., & Philips, W. (2015). Robust monocular visual odometry for road vehicles using uncertain perspective projection (Vol. 2015). doi:10.1186/s13640-015-0065-6

He, K., Gkioxari, G., Dollar, P., & Girshick, R. (2017). Mask R-CNN. Proceedings of the IEEE International Conference on Computer Vision, 2017-Octob, 2980-2988. doi:10.1109/ICCV.2017.322

Held, D., Thrun, S., & Savarese, S. (n.d.). Learning to Track at 100 FPS with Deep Regression Networks. Tech. rep. Retrieved from http://davheld.github.io/GOTURN/GOTURN.html

Henriques, J. F., Rui, C., Pedro, M., & Horge, B. (2015). High-Speed Tracking with Kernelized Correlation Filters. IEEE Transactions on Pattern Analysis and Machine Intelligence, 37, 583-596. doi:10.1016/j.bmcl.2013.12.116

Hof, R. D. (2013). Deep Learning - MIT Technology Review. Retrieved from https://www.technologyreview.com/s/513696/deep-learning/

Howard, A. G., Zhu, M., Chen, B., Kalenichenko, D., Wang, W., Weyand, T., . . . Adam, H. (2017). MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications. Retrieved from https://arxiv.org/pdf/1704.04861.pdf http://arxiv.org/abs/1704.04861

Hu, W. C., Chen, C. H., Chen, T. Y., Huang, D. Y., & Wu, Z. C. (2015). Moving object detection and tracking from video captured by moving camera. Journal of Visual Communication and Image Representation, 30, 164-180. doi:10.1016/j.jvcir.2015.03.003

Huang, S., & Hong, J. (2011, 4). Moving object tracking system based on camshift and Kalman filter. 2011 International Conference on Consumer Electronics, Communications and Networks (CECNet) (pp. 1423-1426). IEEE. doi:10.1109/CECNET.2011.5769081

Impiombato, D., Giarrusso, S., Mineo, T., Catalano, O., Gargano, C., La Rosa, G., . . . Romeo, G. (2015). SSD: Single Shot MultiBox Detector Wei. Nuclear Instruments and Methods in Physics Research, Section A: Accelerators, Spectrometers, Detectors and Associated Equipment, 794, 185-192. doi:10.1016/j.nima.2015.05.028

Jacobs, D. (2005). Image Gradients. Class Notes for CMSC 426, 1-3. Retrieved from http://www.cs.umd.edu/ djacobs/CMSC426/ImageGradients.pdf

Jeong, H. J., Park, K. S., & Ha, Y. G. (2018). Image Preprocessing for Efficient Training of YOLO Deep Learning Networks. Proceedings - 2018 IEEE International Conference on Big Data and Smart Computing, BigComp 2018, 635-637. doi:10.1109/BigComp.2018.00113

Kalal, Z., Mikolajczyk, K., & Matas, J. (2010, 8). Forward-backward error: Automatic detection of tracking failures. Proceedings - International Conference on Pattern Recognition (pp. 2756-2759). IEEE. doi:10.1109/ICPR.2010.675

Kalal, Z., Mikolajczyk, K., & Matas, J. (2012, 7). Tracking-learning-detection. IEEE Transactions on Pattern Analysis and Machine Intelligence, 34, 1409-1422. doi:10.1109/TPAMI.2011.239

Kalal, Z., Mikolajczyk, K., & Matas, J. (n.d.). Forward-backward error: Automatic detection of tracking failures. Retrieved from http://kahlan.eps.surrey.ac.uk/featurespace/tld/Publications/2010icpr.p…

Keivani, A., Tapamo, J.-R., & Ghayoor, F. (2017, 9). Motion-based moving object detection and tracking using automatic K-means. Africon, 2017 Ieee, 32-37. doi:10.1109/AFRCON.2017.8095451

Khan, S. M., & Shah, M. (2009, 3). Tracking multiple occluding people by localizing on multiple scene planes. IEEE Transactions on Pattern Analysis and Machine Intelligence, 31, 505-519. doi:10.1109/TPAMI.2008.102

Kim, I. S., Choi, H. S., Yi, K. M., Choi, J. Y., & Kong, S. G. (2010). Intelligent visual surveillance - A survey. International Journal of Control, Automation and Systems, 8, 926-939. doi:10.1007/s12555-010-0501-4

King, D. E. (2009). Dlibml: A Machine Learning Toolkit. Tech. rep. Retrieved from http://www.jmlr.org/papers/volume10/king09a/king09a.pdf

Krizhevsky, A., & Hinton, G. E. (2012). ImageNet Classification with Deep Convolutional Neural Networks. Proceeding NIPS'12 Proceedings of the 25th International Conference on Neural Information Processing Systems, (pp. 1-9). Retrieved from http://code.google.com/p/cuda-convnet/

Kumar, A. (2017). Object Localization & Object Detection. Retrieved from http://www.ashukumar27.io/Object-Localization/

LeCun, Y. (2015). LeNet-5, convolutional neural networks. Tech. rep. Retrieved from http://yann.lecun.com/exdb/lenet/

Liebowitz, D., & Zisserman, A. (1998). Metric rectification for perspective images of planes. Proceedings. 1998 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 482-488. doi:10.1109/CVPR.1998.698649

Lowe, D. G. (1999). Object recognition from local scale-invariant features. Proceedings of the Seventh IEEE International Conference on Computer Vision (pp. 1150--1157 vol.2). IEEE. doi:10.1109/ICCV.1999.790410

Lu, Y., Zhou, Z., & Zhao, J. (2018). Visual Object Tracking Using PCA Correlation Filters. doi:10.2991/caai-18.2018.10

Lucena, M. J., Fuertes, J. M., Gomez, J. I., Perez de la Blanca, N., & Garrido, A. (2004). Tracking from optical flow. 3rd International Symposium on Image and Signal Processing and Analysis, 2003. ISPA 2003. Proceedings of the. 2, pp. 651-655. IEEE. doi:10.1109/ispa.2003.1296357

Lukežič, A., Vojíř, T., Čehovin Zajc, L., Matas, J., & Kristan, M. (2018). Discriminative Correlation Filter Tracker with Channel and Spatial Reliability. International Journal of Computer Vision, 126, 671-688. doi:10.1007/s11263-017-1061-3

Mallick, S. (2016). Histogram of Oriented Gradients. Retrieved from https://www.learnopencv.com/histogram-of-oriented-gradients/

Mavis, B. (2015). Implementing Challenge's 20-Meter Drafting Rule – Triathlete. Retrieved from https://www.triathlete.com/2015/03/race-coverage/implementing-challenge…

Mehta, R., & Ozturk, C. (2018). Object detection at 200 Frames Per Second. doi:arXiv:1805.06361v1

Nagaraj, S., Muthiyan, B., Ravi, S., Menezes, V., Kapoor, K., & Jeon, H. (2017). Edge-Based Street Object Detection. 2017 IEEE SmartWorld, Ubiquitous Intelligence & Computing, Advanced & Trusted Computed, Scalable Computing & Communications, Cloud & Big Data Computing, Internet of People and Smart City Innovation (SmartWorld/SCALCOM/UIC/ATC/CBDCom/IOP/SCI), 1-4.

Networks, R. P. (2015). Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks. 39, 1137-1149. doi:1506.01497

Nvidia. (n.d.). Jetson Nano Brings AI Computing to Everyone | NVIDIA Developer Blog. Retrieved from https://devblogs.nvidia.com/jetson-nano-ai-computing/

Olah, C. (2014). Conv Nets: A Modular Perspective. Colah's Blog, 13. Retrieved from https://colah.github.io/posts/2014-07-Conv-Nets-Modular/

Papageorgiou, C. P., Oren, M., & Poggio, T. (2014). A general framework for object detection. Sixth International Conference on Computer Vision (IEEE Cat. No.98CH36271), 555-562. doi:10.1109/ICCV.1998.710772

Paper, 2. (2011). 3D with Kinect. Image (Rochester, N.Y.), 1154-1160. doi:10.1109/ICCVW.2011.6130380

Patel, H. A., & Thakore, D. G. (2013). International Journal of Computer Science and Mobile Computing Moving Object Tracking Using Kalman Filter. Tech. rep. Retrieved from www.ijcsmc.com

Peter, C., A, IEEE, Machine, N. O., & Intelligence, V. O. (2002). Dorin Mean Shift: Approach Toward Feature Space Analysis. on Pattern Analysis and 5MAY, 24, 603-619.

POWERS, D. M. (2011). Evaluation: From Precision, Recall and F-Measure To Roc, Informedness, Markedness & Correlation. Journal of Machine Learning Technologies, 2, 37-63. doi:10.1.1.214.9232

Ramjee, P., & Marina, R. (2005). Applied Satellite Navigation Using GPS, GALILEO, and Augmentation Systems [Hardcover]. Artech House. Retrieved from https://lib.ugent.be/catalog/rug01:001050355 http://www.amazon.com/dp/1580538142

Redactie. (2017). Fietsmaat - Ergonomie site. Retrieved from http://www.ergonomiesite.be/fietsmaat/

Redactie, X. L. (n.d.). Delta 200. Retrieved from https://www.xlab-usa.com/delta-200.html

Redmon, J., & Farhadi, A. (2017). YOLO9000: Better, faster, stronger. Proceedings - 30th IEEE Conference on Computer Vision and Pattern Recognition, CVPR 2017, 2017-Janua, 6517-6525. doi:10.1109/CVPR.2017.690

Redmon, J., & Farhadi, A. (2018). YOLOv3: An Incremental Improvement. doi:10.1109/CVPR.2017.690

Redmon, J., Divvala, S., Girshick, R., & Farhadi, A. (2015). You Only Look Once: Unified, Real-Time Object Detection. doi:10.1109/CVPR.2016.91

Redmon, J., Divvala, S., Girshick, R., & Farhadi, A. (n.d.). You Only Look Once : Unified , Real-Time Object Detection.

Ren, P., Fang, W., & Djahel, S. (2017). A novel YOLO-Based real-Time people counting approach. 2017 International Smart Cities Conference, ISC2 2017, 243, 3-4. doi:10.1109/ISC2.2017.8090864

Ren, S., He, K., Girshick, R., Sun, J., Donahue, J., Darrell, T., . . . Anguelov, D. (2015). Rich feature hierarchies for accurate object detection and semantic segmentation. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 794, 1-15. doi:10.1016/j.nima.2015.05.028

Richard Hartley, A. Z. (2003). Multiple View Geometry (Vol. 53). doi:10.1017/CBO9781107415324.004

Robotix. (2018). Kalman Filter. Retrieved from https://2018.robotix.in/tutorial/advanced/kalmanfilter/

Roth, S. (n.d.). People-Tracking-by-Detection and People-Detection-by-Tracking. Retrieved from https://www.mpi-inf.mpg.de/fileadmin/inf/d2/andriluka/andrilukacvpr08.p…

Schapire, R. E. (n.d.). Explaining AdaBoost. Retrieved from http://rob.schapire.net/papers/explaining-adaboost.pdf

Shah, N., Pingale, A., Patel, V., & George, N. V. (2018). An adaptive background subtraction scheme for video surveillance systems. 2017 IEEE International Symposium on Signal Processing and Information Technology, ISSPIT 2017, 13-17. doi:10.1109/ISSPIT.2017.8388311

Simek, K. (2013). The Intrinsic Matrix. Retrieved from http://ksimek.github.io/2013/08/13/intrinsic/

Software, I. (n.d.). Deploy real-time object detectors on Intel® Movidius™ Neural Compute Stick. Retrieved from https://www.slideshare.net/IntelSoftware/deploy-realtime-object-detecto…

Solc, T., Gale, T., & Fortuna, C. (2017, 5). Optimization of ultra-narrowband wireless communication: An experimental case study. 2017 IEEE Conference on Computer Communications Workshops, INFOCOM WKSHPS 2017 (pp. 523-528). IEEE. doi:10.1109/INFCOMW.2017.8116432

Song, Y. M., Noh, S., Yu, J., Park, C. W., & Lee, B. G. (2014). Background subtraction based on Gaussian mixture models using color and depth information. 2014 International Conference on Control, Automation and Information Sciences, ICCAIS 2014, 132-135. doi:10.1109/ICCAIS.2014.7020544

Stein, G. P. (1995). Accurate Internal Camera Calibration using Rotation, with Analysis of Sources of Error. in Fifth International Conference on Computer Vision (Iccv'95, 230-236. doi:10.1109/ICCV.1995.466781

Su, J., Vargas, D. V., & Kouichi, S. (2017). One pixel attack for fooling deep neural networks. Retrieved from https://github.com/Carina02/One-Pixel-Attack http://arxiv.org/abs/1710.08864

Surgailis, T., Valinevicius, A., & Zilys, M. (2009). Traffic image processing systems. 2nd International Conference on Advances in Circuits, Electronics and Micro-electronics - CENICS 2009, 61-66. doi:10.1109/CENICS.2009.9

Swalaganata, G. (2018). Moving Object Tracking Using Hybrid Method. 606-610.

Swalaganata, G., Sulistyaningrum, D. R., & Setiyono, B. (2017). Super-resolution imaging applied to moving object tracking. Journal of Physics: Conference Series, 893. doi:10.1088/1742-6596/893/1/012062

Swalaganata, G., Sulistyaningrum, D. R., & Setiyono, B. (2017, 10). Super-resolution imaging applied to moving object tracking. Journal of Physics: Conference Series. 893, p. 012062. IOP Publishing. doi:10.1088/1742-6596/893/1/012062

Tietz, T. (2017). Édouard-Gaston Deville and the Perfection of Photogrammetry - SciHi BlogSciHi Blog. Retrieved from http://scihi.org/edouard-gaston-deville-photogrammetry/

Tridavid. (n.d.). Triatlon 2017 - Fietsroute. Retrieved from https://www.routeyou.com/nl-be/route/view/4624306/fietsroute/triatlon-2…

Tsai, G. (2010). Histogram of oriented gradients. 1-17. Retrieved from https://pdfs.semanticscholar.org/presentation/342b/c8b55d46f822e1574e4c…

Tsai, R. Y. (1987, 8). A Versatile Camera Calibration Technique for High-Accuracy 3D Machine Vision Metrology Using Off-the-Shelf TV Cameras and Lenses. IEEE Journal on Robotics and Automation, 3, 323-344. doi:10.1109/JRA.1987.1087109

Tweewieler, R. (2019). Merida pakt op Bike MOTION uit met limited edition Reacto Disc YC. Retrieved from https://www.tweewieler.nl/winkel/nieuws/2019/02/merida-pakt-op-bike-mot…

Unsch, H. R. (2013). Particle filters. Bernoulli, 19, 1391-1403. doi:10.3150/12-BEJSP07

Van Gool, L., Everingham, M., Zisserman, A., Winn, J., & Williams, C. K. (2009). The Pascal Visual Object Classes (VOC) Challenge. International Journal of Computer Vision, 88, 303-338. doi:10.1007/s11263-009-0275-4

Velasco-Montero, D., Fernández-Berni, J., Carmona-Galán, R., & Rodríguez-Vázquez, Á. (2018). Optimum Network/Framework Selection from High-Level Specifications in Embedded Deep Learning Vision Applications. Lecture Notes in Computer Science (including subseries Lecture Notes in Artificial Intelligence and Lecture Notes in Bioinformatics), 11182 LNCS, 369-379. doi:10.1007/978-3-030-01449-0_31

Wang, J., Yang, L., Rezaie, A. R., Li, J., & Louis, S. (2011). Distinctive Image Features from Scale-Invariant Keypoints. International Journal of Computer Vision. doi:10.1111/j.1538-7836.2011.04331.x

Weng, L. (2017). Object Detection: Gradient Vector, HOG, and SS. Retrieved from https://lilianweng.github.io/lil-log/2017/10/29/object-recognition-for-…

Wu, Y., Lim, J., & Yang, M. H. (2013). Online object tracking: A benchmark. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, (pp. 2411-2418). doi:10.1109/CVPR.2013.312

Xiang, Y., Alahi, A., & Savarese, S. (2015). Learning to Track : Online Multi- Object Tracking by Decision Making Multi-Object Tracking. doi:10.1109/ICCV.2015.534

Ximea. (n.d.). Compact cameras with PCIe interface for embedded applications and deep integrations. Tech. rep. Retrieved from https://www.ximea.com/files/brochures/xiX-OEM-cameras-for-integration-2…

Xu, X., Huang, B., & Dubljevic, S. (2015). Optimal state estimation for linear systems with state constraints. IFAC-PapersOnLine, 28, pp. 153-157. doi:10.1016/j.ifacol.2015.08.173

Yazdi, M., & Bouwmans, T. (2018, 5). New trends on moving object detection in video images captured by a moving camera: A survey. 28, 157-177. Elsevier. doi:10.1016/j.cosrev.2018.03.001

Yilmaz, A., Javed, O., & Shah, M. (2006). Object tracking. ACM Computing Surveys, 38, 13--es. doi:10.1145/1177352.1177355

Zhang, Z. (2002). A Flexible New Technique for Camera Calibration (Technical Report). IEEE Transactions on Pattern Analysis and Machine Intelligence, 22, 1330-1334. doi:10.1109/34.888718

Zhang, Z. (2004). Camera calibration with one-dimensional objects. 26, 892-899.