Leert artificiële intelligentie ons om te gaan met groene energie?

- NadiaWiesé

"We treden vandaag nog in actie om Europa het eerste klimaatneutrale continent te maken tegen 2050!" Dat waren de bijna profetische woorden van Ursula von der Leyen, de eerste vrouwelijke commissievoorzitter van de Europese Unie. De nieuwe klimaatmaatregels winden er geen doekjes om: de integratie van hernieuwbare energie op het elektriciteitsnet zal een sleutelrol spelen in die groene (r)evolutie. U bent zich ongetwijfeld bewust van de achterliggende problematiek: de strijd tegen de opwarming van onze aarde. Maar weet u ook dat het integreren van hernieuwbare energie in het huidige elektriciteitsnetwerk niet altijd vanzelfsprekend is en zelfs zijn veiligheid in gedrang kan brengen? Wij zochten de oplossing in artificiële intelligentie en – opgepast spoileralert - bewezen haar nut. Leest u vooral verder!

Zonnepanelen: zegen of vloek

Vandaag zijn vele elektriciteitsverbruikers op het laagspanningsnet, zoals u en ik, niet langer consumenten, maar prosumenten: ze consumeren niet alleen elektriciteit, maar zijn ook producent geworden door te investeren in zonnepanelen. Op zonnige namiddagen produceren deze zonnepanelen meer elektriciteit dan er op dat ogenblik plaatselijk verbruikt wordt. En net zoals het waterniveau stijgt in een waterreservoir, waar meer water wordt ingepompt dan afgenomen, zal zo ook het spanningsniveau stijgen op het plaatselijke elektriciteitsnetwerk. Een te grote hoeveelheid lokaal geïnjecteerde energie kan leiden tot een spanning ver boven de gewoonlijke 230 Volt, wat de normale werking van het net in gevaar brengt. Deze evolutie stelt de netbeheerder voor een uitdaging om de veilige werking te blijven garanderen.

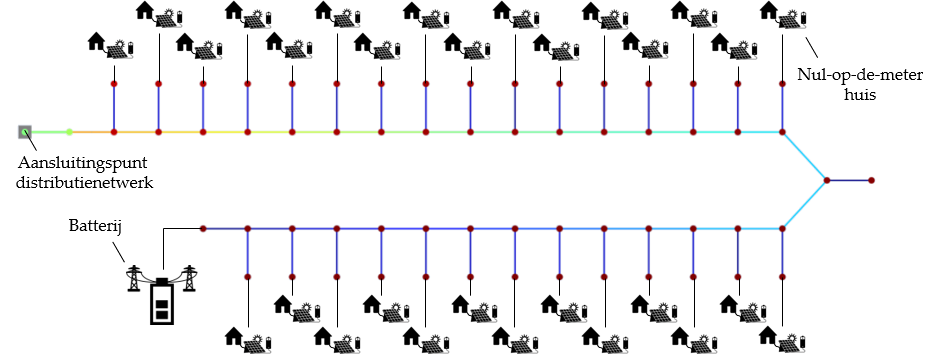

Nul-op-de-meterhuizen: slimme oplossingen nodig

Ook in Nederland is men zich van deze problematiek bewust. In het ‘REnnovates’-project werden 249 sociale woningen gerenoveerd met als doel evenveel elektriciteit te produceren als te verbruiken. De elektriciteitsteller draait dan evenveel vooruit als achteruit: nul op de meter dus. Dit werd mede mogelijk gemaakt door het installeren van zonnepanelen. U voelt de bui al hangen: veel elektriciteit naar het netwerk op zonnige dagen, maar een te lage vraag om al die energie op te souperen. Zouden batterijen ons hulp kunnen bieden om dit overschot aan energie op te vangen?

Het doel van onze thesis was tweeledig: enerzijds via een simulatiemodel de ernst van deze situatie kwantificeren en anderzijds met een intelligente oplossing op de proppen komen. Intelligent, leest u, want de bijna onvoorspelbare verbruikspatronen van consumenten en het grillige productiepatroon van de zonnepanelen maken hiervan een erg complex probleem. Wij vonden soelaas in zelflerende controle-eenheden die op een slimme manier batterijen kunnen aansturen.

Deep reinforcement learning: een wedloop van straffen en belonen

Deep reinforcement learning is een methode binnen de artificiële intelligentie: een computer of controle-eenheid wordt zelflerend door gebruik te maken van een beloningsproces. Het idee is eenvoudig: de controle-eenheid, geplaatst in het elektriciteitsnet, wordt verplicht te interageren met zijn omgeving en acties te nemen, in dit geval batterijen opladen of ontladen. Het doel: geen enkele spanning ver laten afwijken van 230 Volt en zo overspanningen voorkomen. Dit gebeurt aan de hand van een beloningsfunctie: indien de actie geen overspanning kan voorkomen, worden minpunten toegekend; hoe hoger deze overspanning, hoe meer minpunten. Goede acties daarentegen worden beloond met een hogere scoring, waardoor dit gedrag bij de controle-eenheid gestimuleerd wordt op lange termijn. Ook de hond van Pavlov is hier niet onbekend mee.

De opgedane kennis wordt in elke iteratie opgeslagen in een neuraal netwerk. Bekijk dit als een digitaal stel hersenen dat de vertaalslag maakt van de geobserveerde toestand van het elektriciteitsnetwerk naar een afgewogen batterij-actie. Aan het begin van het leerproces wordt dit brein lukraak geïnitialiseerd en, net zoals een pasgeboren baby nog geen kennis van goed of slecht heeft, zullen de geselecteerde acties vaak zelfs een averechts effect hebben. Door die foutieve acties af te straffen, groeit ‘ons kind’ geleidelijk op tot een volwassene die er quasi steeds in slaagt de juiste handeling te treffen.

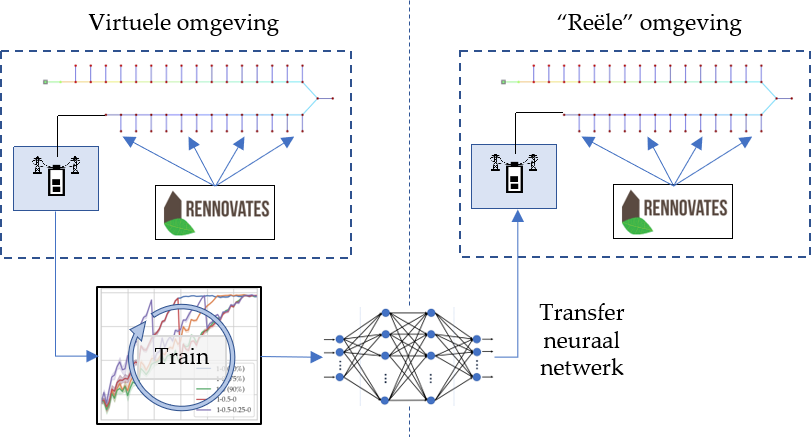

Data-inefficiëntie: transfer learning

Wat had u gedacht: toch is er ook een keerzijde aan deze medaille. Om een goed prestatieniveau te bereiken, heeft de controle-eenheid een enorme hoeveelheid data nodig. In onze simulaties bleek ongeveer zestig jaar aan interactie met de omgeving nodig te zijn alvorens adequate resultaten te boeken. Dat is misschien leuk voor uw kleinkinderen, maar op korte termijn biedt dit geen oplossing. We bestudeerden het concept van transfer learning om deze moeilijkheden te overkomen.

Eerst wordt het neuraal netwerk, dat digitale brein, getraind met een beschikbare dataset in een gesimuleerd, gelijkaardig elektriciteitsnetwerk voor meerdere virtuele jaren. Dit simulatieproces duurt geen zestig jaar, maar een verdienstelijke twee dagen op onze computers. Hierna wordt dat intelligente neurale netwerk overgedragen naar de echte controle-eenheid. Om de metafoor te vervolledigen: alvorens uw kind geboren wordt, zou u het in dit geval een stel hersenen meegeven dat reeds de kennis van een volledig leven bevat.

Een groot voordeel van het werken met neurale netwerken, is dat deze typisch goed zijn in generalisatie of veralgemening. Hierbij wordt zich een algemene strategie eigen gemaakt: een kind dat in een kledingwinkel terechtgewezen wordt op zijn luidruchtig gedrag, zal ook leren dat het niet op andere openbare plaatsen moet roepen. Deze leerstrategie komt ten goede bij transfer learning, wat ook zal blijken uit onze resultaten. Hoewel de gesimuleerde omgeving in de eerste fase geen exacte kopie is van de reële omgeving in de tweede fase, zal de controle-eenheid de opgedane kennis rond een ontlaad- en oplaadstrategie van de batterijen nog steeds kunnen toepassen. En dat zelfs in een verschillende omgeving met een complex en menselijk consumptiegedrag. Bedankt artificiële intelligentie!

Conclusie

In onze thesis wordt niet enkel aangetoond dat voornoemde modellen succesvol spanningsproblemen kunnen verhelpen door zichzelf complexe regelstrategieën eigen te maken; ook is er aangetoond dat de sterkste limitatie van deze methode, de grote data-inefficiëntie, verholpen kan worden door het overdragen van gesimuleerde ervaringen naar de werkelijke leeromgeving. De resultaten spreken voor zich: meer dan 98% van de overspanningsproblemen werden verholpen. We geloven dan ook sterk dat het toepassen van deze methode zijn steentje kan bijdragen in onze tocht naar een groenere toekomst.

Bibliografie

[1] R. S. Sutton and A. G. Barto, Reinforcement Learning: An Introduction. MIT press, second ed., 2018.

[2] A. Soares, D. Geysen, F. Spiessens, D. Ectors, O. De Somer, and K. Vanthournout, “Using reinforcement learning for maximizing residential selfconsumption - Results from a field test,” Energy and Buildings, 2019.

[3] B. Dean, J. Dulac, K. Petrichenko, and P. Graham, “Towards a zero-emission, efficient, and resilient buildings and construction sector,” 2016. [Online]. Available: https://www.worldgbc.org/sites/default/files/UNEP 188 GABC en (web).pdf. [Accessed: 2019-12-01].

[4] J. R. V´azquez-Canteli and Z. Nagy, “Reinforcement learning for demand response: A review of algorithms and modeling techniques,” Applied Energy, vol. 235, no. October 2018, pp. 1072–1089, 2019.

[5] C. Protopapadaki and D. Saelens, “Heat pump and PV impact on residential low-voltage distribution grids as a function of building and district properties,” Applied Energy, vol. 192, pp. 268–281, 2017.

[6] C. Finck, J. Clauß, P. Vogler-Finck, P. Beagon, K. Zhang, and H. Kazmi, “Review of applied and tested control possibilities for energy flexibility in buildings,” tech. rep., 2018.

[7] H. Kazmi, J. Suykens, A. Balint, and J. Driesen, “Multi-agent reinforcement learning for modeling and control of thermostatically controlled loads,” Applied Energy, vol. 238, no. June 2018, pp. 1022–1035, 2019.

[8] M. Ribeiro, K. Grolinger, H. F. ElYamany, W. A. Higashino, and M. A. Capretz, “Transfer learning with seasonal and trend adjustment for cross-building energy forecasting,” Energy and Buildings, vol. 165, pp. 352–363, 2018.

[9] F. Qian, W. Gao, Y. Yang, and D. Yu, “Potential analysis of the transfer learning model in short and medium-term forecasting of building HVAC energy consumption,” Energy, vol. 193, p. 116724, 2020.

[10] Q. Hu, R. Zhang, and Y. Zhou, “Transfer learning for short-term wind speed prediction with deep neural networks,” Renewable Energy, vol. 85, pp. 83–95, 2016.

[11] “i.LECO,” 2019. [Online]. Available: https://ileco.energy/. [Accessed: 2019-12- 01].

[12] “REnnovates,” 2019. [Online]. Available: https://rennovates.eu/. [Accessed: 2019-10-01].

[13] IEA, “World Energy Outlook 2018,” 2018. [Online]. Available: https://www.iea.org/reports/world-energy-outlook-2018. [Accessed: 2019-12- 01].

[14] CEER, “Electricity - voltage quality,” 6th CEER Benchmarking Report on the Quality of Electricity and Gas Supply - 2016, pp. 80–137, 2016.

[15] VREG, “Energy market,” 2019. [Online]. Available: https://www.vreg.be/en/energy-market. [Accessed: 2019-12-11].

[16] R. Belmans, G. Deconinck, and J. Driesen, Elektrische Energie Deel 2. ACCO, 2011.

[17] Y. Liu, W. Qin, X. Han, P. Wang, Y. Wang, L. Wang, and F. Li, “Distribution network voltage control by active power/reactive power injection from PV inverters,” 2018.

[18] T. Xu and P. Taylor, “Voltage Control Techniques for Electrical Distribution Networks Including Distributed Generation,” IFAC Proceedings Volumes, vol. 41, no. 2, pp. 11967–11971, 2008.

[19] A. P. Kenneth and K. Folly, “Voltage rise issue with high penetration of grid connected PV,” in IFAC Proceedings Volumes (IFAC-PapersOnline), vol. 19, pp. 4959–4966, IFAC, 2014.

[20] European Commission (EC), “Third energy package,” 2019. [Online]. Available: https://ec.europa.eu/energy/en/topics/markets-and-consumers/marketlegis…. [Accessed: 2019-12-13].

[21] European Commission (EC), “Energy Efficiency Directive,” 2019. [Online]. Available: https://ec.europa.eu/energy/en/topics/energy-efficiency/targets-directi…. [Accessed: 2019-12-13].

[22] A. Afram and F. Janabi-Sharifi, “Review of modeling methods for HVAC systems,” Applied Thermal Engineering, vol. 67, no. 1-2, pp. 507–519, 2014.

[23] K. J. Hunt, D. Sbarbaro, R. Zbikowski, and P. J. Gawthrop, “Neural networks for control systems-A survey,” Automatica, vol. 28, no. 6, pp. 1083–1112, 1992.

[24] P. Kofinas, A. I. Dounis, and G. A. Vouros, “Fuzzy Q-Learning for multi-agent decentralized energy management in microgrids,” Applied Energy, vol. 219, no. March, pp. 53–67, 2018.

[25] L. Torrey and J. Shavlik, “Handbook of Research on Machine Learning Applications,” pp. 242–264, IGI Global, 2009.

[26] H. Kazmi and J. A. K. Suykens, “Large-scale transfer learning for data-driven modelling of hot water systems,” no. August, 2019.

[27] M. R. Tousi, S. H. Hosseinian, and M. B. Menhaj, “A Multi-agent-based voltage control in power systems using distributed reinforcement learning,” Simulation, vol. 87, no. 7, pp. 581–599, 2011.

[28] Zou, Jinming, Y. Han, and S.-S. So, “Overview of artificial neural networks,” in Artificial Neural Networks: Methods and Applications (D. J. Livingstone, ed.), pp. 14–22, Sandown: Humana Press, 2008.

[29] V. Mnih, K. Kavukcuoglu, D. Silver, A. A. Rusu, J. Veness, M. G. Bellemare, A. Graves, M. Riedmiller, A. K. Fidjeland, G. Ostrovski, S. Petersen, C. Beattie, A. Sadik, I. Antonoglou, H. King, D. Kumaran, D. Wierstra, S. Legg, and D. Hassabis, “Human-level control through deep reinforcement learning,” Nature, vol. 518, no. 7540, pp. 529–533, 2015.

[30] G. Shi, D. Liu, and Q. Wei, “Echo state network-based Q-learning method for optimal battery control of offices combined with renewable energy,” IET Control Theory and Applications, vol. 11, no. 7, pp. 915–922, 2017.

[31] B. Jiang and Y. Fei, “Dynamic residential demand response and distributed generation management in smart microgrid with hierarchical agents,” in Energy Procedia, vol. 12, pp. 76–90, 2011.

[32] D. Lee and W. B. Powell, “An intelligent battery controller using bias-corrected Q-learning,” in Proceedings of the National Conference on Artificial Intelligence, vol. 1, pp. 316–322, 2012.

[33] D. Li and S. K. Jayaweera, “Reinforcement learning aided smart-home decisionmaking in an interactive smart grid,” in 2014 IEEE Green Energy and Systems Conference, IGESC 2014, pp. 1–6, IEEE, 2015.

[34] Y. Wang, X. Lin, and M. Pedram, “A near-optimal model-based control algorithm for households equipped with residential photovoltaic power generation and energy storage systems,” IEEE Transactions on Sustainable Energy, vol. 7, no. 1, pp. 77–86, 2016.

[35] A. Sheikhi, M. Rayati, and A. M. Ranjbar, “Demand side management for a residential customer in multi-energy systems,” Sustainable Cities and Society, vol. 22, pp. 63–77, 2016.

[36] L. Raju, S. Sankar, and R. S. Milton, “Distributed optimization of solar microgrid using multi agent reinforcement learning,” in Procedia Computer Science, vol. 46, pp. 231–239, Elsevier Masson SAS, 2015.

[37] S. Sekizaki, T. Hayashida, and I. Nishizaki, “An intelligent Home Energy Management System with classifier system,” in 2015 IEEE 8th International Workshop on Computational Intelligence and Applications, IWCIA 2015 - Proceedings, pp. 9–14, IEEE, 2016.

[38] B. V. Mbuwir, F. Ruelens, F. Spiessens, and G. Deconinck, “Battery energy management in a microgrid using batch reinforcement learning,” Energies, vol. 10, no. 11, pp. 1–19, 2017.

[39] T. Navidi, “Coordination of Distributed Energy Resources without Power Grid Models using Reinforcement Learning,” tech. rep., Standford University, 2018.

[40] X. Qiu, T. A. Nguyen, and M. L. Crow, “Heterogeneous Energy Storage Optimization for Microgrids,” IEEE Transactions on Smart Grid, vol. 7, no. 3, pp. 1453–1461, 2016.

[41] S. J. Pan and Q. Yang, “A Survey on Transfer Learning,” IEEE Transactions on Knowledge and Data Engineering, vol. 2, no. 10, pp. 1345–1359, 2010.

[42] “Linear,” 2019. [Online]. Available: http://www.linear-smartgrid.be/. [Accessed:2019-10-08].

[43] “Keras: The Python Deep Learning library. [accessed: 2019-10-08],” 2019. [Online]. Available: https://keras.io/.

[44] “Tensorflow,” 2019. [Online]. Available: https://www.tensorflow.org/. [Accessed:2019-10-08].

[45] L. Thurner, A. Scheidler, F. Schafer, J. H. Menke, J. Dollichon, F. Meier, S. Meinecke, and M. Braun, “Pandapower - An Open-Source Python Tool for Convenient Modeling, Analysis, and Optimization of Electric Power Systems,” IEEE Transactions on Power Systems, vol. 33, pp. 6510–6521, nov 2018.

[46] W. McKinney, “Data Structures for Statistical Computing in Python,” Proceedings of the 9th Python in Science Conference, vol. 445, pp. 51–56, 2010.

[47] “PYPOWER 5.1.4,” 2019. [Online]. Available: https://pypi.org/project/PYPOWER/. [Accessed: 2019-10-08].

[48] R. Sevlian and R. Rajagopal, “A scaling law for short term load forecasting on varying levels of aggregation,” International Journal of Electrical Power and Energy Systems, vol. 98, no. August 2017, pp. 350–361, 2018.

[49] P. Ramachandran, B. Zoph, and Q. V. Le, “Searching for activation functions,” in 6th International Conference on Learning Representations, ICLR 2018 -Workshop Track Proceedings, pp. 1–13, 2018.

[50] P. Henderson, R. Islam, P. Bachman, J. Pineau, D. Precup, and D. Meger, “Deep reinforcement learning that matters,” in 32nd AAAI Conference on Artificial Intelligence, AAAI 2018, pp. 3207–3214, 2018.

[51] B. Q. Huang, G. Y. Cao, and M. Guo, “Reinforcement learning neural network to the problem of autonomous mobile robot obstacle avoidance,” 2005 International Conference on Machine Learning and Cybernetics, ICMLC 2005, no. August, pp. 85–89, 2005.

[52] S. Elfwing, E. Uchibe, and K. Doya, “Sigmoid-weighted linear units for neural network function approximation in reinforcement learning,” Neural Networks, vol. 107, pp. 3–11, 2018.

[53] P. Covington, J. Adams, and E. Sargin, Deep neural networks for youtube recommendations. New York: Association for Computing Machinery, 2016.

[54] R. Liessner, J. Schmitt, A. Dietermann, and B. B¨aker, “Hyperparameter optimization for deep reinforcement learning in vehicle energy management,” in ICAART 2019 - Proceedings of the 11th International Conference on Agents and Artificial Intelligence, vol. 2, pp. 134–144, 2019.

[55] M. Groissb¨ock, “Are open source energy system optimization tools mature enough for serious use?,” 2019.

[56] Energy Management and Power System Operation. University of Kassel and the Department for Distribution System Operation at the Fraunhofer Institute for Energy Economics and Energy System Technology (IEE), “pandapower,” 2019. [Online]. Available: https://www.pandapower.org/. [Accessed: 2019-12-01].

[57] J. H. Menke, N. Bornhorst, and M. Braun, “Distribution system monitoring for smart power grids with distributed generation using artificial neural networks,”

International Journal of Electrical Power and Energy Systems, vol. 113, no. July 2018, pp. 472–480, 2019.

[58] H. Hua, Y. Qin, C. Hao, and J. Cao, “Optimal energy management strategies

for energy Internet via deep reinforcement learning approach,” Applied Energy, vol. 239, no. June 2018, pp. 598–609, 2019.

[59] E. Hoffer, I. Hubara, and D. Soudry, “Train longer, generalize better: closing the generalization gap in large batch training of neural networks,” in Advances

in Neural Information Processing Systems 30, pp. 1731–1741, Curran Associates, Inc., 2017.