Tussen je twee oren kan je stemmen horen!

Dat het volgen van een gesprek in dagdagelijkse, rumoerige omstandigheden soms een hele uitdaging is weten we allemaal. Voor dragers van een cochleair implantaat (CI) is dit echter des te moeilijker omdat ze de stem van de spreker niet altijd even goed kunnen waarnemen. Een vroegtijdige evaluatie van de stemperceptie bij jonge CI-gebruikers via elektro-encefalografie (EEG) zou de taalontwikkeling bij deze kinderen ten goede kunnen komen. Maar welke stimuli kunnen nu het best gebruikt worden om dit te evalueren? Als je hierover meer wil horen, dan spits je nu best de oren!

Beethoven: een muzikaal genie zonder CI

‘Voor mij geen verfijnde gesprekken of uitwisseling van vertrouwelijkheden. Ik moet een teruggetrokken leven leiden en neem slechts deel aan de maatschappij als het absoluut noodzakelijk is.’ Dit zijn woorden van Ludwig van Beethoven, de wereldbefaamde componist van wie we in 2020 het 250e jubileumjaar vieren. De geniale musicus verwijst daarmee naar zijn ernstig gehoorverlies. Hoewel de oorzaak van dit gehoorverlies onderwerp van discussie blijft, is het best mogelijk dat Beethoven twee eeuwen later geholpen had kunnen worden met een cochleair implantaat (CI).

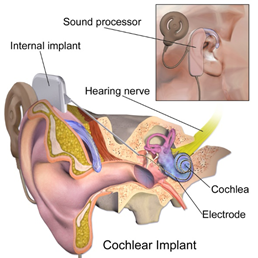

Een CI is een elektronisch implantaat dat de functie van de cochlea nabootst indien hierin ernstige schade is ontstaan aan de haarcellen. Dan zullen de zenuwbanen die van de cochlea naar de hersenschors lopen niet meer getriggerd worden door geluiden. Met een CI probeert men deze beschadiging te omzeilen, door operatief een fijne draad met een twintigtal elektroden in de cochlea te schuiven en zo de zenuwbanen rechtstreeks te stimuleren. Je kan het misschien nog het best vergelijken met een pianospel waarbij je niet de fijne pianotoetsen aanslaat, maar wel met een brede houten hamer op de snaren in de klankkast timmert. Op een analoge manier kunnen geluiden en verschillende elementen van spraak, die voordien niet meer hoorbaar waren, weer waargenomen worden. Door de grote psychosociale invloed van spraakperceptie wordt een CI, ondanks zijn beperkingen, vaak aanzien als één van de meest verfijnde en technologisch geavanceerde medische implantaten!

Een stem met impact

Hoewel CI-gebruikers gesprekken meestal goed kunnen volgen in een rustige omgeving, blijft het verstaan van spraak onder realistische luisteromstandigheden, waar achtergrondgeluid permanent aanwezig is, lastig. Denk daarbij bijvoorbeeld aan het geroezemoes op een gezellig, corona-proof terrasje. Dit verschijnsel kan verklaard worden doordat een CI de toonhoogte van de menselijke stem slechts onnauwkeurig kan coderen. Deze toonhoogte, die ook wel fundamentele frequentie (f0) wordt genoemd, komt overeen met de trillingsfrequentie van de stembanden en speelt een essentiële rol bij onder andere sprekersidentificatie, waarnemen van intonatie én spraakverstaan in rumoerige omstandigheden.

Jong geleerd, oud gedaan

Bij kinderen die doof of slechthorend geboren worden, plaatst men een CI vaak reeds vóór de leeftijd van 24 maanden. Onderzoek heeft namelijk aangetoond dat vroegtijdige behandeling van gehoorverlies positieve gevolgen heeft voor de communicatie, cognitie, leesvaardigheid en sociaal-emotionele ontwikkeling van deze kinderen. Daarnaast is de periode vóór 24 maanden erg belangrijk voor taalontwikkeling, waarbij het optimaal kunnen horen van spraakklanken, intonatie, etc. een vereiste is. Het is dus van groot belang dat men bij zeer jonge CI-gebruikers al op vroege leeftijd kan evalueren in welke mate het CI voldoende toegang geeft tot de fundamentele frequentie. Op die manier kan CI-therapie op maat ingezet worden.

Gissen is missen

Voor het detecteren van gehoorverlies bij pasgeborenen en jonge kinderen maakt men in het ziekenhuis gebruik van meetmethoden waarbij men via EEG opmeet in welke mate de zenuwbanen geluiden doorsturen naar het brein. Een voorbeeld hiervan is de ALGO-test uit het gehoorscreeningsprogramma voor pasgeborenen van ‘Kind en Gezin’. Deze ‘objectieve’ meetmethoden zijn in de eerste plaats interessant omdat ze geen medewerking van het jonge kind vereisen; medewerking die op deze leeftijd nog niet mogelijk of onbetrouwbaar is. Je zou dus kunnen denken dat deze testen ideaal zijn om een beter inzicht te krijgen in welke mate de jonge CI-gebruiker baat heeft bij zijn CI. Dit is echter niet helemaal juist. Deze hedendaagse meetmethoden maken bij het opmeten van het EEG-signaal uitsluitend gebruik van korte knaltoontjes (‘clicks’ en ‘tone bursts’) en constante tonen als aangeboden geluidsstimuli. Deze stimuli zijn niet toepasbaar bij CI-gebruikers, omdat het CI spraakstimuli op een andere manier verwerkt dan niet-spraakstimuli. Verder kan men met deze stimuli bijvoorbeeld ook niet nagaan in welke mate CI-gebruikers intonatie horen.

Uniform is de norm

Vandaag wordt er binnen de audiologie dan ook voortschrijdend onderzoek verricht naar de verwerking van de f0 in het brein met behulp van spraakstimuli en/of stimuli met intonatie bij normaalhorende volwassenen. Daarbij is men voornamelijk op zoek naar stimuli die een zeer duidelijk EEG-signaal uitlokken, gezien dit voordeliger is voor toekomstige, instabiele EEG-metingen bij jonge kinderen. Het is echter moeilijk om op basis van deze studies een betrouwbare uitspraak te doen over de stimuli waarbij de f0 het best tot uiting komt in het EEG-signaal. De studies vertonen namelijk niet alleen grote variaties op vlak van onderzoeksopzet, maar evengoed op het vlak van gehanteerde stimuli (klinkers, woorden, zinnen, …).

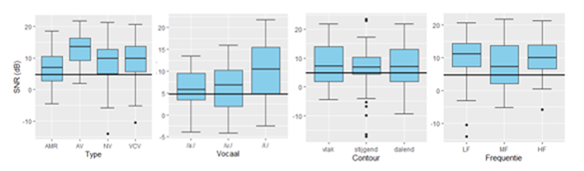

Daarom was het doel van deze masterthesis om een overkoepelende studie uit te voeren, waarbij een globaal inzicht werd verworven in het effect van enkele variërende stimulusparameters op de weerspiegeling van de f0 in het EEG van normaalhorende personen.

Meten is weten

Voor mijn onderzoek heb ik 16 normaalhorende jongvolwassenen aan een EEG-meting onderworpen. Tijdens deze meting kregen ze zowel spraak- als niet-spraakstimuli (ruis, artificiële klinker, natuurlijke klinker, woord) te horen met variabele intonatiepatronen (stijgend, dalend, vlak) en toonhoogtes (hoog-, midden- en laagfrequent). Deze gecombineerde stimuli werden telkens aangeboden aan een geluidsniveau dat representatief is voor een verheven stem in een rumoerige situatie.

Analyse van de resultaten suggereert dat de artificiële klinker /i:/ met een vlakke of slechts traag verglijdende intonatie in het laag- of hoogfrequente gebied van de spreekstem tot het meest uitgesproken EEG-signaal leidt.

Deze studie geeft ons dus een inzicht in welke spraakstimuli het best gebruikt kunnen worden voor toekomstig EEG-onderzoek in het kader van vroegtijdige evaluatie van f0-perceptie.

Dus wie denkt: ‘Als stimulus… Beethovens 5e Symfonie in full speed?’ Liever niet!

Bibliografie

Aiken, S. J., & Picton, T. W. (2006). Envelope following responses to natural vowels. Audiology and Neurotology, 11(4), 213–232.

Aiken, S. J., & Picton, T. W. (2008). Envelope and spectral frequency-following responses to vowel sounds. Hearing Research, 245(1–2), 35–47.

American Clinical Neurophysiology Society. (2006). Guideline 5: Guidelines for Standard Electrode Position Nomenclature. American Journal of Electroneurodiagnostic Technology, 46(3), 222–225.

Ananthakrishnan, S., Luo, X., & Krishnan, A. (2017). Human Frequency Following Responses to Vocoded Speech. Ear & Hearing, 38(5), 256–267.

Bear, M. F., Connors, B. W., & Paradiso, M. A. (2015). The auditory and verstibular system. In L. G. Francis, J. Joyce, & T. Lochhaas. (Eds.) Neuroscience: Exploring the brain: Fourth edition (pp. 391-393). Philadelphia: Wolters Kluwer.

Beutelmann, R., Laumen, G., Tollin, D., & Klump, G. M. (2015). Amplitude and phase equalization of stimuli for click evoked auditory brainstem responses. The Journal of the Acoustical Society of America, 137(1), 71-77.

Bidelman, G. M. (2015). Multichannel recordings of the human brainstem frequency-following response: Scalp topography, source generators, and distinctions from the transient ABR. Hearing Research, 323, 68–80.

Bidelman, G. M., Gandour, J. T., & Krishnan, A. (2011). Musicians and tone-language speakers share enhanced brainstem encoding but not perceptual benefits for musical pitch. Brain and Cognition, 77(1), 1–10.

Billings, C. J., Bologna, W. J., Muralimanohar, R. K., Madsen, B. M., & Molis, M. R. (2019). Frequency following responses to tone glides: Effects of frequency extent, direction, and electrode montage. Hearing Research, 375, 25–33.

Bloothooft, G. (2008). Fonetiek van de inleidende taalwetenschap: spraakakoestiek [cursus]. Utrecht: Universiteit Utrecht, Departement Talen, Literatuur en Communicatie.

Boersma, P., & van Heuven, V. (2001). Speak and unSpeak with Praat. Glot International, 5(9–10), 341–347.

Carhart, R., & Jerger, J. F. (1959). Preferred Method For Clinical Determination Of Pure-Tone Thresholds. Journal of Speech and Hearing Disorders, 24(4), 330-345.

Catteeuw, J., & Pauwels, C. (2016). In welke mate kan datalogging een kwalitatieve bijdrage leveren aan de begeleiding van ouders van jonge kinderen met CI? Datalogging en LENA als hulpmiddelen bij het bepalen van de kwantiteit en kwaliteit van de auditieve input (Bachelorproef). Retrieved February 12, 2020 from https://www.scriptiebank.be/scriptie/2016/welke-mate-kan-datalogging-ee…

Chi, T., Gao, Y., Guyton, M. C., Ru, P., & Shamma, S. (1999). Spectro-temporal modulation transfer functions and speech intelligibility. The Journal of the Acoustical Society of America, 106(5), 2719–2732.

Choi, J. M., Purcell, D. W., Coyne, J. A. M., & Aiken, S. J. (2013). Envelope following responses elicited by english sentences. Ear and Hearing, 34(5), 637–650.

Clinard, C. G., & Cotter, C. M. (2015). Neural representation of dynamic frequency is degraded in older adults. Hearing Research, 323, 91–98.

Cobb, K. M., & Stuart, A. (2016). Neonate Auditory Brainstem Responses to CE-Chirp and CE-Chirp Octave Band Stimuli I: Versus Click and Tone Burst Stimuli. Ear and Hearing, 37(6), 710–723.

Coffey, E. B. J., Colagrosso, E. M. G., Lehmann, A., Schönwiesner, M., & Zatorre, R. J. (2016). Individual Differences in the Frequency-Following Response: Relation to Pitch Perception. PloS One, 11(3), e0152374.

Coffey, E. B. J., Herholz, S. C., Chepesiuk, A. M. P., Baillet, S., & Zatorre, R. J. (2016). Cortical contributions to the auditory frequency-following response revealed by MEG. Nature Communications, 7, 1–11.

Coffey, E. B. J., Nicol, T., White-Schwoch, T., Chandrasekaran, B., Krizman, J., Skoe, E., … Kraus, N. (2019). Evolving perspectives on the sources of the frequency-following response. Nature Communications, 10(1), 1–10.

Cohen, L. T., Rickards, F. W., & Clark, G. M. (1991). A comparison of steady-state evoked potentials to modulated tones in awake and sleeping humans. Journal of the Acoustical Society of America, 90(5), 2467–2479.

Collins, M. J., & Cullen, J. K. (1978). Temporal integration of tone glides. Journal of the Acoustical Society of America, 63(2), 469–473.

Cullen, J. K., & Collins, M. J. (1979). Rate effects in the detection of short‐duration tone glides. The Journal of the Acoustical Society of America, 65(1), 38–39.

Dillon, C., Pisoni, D. B., Cleary, M., & Carter, A. K. (2012). Nonword imitation by children with cochlear implants: Consonant analyses. Arch Otolaryngol Head Neck Surg, 130(5), 587–591.

Douglas, B., Machler, M., B., B., & Walker, S. (2015). Fitting Linear Mixed-Effects Models Using lme4. Journal of Statistical Software, 67(1), 1–48.

Easwar, V., Banyard, A., Aiken, S. J., & Purcell, D. W. (2018). Phase-locked responses to the vowel envelope vary in scalp-recorded amplitude due to across-frequency response interactions. European Journal of Neuroscience, 48(10), 3126–3145.

Elgoyhen, A. B., Langguth, B., De Ridder, D., & Vanneste, S. (2015). Tinnitus: Perspectives from human neuroimaging. Nature Reviews Neuroscience, 16(10), 632–642.

Encyclopaedia Brittanica, Inc. (2020). Transmission of sound within the inner ear. Retrieved May 9, 2020 from https://www.britannica.com/science/ear/Transmission-of-sound-within-the…

Farinetti, A., Raji, A., Wu, H., Wanna, B., & Vincent, C. (2018). International consensus (ICON) on audiological assessment of hearing loss in children, 135, 41–48.

Faulkner, A., & Rosen, S. (1999). Contributions of temporal encodings of voicing, voicelessness, fundamental frequency, and amplitude variation to audio-visual and auditory speech perception. The Journal of the Acoustical Society of America, 106(4), 2063–2073.

Finley, C. C., Holden, T. A., Holden, L. K., Whiting, B. R., Chole, R. A., Neely, G. J., … Skinner, M. W. (2008). Role of electrode placement as a contributor to variability in cochlear implant outcomes. Otology and Neurotology, 29(7), 920–928.

Galbraith, G. C., Arbagey, P. W., Branski, R., Comerci, N., & Rector, P. M. (1995). Intelligible speech encoded in the human brain stem frequency-following response. NeuroReport, 6, 2363-2367

Ghitza, O., & Greenberg, S. (2009). On the possible role of brain rhythms in speech perception: Intelligibility of time-compressed speech with periodic and aperiodic insertions of silence. Phonetica, 66(1–2), 113–126.

Glaser, E. M., Suter, C. M., Dasheiff, R., & Goldberg, A. (1976). The human frequency-following response: Its behavior during continuous tone and tone burst stimulation. Electroencephalography and Clinical Neurophysiology, 40(1), 25–32.

Goldenholz, D. M., Ahlfors, S. P., Hämäläinen, M. S., Sharon, D., Ishitobi, M., Vaina, L. M., & Stufflebeam, S. M. (2010). Mapping the Signal-To-Noise-Ratios of Cortical Sources in Magnetoencephalography and Electroencephalography. 30(4), 1077–1086.

Gransier, R., Deprez, H., Hofmann, M., Moonen, M., van Wieringen, A., & Wouters, J. (2016). Auditory steady-state responses in cochlear implant users: Effect of modulation frequency and stimulation artifacts. Hearing Research, 335, 149–160.

Greenberg, S., & Kingsbury, B. (1997). The modulation spectrogram: in pursuit. IEEE International Conference Online, 3, 1647–1650.

Hofmann, M., & Wouters, J. (2010). Electrically evoked auditory steady state responses in cochlear implant users. JARO - Journal of the Association for Research in Otolaryngology, 11(2), 267–282.

Hofmann, M., & Wouters, J. (2012). Improved electrically evoked auditory steady-state response thresholds in humans. Journal of the Association for Research in Otolaryngology, 13(4), 573–589.

Hotelling, H. (1992). The Generalization of Student’s Ratio. The Annals of Mathematical Statistics. 2(3), 360–378.

Jeng, F. C., Schnabel, E. A., Dickman, B. M., Hu, J., Li, X., Lin, C. Der, & Chung, H. K. (2010). Early maturation of frequency-following responses to voice pitch in infants with normal hearing. Perceptual and Motor Skills, 111(3), 765–784.

Johnson, K. L., Nicol, T. G., & Kraus, N. (2005). Brain stem response to speech: A biological marker of auditory processing. Ear and Hearing, 26(5), 424–434.

Kenway, B., Tam, Y. C., Vanat, Z., Harris, F., Gray, R., Birchall, J., … Axon, P. (2015). Pitch discrimination: An independent factor in cochlear implant performance outcomes. Otology and Neurotology, 36(9), 1472–1479.

Klatt, D. H. (1980). Software for a cascade/parallel formant synthesizer. Journal of the Acoustical Society of America, 67(3), 971–995.

Kraus, N., Anderson, S., White-Schwoch, T., Fay, R. R., & Popper, A. N. (2011). In R. R. Fay, & A. N. Popper. (Eds.). The frequency-following response: A window into human communication. New York: Springer.

Krishnan, A. (1999). Human frequency-following responses to two-tone approximations of steady-state vowels. Audiology and Neurotology, 4(2), 95–103.

Krishnan, A. (2000). Human Frequency-Following Response: Representation of Tonal Sweeps. Audiology and Neurotology, 5, 312–321.

Krishnan, A. (2002). Human frequency-following responses: Representation of steady-state synthetic vowels. Hearing Research, 166, 192-201.

Krishnan, A., Xu, Y., Gandour, J. T., & Cariani, P. A. (2004). Human frequency-following response: Representation of pitch contours in Chinese tones. Hearing Research, 189(1–2), 1–12.

Lasak, J. M., Allen, P., McVay, T., & Lewis, D. (2014). Hearing loss: Diagnosis and management. Primary Care - Clinics in Office Practice, 41(1), 19–31.

Leong, V., & Goswami, U. (2014). Impaired extraction of speech rhythm from temporal modulation patterns in speech in developmental dyslexia. Frontiers in Human Neuroscience, 8(2), 1–14.

Mason, S. M. (2004). Evoked potentials and their clinical application. Current Anaesthesia and Critical Care, 15(6), 392–399.

Miguel, L., Jesus, T. De, Vaz, F., & Principe, J. C. (1997). An Implementation of the Klatt Speech Synthesiser. Electrónica e Telecomunicações, 2(1), 141–146.

Mohammed, N., & Abdelsalam, S. (2015). Electric auditory brainstem response (E-ABR) in cochlear implant children : Effect of age at implantation and duration of implant use. Egyptian Journal of Ear, Nose, Throat and Allied Sciences, 16(2), 145–150.

Moore, J. K. (2000). Organization of the human superior olivary complex. Microscopy Research and Technique, 51(4), 403–412.

Moore, B. C. J. (2003). An Introduction to the Psychology of Hearing, 5th edition. Boston Academic Press.

Murphy, P. J. (2000). Spectral characterization of jitter, shimmer, and additive noise in synthetically generated voice signals. The Journal of the Acoustical Society of America, 107(2), 978–988.

Musacchia, G., Sams, M., Skoe, E., & Kraus, N. (2007). Musicians have enhanced subcortical auditory and audiovisual processing of speech and music. Proceedings of the National Academy of Sciences of the United States of America, 104(40), 15894–15898.

Musacchia, G., Strait, D., & Kraus, N. (2008). Relationships between behavior, brainstem and cortical encoding of seen and heard speech in musicians and non-musicians. Hearing Research, 241(1–2), 34–42.

Nie, K., Stickney, G., & Zeng, F. G. (2005). Encoding frequency modulation to improve cochlear implant performance in noise. IEEE Transactions on Biomedical Engineering, 52(1), 64–73.

Palmer, A. R., Winter, I. M., & Darwin, C. J. (1986). The representation of steady-state vowel sounds in the temporal discharge patterns of the guinea pig cochlear nerve and primarylike cochlear nucleus neurons. Journal of the Acoustical Society of America, 79(1), 100–113.

Peelle, J. E., & Davis, M. H. (2012). Neural oscillations carry speech rhythm through to comprehension. Frontiers in Psychology, 3(9), 1–17.

Pethe, J., Von Specht, H., Milkier, R., & Hocke, T. (2001). Amplitude modulation following responses in awake and sleeping humans - A comparison for 40 Hz and 80 Hz modulation frequency. Scandinavian Audiology Supplement, 52, 152-155.

Picton, T. W., John, M. S., Dimitrijevic, A., & Purcell, D. (2003). Human auditory steady-state responses. International Journal of Audiology, 42(4), 177–219.

Purcell, D. W., John, S. M., Schneider, B. A., & Picton, T. W. (2004). Human temporal auditory acuity as assessed by envelope following responses. The Journal of the Acoustical Society of America, 116(6), 3581–3593.

Rance, G., Roper, R., Symons, L., Moody, L. J., Poulis, C., Dourlay, M., & Kelly, T. (2005). Hearing threshold estimation in infants using auditory steady-state responses. Journal of the American Academy of Audiology. 16(5), 291-300.

Reichenbach, C. S., Braiman, C., Schiff, N. D., Hudspeth, A. J., & Reichenbach, T. (2016). The auditory-brainstem response to continuous, non-repetitive speech is modulated by the speech envelope and reflects speech processing. Frontiers in Computational Neuroscience, 10(5), 1–11.

Rosen, S. (1992). Temporal Information in Speech: Acoustic, Auditory and Linguistic Aspects. Philosophical Transactions of the Royal Society B: Biological Sciences, 336(1278), 367–373.

RStudio Team (2015). RStudio: Integrated Development for R. RStudio, Inc., Boston, MA.

Sadjadi, S. O., & Hansen, J. H. L. (2015). Mean Hilbert envelope coefficients (MHEC) for robust speaker and language identification. Speech Communication, 72, 138–148.

Satterthwaite, F. E. (1946). An Approximate Distribution of Estimates of Variance Components. Biometrics Bulletin, 2(6), 110–114

Shetty, H. N. (2016). Temporal cues and the effect of their enhancement on speech perception in older adults – A scoping review. Journal of Otology, 11(3), 95–101.

Shore, S. E., Clopton, B. M., & Au, Y. N. (1987). Unit responses in ventral cochlear nucleus reflect cochlear coding of rapid frequency sweeps. Journal of the Acoustical Society of America, 82(2), 471–478.

Shore, S. E., & Cullen, J. K. (1984). Cochlear microphonic responses of the peripheral auditory system to frequencyvarying signals. American Journal of Otolaryngology--Head and Neck Medicine and Surgery, 5(1), 34–42.

Shore, S. E., & Nuttall, A. L. (1985). High-synchrony cochlear compound action potentials evoked by rising frequency-swept tone bursts. Journal of the Acoustical Society of America, 78(4), 1286–1295.

Somers, B., Verschueren, E., & Francart, T. (2018). Neural tracking of the speech envelope in cochlear implant users [Electronic version]. Journal of Neural Engineering, 16, 3-16.

Spitzer, S. M., Liss, J. M., & Mattys, S. L. (2007). Acoustic cues to lexical segmentation: A study of resynthesized speech. The Journal of the Acoustical Society of America, 122(6), 3678–3687.

Svirsky, M. A., Teoh, S. W., & Neuburger, H. (2004). Development of language and speech perception in congenitally, profoundly deaf children as a function of age at cochlear implantation. Audiology and Neuro-Otology, 9(4), 224–233.

Swaminathan, J., Krishnan, A., & Gandour, J. T. (2008). Pitch encoding in speech and nonspeech contexts in the human auditory brainstem. NeuroReport, 19(11), 1163–1167.

Swanepoel, D. W. (2011). Clinical status of the auditory steady-state response in infants. Seminars in Hearing. 32(2), 163-171.

The Mathworks, I. (2016). MATLAB: R2016b. Natick, Massachusetts.

Tichko, P., & Skoe, E. (2017). Frequency-dependent fi ne structure in the frequency-following response : The byproduct of multiple generators. Hearing Research, 348, 1–15.

Traunmüller, H., & Eriksson, A. (1994). The frequency range of the voice fundamental in the speech of male and female adults. Department of Linguistics, University of Stockholm, 97, 191–5.

Turgeon, C., Trudeau-Fisette, P., Fitzpatrick, E., & Ménard, L. (2017). Vowel intelligibility in children with cochlear implants: An acoustic and articulatory study. International Journal of Pediatric Otorhinolaryngology, 101, 87–96.

Van Canneyt, J., Hofmann, M., Francart, T., & Wouters, J. (2016). High-Frequency Auditory Steady-state Responses in Cochlear Implant Users [poster].

Van Canneyt, J., Hofmann, M., Wouters, J., & Francart, T. (2019). The effect of stimulus envelope shape on the auditory steady-state response. Hearing Research, 380, 22–34.

Van Dyke, K., Lieberman, R., Presacco, A., & Anderson, S. (2017). Development of phase locking and frequency representation in the infant frequency-following response. Journal of Speech, Language, and Hearing Research, 60(9), 2740–2751.

Van Kerschaver, E., Boudewyns, A. N., Declau, F., Van De Heyning, P. H., & Wuyts, F. L. (2013). Socio-demographic determinants of hearing impairment studied in 103 835 term babies. European Journal of Public Health, 23(1), 55–60.

Verhaert, N., Willems, M., Van Kerschaver, E., & Desloovere, C. (2008). Impact of early hearing screening and treatment on language development and education level: Evaluation of 6 years of universal newborn hearing screening (ALGO®) in Flanders, Belgium. International Journal of Pediatric Otorhinolaryngology, 72(5), 599–608.

Verstraete, J., Forrez, G., Mertens, P., & Debruyne, F. (1993). The effect of sustained phonation at high and low pitch on vocal jitter and shimmer. Folia Phoniatrica et Logopaedica, 45(5), 223-228.

Wang, J., Nicol, T., Skoe, E., Sams, M., & Kraus, N. (2010). Emotion and the auditory brainstem response to speech. Neurosci Lett., 469(3), 319–323.

Wang, S., Hu, J., Dong, R., Liu, D., Chen, J., Musacchia, G., & Liu, B. (2016). Voice pitch elicited frequency following response in Chinese elderlies. Frontiers in Aging Neuroscience, 8(11), 1–7.

Wilson, B. S., & Dorman, M. F. (2008). Cochlear implants: A remarkable past and a brilliant future. Hearing Research, 242(1–2), 3–21.

World Health Organisation. (2020). Deafness and hearing loss. Retrieved May 24, 2020 from https://www.who.int/news-room/fact-sheets/detail/deafness-and-hearing-l…

Xu, Y., Krishnan, A., & Gandour, J. T. (2006). Specificity of experience-dependent pitch representation in the brainstem. NeuroReport, 17(15), 1601–1605.

Zhang, X., & Gong, Q. (2019). Frequency-following responses to complex tones at different frequencies reflect different source configurations. Frontiers in Neuroscience, 13(2), 1–18.