Spraak genereren: veel meer dan woorden alleen

Spraaksynthese, of het kunstmatig genereren van spraak, geeft een stem aan personen met ernstige spraakbeperkingen. Helaas is die kunstmatige stem nu vaak expressieloos. Dat terwijl we via onze manier van spreken ook onze emoties, meningen, en zaken als ironie uitdrukken. In mijn masterproef ging ik daarom op zoek naar een manier om gegenereerde spraak expressiever te maken en om gebruikers toe te laten deze expressiviteit zelf te sturen.

Computers leren spreken

Veel belangrijke uitvindingen zijn eerst tot stand gekomen om mensen met een beperking te helpen. Pellegrino Turrino vond de typemachine uit voor een vriendin die blind aan het worden was, zodat ze weer brieven kon schrijven. Vint Cerf stond aan de wieg van de e-mail om beter met zijn vrouw te communiceren, aangezien ze beiden slechthorend zijn. Voordat spraaksynthese ons met onze slimme apparaten liet praten, heeft de technologie ook al decennialang mensen met beperkingen geholpen.

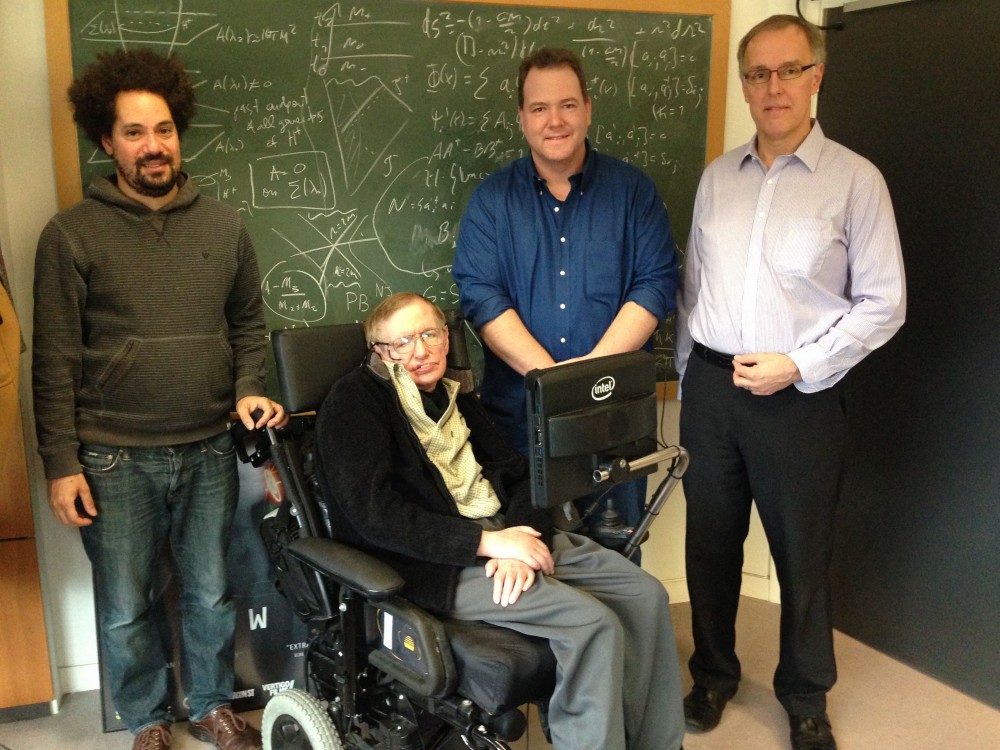

Stephen Hawking, een van de bekendste gebruikers van een spraakcomputer ("Stephen Hawking with New Computer" door Intel Free Press, CC BY 2.0)

Een van de oudste succesvolle technieken om spraak te genereren is "concatenatieve synthese", een soort knip-en-plaktechniek. Stemacteurs spreken daarbij kleine stukjes tekst apart in, die door de computer aan elkaar geplakt worden om spraak te genereren. De stukjes worden best monotoon opgenomen zodat ze beter bij elkaar passen. Dit zorgt echter expressieloze gegenereerde spraak.

De laatste jaren worden neurale netwerken vaker gebruikt voor spraaksynthese. Met deze technologie kan een computer zelf uit een groot aantal voorbeelden iets leren (bv. of er een kat op een foto staat). Als je genoeg voorbeelden van tekst met de overeenkomstige spraak aan de computer geeft, kan deze tekst op spraak leren mappen. Die mapping kan dan gebruikt worden om nieuwe spraak te genereren. Het voordeel van neurale tekst-naar-spraakmodellen is dat ze veel realistischere spraak kunnen genereren. Toch bevat de gegenereerde spraak nog vaak weinig expressie, omdat men dikwijls de monotone opnames van eerdere technieken hergebruikt als voorbeelden.

Prosodie: de sleutel tot expressieve spraak

Om expressieve spraak te genereren, hebben we dus een dataset met expressieve spraakopnames nodig. Die kunnen we bijvoorbeeld halen uit audioboeken. Dit brengt echter wel een probleem mee: een stukje tekst kan op veel verschillende manieren uitgesproken worden. De prosodie - de muzikale aspecten van spraak (zoals intonatie, klemtoon, en ritme) - wordt ook niet aangeduid in de tekst. De computer moet daarom tussen de lijntjes leren lezen en zelf een geloofwaardige prosodie verzinnen.

Om dit moeilijke probleem te verhelpen, zijn er technieken ontwikkeld om de prosodie apart te modelleren. Deze technieken stellen de prosodie dan voor als een set van parameters, die ofwel met gekende aspecten van spraak overeenkomen (bv. de toonhoogte en duur van elke klank), ofwel abstract zijn en geleerd kunnen worden door de computer. Wanneer we dan nieuwe spraak willen genereren, moeten de computers deze parameters voorspellen, op basis van de ingevoerde tekst.

Zelfs als een computer een geloofwaardige prosodie kan voorspellen, kan het nog steeds zijn dat die niet overeenkomt met wat de gebruiker in gedachten had. Daarom zou het nuttig zijn als de gebruiker de prosodie achteraf zou kunnen aanpassen. Op die manier kan zij haar boodschap overbrengen in de gewenste spreekstijl, met de gewenste nadruk, enz.

Er bestaan al technieken die het mogelijk om spraak te genereren in een bepaalde stijl, zoals die van een ander fragment. Het nadeel van deze technieken is dat ze niet gebruikt kunnen worden om de prosodie plaatselijk aan te passen. Er bestaan ook technieken die de prosodie per woord of nog fijner voorstellen, maar dan is het weer moeilijk om al deze aparte voorstellingen aan te passen om een consistente spreekstijl te krijgen. Momenteel is er geen techniek die controle over beide zaken toelaat.

ConEx: prosodie aanpassen op twee niveaus

Om controle over de spreekstijl en lokale prosodie te bieden, bedacht ik ConEx, een neuraal netwerk voor spraaksynthese, en een methode om de prosodie lokaal aan te passen. ConEx bouwt verder op FastSpeech, een neurale netwerkarchitectuur die erg snel spraak kan genereren. Dit is nodig om achteraf de prosodie interactief aan te passen. ConEx voegt twee nieuwe componenten toe aan FastSpeech om prosodie te modelleren . Het ene leert de globale spreekstijl voor te stellen, en de ander stelt de prosodie op een fijner niveau voor.

Om spraak te genereren in een bepaalde stijl, kan de gebruiker de stijl van een van de voorbeelden hergebruiken, of kan de stijl gehaald worden uit een ander spraakfragment (zoals bv. een stem uit een filmtrailer). Vervolgens wordt de fijnschalige prosodie voorspeld, en wordt er een eerste spraakfragment gegenereerd. De gebruiker kan dan de prosodie lokaal nog aanpassen. Om dit te doen, geeft ze eerst aan tot waar de prosodie in orde is. Vervolgens geeft het systeem drie slimme suggesties van mogelijke aanpassingen. Wanneer een suggestie gekozen wordt, genereert het systeem een nieuw spraakfragment, en wordt de rest van de prosodie ook opnieuw berekend, om consistente prosodie te bewaren.

Om te evalueren hoe goed het voorgestelde model erin slaagt om een spreekstijl na te bootsen, en welk effect de lokale aanpassingen hebben, werden er experimenten op twee datasets uitgevoerd. Audiofragmenten van de experimenten zijn beschikbaar op de demo webpagina.

De experimenten tonen aan dat het model in staat is om spraak in een gewenste spreekstijl te genereren. De methode om de prosodie lokaal aan te passen laat toe om de klemtoon te verleggen, en een deel sneller of trager uit te spreken. Het succes van de methode hangt wel af van welke dataset er gebruikt wordt.

Conclusie

De afgelopen jaren hebben neurale netwerken realistische spraaksynthese mogelijk gemaakt. Toch is de gegenereerde spraak vaak niet expressief en niet makkelijk te bewerken. ConEx, het ontwikkelde model, laat gebruikers toe om spraak in een bepaalde stijl te genereren, en achteraf de prosodie aan te passen. Op die manier krijgen personen met spraakbeperkingen meer controle over hun kunstmatige stem.

Bibliografie

- C. Kuang and R. Fabricant. User Friendly: How the Hidden Rules of Design are Changing the Way We Live, Work & Play. Ebury Publishing, 2019. ISBN 9780753551530. URL https://books.google.be/books?id=qM-QDAAAQBAJ.

- João Medeiros. How Intel gave Stephen Hawking a voice. Wired, jan 2015. Yi Ren, Yangjun Ruan, Xu Tan, Tao Qin, Sheng Zhao, Zhou Zhao, and Tie-Yan Liu. FastSpeech: Fast, robust and controllable text to speech. In Advances in Neural Information Processing Systems, volume 32, pages 3171–3180. Curran Associates, Inc., 2019. URL https://proceedings.neurips.cc/paper/2019/file/ f63f65b503e22cb970527f23c9ad7db1-Paper.pdf.

- RJ Skerry-Ryan, Eric Battenberg, Ying Xiao, Yuxuan Wang, Daisy Stanton, Joel Shor, Ron Weiss, Rob Clark, and Rif A. Saurous. Towards end-to-end prosody transfer for expressive speech synthesis with Tacotron. In Proceedings of the 35th International Conference on Machine Learning, volume 80 of Proceedings of Machine Learning Research, pages 4693–4702, Stockholmsmässan, Stockholm Sweden, 10–15 Jul 2018. PMLR. URL http://proceedings.mlr.press/v80/skerry-ryan18a.html.

- Aäron van den Oord, Oriol Vinyals, and Koray Kavukcuoglu. Neural discrete representation learning. In Advances in Neural Information Processing Systems, volume 30, pages 6306–6315. Curran Associates, Inc., 2017. URL https://proceedings.neurips.cc/paper/2017/file/7a98af17e63a0ac09ce2e96d03992fbc-Paper.pdf.

- G. Sun, Y. Zhang, R. J. Weiss, Y. Cao, H. Zen, A. Rosenberg, B. Ramabhadran, and Y. Wu. Generating diverse and natural text-to-speech samples using a quantized fine-grained VAE and autoregressive prosody prior. In ICASSP 2020 - 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), pages 6699–6703, 2020.

- D. Griffin and Jae Lim. Signal estimation from modified short-time fourier transform. IEEE Transactions on Acoustics, Speech, and Signal Processing, 32(2):236–243, 1984. doi: 10.1109/TASSP.1984.1164317.

- Daniel Jurafsky and James H. Martin. Speech and Language Processing (2nd Edition). Prentice-Hall, Inc., USA, 2009. ISBN 0131873210.

- Tim Capes, Paul Coles, Alistair Conkie, Ladan Golipour, Abie Hadjitarkhani, Qiong Hu, Nancy Huddleston, Melvyn Hunt, Jiangchuan Li, Matthias Neeracher, Kishore Prahallad, Tuomo Raitio, Ramya Rasipuram, Greg Townsend, Becci Williamson, David Winarsky, Zhizheng Wu, and Hepeng Zhang. Siri on-device deep learning-guided unit selection text-to-speech system. In Proc. Interspeech 2017, pages 4011–4015, 2017. doi: 10.21437/Interspeech.2017-1798. URL http://dx.doi.org/10.21437/ Interspeech.2017-1798.

- Aäron van den Oord, Sander Dieleman, Heiga Zen, Karen Simonyan, Oriol Vinyals, Alex Graves, Nal Kalchbrenner, Andrew Senior, and Koray Kavukcuoglu. WaveNet: A generative model for raw audio, 2016. Aäron van den Oord and Tom Walters. WaveNet launches in the google assistant. https: //deepmind.com/blog/article/wavenet-launches-google-assistant, October 2017. Accessed: 2021-5-1.

- Yuxuan Wang, R.J. Skerry-Ryan, Daisy Stanton, Yonghui Wu, Ron J. Weiss, Navdeep Jaitly, Zongheng Yang, Ying Xiao, Zhifeng Chen, Samy Bengio, Quoc Le, Yannis Agiomyrgiannakis, Rob Clark, and Rif A. Saurous. Tacotron: Towards end-to-end speech synthesis. In Proc. Interspeech 2017, pages 4006–4010, 2017. URL http: //dx.doi.org/10.21437/Interspeech.2017-1452.

- Jonathan Shen, Ruoming Pang, Ron J. Weiss, Mike Schuster, Navdeep Jaitly, Zongheng Yang, Zhifeng Chen, Yu Zhang, Yuxuan Wang, RJ-Skerrv Ryan, Rif A. Saurous, Yannis Agiomyrgiannakis, and Yonghui Wu. Natural TTS synthesis by conditioning WaveNet on mel spectrogram predictions. In 2018 IEEE International Conference on Acoustics, Speech and Signal Processing, ICASSP 2018, Calgary, AB, Canada, April 15-20, 2018, pages 4779–4783. IEEE, 2018. doi: 10.1109/ICASSP.2018.8461368. URL https://doi.org/10.1109/ICASSP.2018.8461368.

- Ilya Sutskever, Oriol Vinyals, and Quoc V. Le. Sequence to sequence learning with neural networks. In Proceedings of the 27th International Conference on Neural Information Processing Systems - Volume 2, NIPS’14, pages 3104–3112, Cambridge, MA, USA, 2014. MIT Press.

- Kyunghyun Cho, Bart van Merriënboer, Caglar Gulcehre, Dzmitry Bahdanau, Fethi Bougares, Holger Schwenk, and Yoshua Bengio. Learning phrase representations using RNN encoder–decoder for statistical machine translation. In Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP), pages 1724–1734, Doha, Qatar, October 2014. Association for Computational Linguistics. doi: 10.3115/v1/D14-1179. URL https://www.aclweb.org/anthology/D14-1179.

- Sepp Hochreiter and Jürgen Schmidhuber. Long Short-Term Memory. Neural Computation, 9(8):1735–1780, 11 1997. ISSN 0899-7667. doi: 10.1162/neco.1997.9.8.1735. URL https://doi.org/10.1162/neco.1997.9.8.1735.

- Dzmitry Bahdanau, Kyunghyun Cho, and Yoshua Bengio. Neural machine translation by jointly learning to align and translate, 2014. 66 BIBLIOGRAPHY Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Łukasz Kaiser, and Illia Polosukhin. Attention is all you need. In Advances in Neural Information Processing Systems, volume 30, pages 5998–6008. Curran Associates, Inc., 2017. URL https://proceedings.neurips.cc/paper/2017/file/ 3f5ee243547dee91fbd053c1c4a845aa-Paper.pdf.

- Yi Ren, Chenxu Hu, Xu Tan, Tao Qin, Sheng Zhao, Zhou Zhao, and Tie-Yan Liu. FastSpeech 2: Fast and high-quality end-to-end text to speech, 2020. Michael McAuliffe, Michaela Socolof, Sarah Mihuc, Michael Wagner, and Morgan Sonderegger. Montreal Forced Aligner: Trainable text-speech alignment using kaldi. In Proc. Interspeech 2017, pages 498–502, 2017. doi: 10.21437/Interspeech.2017-1386. URL http://dx.doi.org/10.21437/Interspeech.2017-1386.

- Kim Silverman, Mary Beckman, John Pitrelli, Mari Ostendorf, Colin Wightman, Patti Price, Janet Pierrehumbert, and Julia Hirschberg. ToBI: A standard for labeling english prosody. 01 1992.

- Yuxuan Wang, Daisy Stanton, Yu Zhang, R. J. Skerry-Ryan, Eric Battenberg, Joel Shor, Ying Xiao, Fei Ren, Ye Jia, and Rif A. Saurous. Style tokens: Unsupervised style modeling, control and transfer in end-to-end speech synthesis. CoRR, abs/1803.09017, 2018. URL http://arxiv.org/abs/1803.09017.

- Ya-Jie Zhang, Shifeng Pan, Lei He, and Zhen-Hua Ling. Learning latent representations for style control and transfer in end-to-end speech synthesis. CoRR, abs/1812.04342, 2018. URL http://arxiv.org/abs/1812.04342.

- Wei-Ning Hsu, Yu Zhang, Ron J. Weiss, Heiga Zen, Yonghui Wu, Yuxuan Wang, Yuan Cao, Ye Jia, Zhifeng Chen, Jonathan Shen, Patrick Nguyen, and Ruoming Pang. Hierarchical generative modeling for controllable speech synthesis. CoRR, abs/1810.07217, 2018. URL http://arxiv.org/abs/1810.07217.

- Isaac Elias, Heiga Zen, Jonathan Shen, Yu Zhang, Ye Jia, Ron J. Weiss, and Yonghui Wu. Parallel tacotron: Non-autoregressive and controllable TTS. CoRR, abs/2010.11439, 2020. URL https://arxiv.org/abs/2010.11439.

- Younggun Lee and Taesu Kim. Robust and fine-grained prosody control of end-to-end speech synthesis. CoRR, abs/1811.02122, 2018. URL http://arxiv.org/abs/1811. 02122.

- Guangyan Zhang, Ying Qin, and Tan Lee. Learning Syllable-Level Discrete Prosodic Representation for Expressive Speech Generation. In Proc. Interspeech 2020, pages 3426–3430, 2020. doi: 10.21437/Interspeech.2020-2228. URL http://dx.doi.org/ 10.21437/Interspeech.2020-2228.

- Guangzhi Sun, Heiga Zen, Ron J. Weiss, Yonghui Wu, Yu Zhang, and Yuan Cao. Fullyhierarchical fine-grained prosody modeling for interpretable speech synthesis. In ICASSP, 2020.

- Chung-Ming Chien and Hung-Yi Lee. Hierarchical prosody modeling for nonautoregressive speech synthesis, 2021.

- Tuomo Raitio, Ramya Rasipuram, and Dan Castellani. Controllable neural text to-speech synthesis using intuitive prosodic features. Interspeech 2020, Oct 2020. doi: 10.21437/interspeech.2020-2861. URL http://dx.doi.org/10.21437/ interspeech.2020-2861.

- Adrian Łancucki. FastPitch: Parallel text-to-speech with pitch prediction, 2021. ´ Yuxuan Wang and RJ Skerry-Ryan. Expressive speech synthesis with tacotron. https: //ai.googleblog.com/2018/03/expressive-speech-synthesis-with.html, March 2018. Accessed: 2021-5-5.

- Diederik P. Kingma and M. Welling. Auto-encoding variational Bayes. CoRR, abs/1312.6114, 2014. Gustav Eje Henter, Jaime Lorenzo-Trueba, Xin Wang, and Junichi Yamagishi. Deep encoder-decoder models for unsupervised learning of controllable speech synthesis, 2018.

- Jennifer Williams and Simon King. Disentangling Style Factors from Speaker Representations. In Proc. Interspeech 2019, pages 3945–3949, 2019. doi: 10.21437/Interspeech. 2019-1769. URL http://dx.doi.org/10.21437/Interspeech.2019-1769.

- Jaan Altosaar. Tutorial - What is a Variational Autoencoder?, August 2016. URL https: //doi.org/10.5281/zenodo.4462916.

- Laurens van der Maaten and Geoffrey Hinton. Visualizing data using t-SNE. Journal of Machine Learning Research, 9(86):2579–2605, 2008. URL http://jmlr.org/ papers/v9/vandermaaten08a.html.

- Adam Paszke, Sam Gross, Francisco Massa, Adam Lerer, James Bradbury, Gregory Chanan, Trevor Killeen, Zeming Lin, Natalia Gimelshein, Luca Antiga, Alban Desmaison, Andreas Kopf, Edward Yang, Zachary DeVito, Martin Raison, Alykhan Tejani, Sasank Chilamkurthy, Benoit Steiner, Lu Fang, Junjie Bai, and Soumith Chintala. Pytorch: An imperative style, high-performance deep learning library. In H. Wallach, H. Larochelle, A. Beygelzimer, F. d'Alché-Buc, E. Fox, and R. Garnett, editors, Advances in Neural Information Processing Systems 32, pages 8024– 8035. Curran Associates, Inc., 2019. URL http://papers.neurips.cc/paper/ 9015-pytorch-an-imperative-style-high-performance-deep-learning-library. pdf.

- Tomoki Hayashi, Ryuichi Yamamoto, Katsuki Inoue, Takenori Yoshimura, Shinji Watanabe, Tomoki Toda, Kazuya Takeda, Yu Zhang, and Xu Tan. Espnet-TTS: Unified, reproducible, and integratable open source end-to-end text-to-speech toolkit. In Proceedings of IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), pages 7654–7658. IEEE, 2020.

- A.K Subramanian. PyTorch-VAE. https://github.com/AntixK/PyTorch-VAE, 2020.

- Simon King and Vasilis Karaiskos. The Blizzard Challenge 2013. In Proceedings Blizzard Workshop 2013, September 2013.

- Diederik P. Kingma and Jimmy Ba. Adam: A method for stochastic optimization, 2014.

- Lukasz Kaiser, Aurko Roy, Ashish Vaswani, Niki Parmar, Samy Bengio, Jakob Uszkoreit, and Noam Shazeer. Fast decoding in sequence models using discrete latent variables. CoRR, abs/1803.03382, 2018. URL http://arxiv.org/abs/1803.03382.

- Noé Tits. Controlling the Emotional Expressiveness of Synthetic Speech - a Deep Learning Approach. PhD thesis, 12 2020.

- R. Kubichek. Mel-cepstral distance measure for objective speech quality assessment. In Proceedings of IEEE Pacific Rim Conference on Communications Computers and Signal Processing, volume 1, pages 125–128 vol.1, 1993. doi: 10.1109/PACRIM.1993.407206.

- Ryuichi Yamamoto, Eunwoo Song, and Jae-Min Kim. Parallel WaveGAN: A fast waveform generation model based on generative adversarial networks with multi-resolution spectrogram. In ICASSP 2020 - 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), pages 6199–6203, 2020. doi: 10.1109/ICASSP40776. 2020.9053795.

- Heiga Zen, Rob Clark, Ron J. Weiss, Viet Dang, Ye Jia, Yonghui Wu, Yu Zhang, and Zhifeng Chen. Libritts: A corpus derived from LibriSpeech for text-to-speech. In Interspeech, 2019. URL https://arxiv.org/abs/1904.02882.

- Kundan Kumar, Rithesh Kumar, Thibault de Boissiere, Lucas Gestin, Wei Zhen Teoh, Jose Sotelo, Alexandre de Brebisson, Yoshua Bengio, and Aaron Courville. Melgan: Generative adversarial networks for conditional waveform synthesis, 2019.