“Dromen computers over neurale bomen?”, een nieuwe techniek voor het begrijpen van slimme algoritmen en hoe ze denken.

Introductie

“AI is de laatste uitvinding die de mensheid ooit nog zal moeten maken. ” Een uitspraak van Oxford filosoof Nick Bostrom waarbij de toekomstige potentie van slimme computers en zelflerende algoritmen (ook wel Artificiële Intelligentie genoemd) wordt aangehaald als de oplossing tot alle problemen die we vandaag de dag hebben. Een prachtig voorbeeld van vooruitgangsoptimisme dat wel inhoudt dat de AI die we creëren “gehoorzaam” is aan onze wil. Skynet uit de Terminator, HAL 9000 uit 2001: A Space Odyssey en Ultron uit The Avengers zijn voorbeelden van bloeddorstige AI’s wiens doel het is de mensheid uit te roeien of het toch zeer onaangenaam te maken. Hollywood heeft nog vele voorbeelden van deze verschikkelijke machines, maar voor elke kwaadaardige Ultron is er ook een vriendelijke WALL.E die uiteindelijk de mensheid redt. Voor elke moordende Terminator een helpende CHAPPiE die leert wat het is om gevoelens te hebben zoals wij. Wanneer we op het punt zouden staan de volgende revolutionaire AI te ontwikkelen, moeten we deze ook kunnen het concept van menselijke moraliteit aanleren: wat is slecht en wat is goed. Als ontwikkelaar van zulke systemen is het onmisbaar te verstaan wat er precies in het digitale brein van de AI omgaat en hoe het precies denkt. Hoe dan ook, dit is makkelijker gezegd dan gedaan.

Een glimp in de zwarte doos

AI heeft zich reeds een weg gebaand in vele producten en diensten die we vandaag de dag gebruiken, met potentieel intrede in vele andere toepassingen in de nabije toekomst. Van het voospellen van tumors in het lichaam tot het besturen van een auto. Je persoonlijke voice assistent op je telefoon tot het overtreffen van menselijke tegenstanders in spellen zoals schaken, go en StarCraft. Eén van de meest geavanceerde manieren om een computer iets aan te leren, ook wel Machine Learning genoemd, is door een computationeel model van het menselijk brein te simuleren. Dit digitale brein wordt vaardigheden aangeleerd op een gelijkaardige manier als het trainen van een huisdier door het te belonen wanneer het iets correct doet (het verrichten van de gevraagde taak) en het te straffen wanneer het niet gehoorzaam is. Door dit proces meermaals te herhalen zal de AI uiteindelijk leren wat juist is en wat fout is, resulterend in het gewenste gedrag. Maar net zoals we nog niet volledig begrijpen hoe het menselijk brein werkt, kunnen we niet verstaan hoe de digitale versie denkt. Dit wordt vaak het probleem van de zwarte doos genoemd.

Binnen het gebied van Artificiële Intelligentie is er een recente focus op het interpreteren van deze digitale breinmodellen. De bedoeling is om de zwarte dozen op zijn minst deels verstaanbaar te maken voor een ervaren gebruiker of om zinvolle verklaringen eruit te genereren. Wanneer de AI een motivatie heeft waarom het in een bepaalde manier handelde, kan de gebruiker deze aansturen en verbeteren. Dit geeft een verhoogd niveau van controle over de AI waardoor het vertrouwen erin aanzienlijk toeneemt. Gemaakte uitleg kan ook helpen met het aanpassen van het leerprocess door een ontwikkelaar zodat de AI sneller kan leren.

Een bewezen methode om AI meer begrijpbaar te maken is door een complex model te trainen en deze dan een kleiner, simpeler model iets aan te laten leren. Dit is analoog met de manier een leerkracht of docent een student nieuwe kennis aanleert. Het “leerkracht” model is een versie van het digitale brein en het simpeler “student” model kan voorgesteld worden als een simpele set regels die beschrijven wat de AI moet doen. Deze regels, uitgedrukt in simpele formules, zijn meer interpreteerbaar voor de gebruiker.

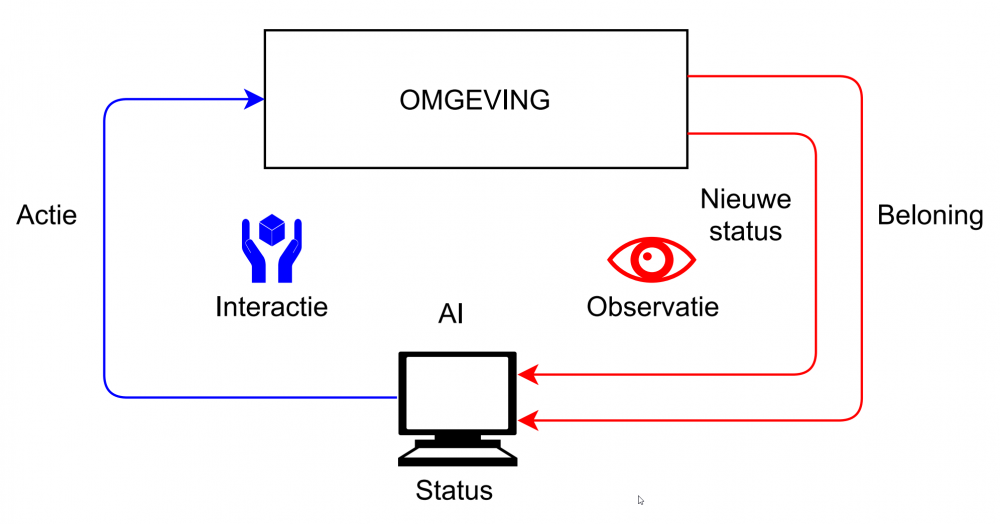

Fig. 1: Het leerproces van een digitaal brein in een bepaalde status. Het voert een actie uit in een omgeving waarna het een nieuwe status terecht komt samen met een beloning hoe goed zijn actie was in de vorige status.

Slimme brein bomen

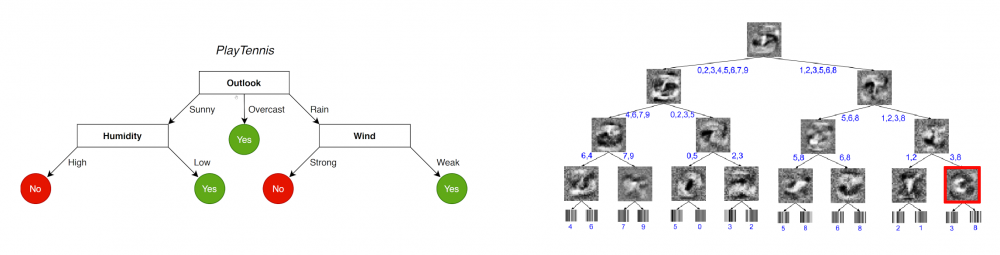

Recent academisch werk maakte gebruik van beslissingsbomen voor de studentmodellen, wat verassende resultaten opleverde. Een beslissingsboom is een structuur vergelijkbaar met een stamboom. In elke ouderknoop van de boom wordt een bepaalde beslissing gemaakt die bepaalt naar welke onderliggende kinderknoop wordt voortgegaan. Deze procedure wordt uitgevoerd vanaf de bovenste knoop, ook wel de wortelknoop genoemd, helemaal tot beneden in de bladerknopen die zelf geen onderliggende kinderknopen hebben. Deze laatste knopen bepalen dan het gedrag van het model.

De beslissingen die gemaakt worden in de knopen kunnen simpele formules of regels zijn (zoals een ja-neen vraag), maar wanneer we ze vervangen door kleine brein modellen kunnen we ingewikkeldere beslissingen nemen. Deze mini-breinen zijn veel minder complex dan de originele leerkrachtmodellen en kunnen met een simpele visualisatietechniek weergeven waarop ze zich focussen als ze een beslissing maken. Bomen die gebruik maken van deze vereenvoudigde breinen worden ook wel neurale bomen genoemd.

Fig 2: Links, een voorbeeld van een beslissingsboom. Rechts, een neurale boom.

Maar bomen groeien toch, neen?

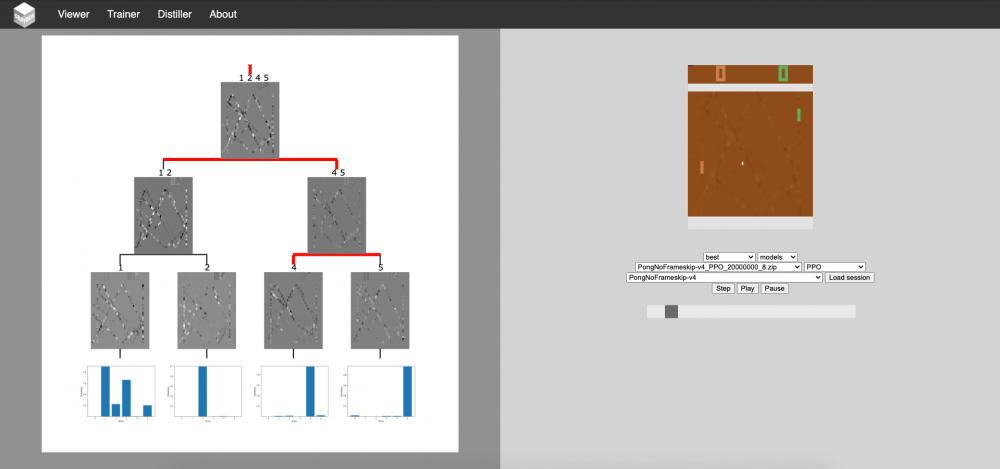

Het doel van de thesis was om te vertrekken van de leerkracht-student methode, samen met de neurale bomen, om een AI simpele Atari spelletjes te leren spelen. Deze computerspellen zijn een veelgebruikte methode om te testen hoe goed een AI op zichzelf kan leren.

Het probleem met de originele neurale bomen is dat ze vastgelegd worden in de computer alvorens ze getrained worden. De gebruiker weet niet op voorhand wat de optimale structuur (hoogte, complexiteit en aantal beslissingen) is waardoor de AI misschien minder goed zou werken. Een mogelijke oplossing is om de samenstelling van de boom te leren terwijl we de AI zelf traininen. Uit de thesis konden we concluderen dat het gebruik van deze adaptieve bomen kleinere modellen opleverde waardoor de AI sneller en beter kan leren. Sommige gedragingen in spelletjes met vijanden (zoals Pac-Man met de geesten) zijn een duidelijke indicatie dat de AI bewust is van gevaren in het spel.

We halen aan dat de gebruikte techniek ook in robotica en mechatronische systemen toepasbaar is waardoor toekomstige AI zou gezien worden als een begrijpelijke metgezel inplaats van het ongekende gevaarte sommige media doet vermoeden.

Fig 3: Onze adaptieve bomen in actie.